はじめに

Apache Sparkは、ビッグデータ処理に強力なフレームワークであり、大規模なデータの分析や処理を効率的に行うことができます。本記事では、Google Colabを利用して、Sparkを使った基本的なデータ処理の手順を解説します。初心者でも実際に試して学べるよう、コードサンプルとその解説を提供します。

1. Google ColabでのPySparkのセットアップ

まず、Google ColabでPySparkを使用するためには、PySparkをインストールする必要があります。以下のコードをGoogle Colabのセルにコピーして実行してください。

!pip install pyspark

このコマンドを実行することで、Google Colab上にPySparkがインストールされます。

2. Google Driveとの接続

Google Drive上のファイルにアクセスしたり、結果を保存したりするためには、Google DriveとColabを接続する必要があります。以下のコードを実行して、Google Driveをマウントしてください。

from google.colab import drive

drive.mount('/content/drive')

このコードを実行すると、Googleアカウントへのアクセスを許可するための認証が求められます。認証が完了すると、/content/driveにGoogle Driveがマウントされ、ファイルの読み書きが可能になります。

3. SparkSessionの初期化

PySparkをインストールしたら、次にSparkSessionを初期化します。SparkSessionは、Sparkアプリケーションのエントリーポイントであり、データの読み込み、処理、保存を行うための主要なインターフェースです。

from pyspark.sql import SparkSession

# SparkSessionの作成

spark = SparkSession.builder \# メソッドチェーンで複数のメソッドを続けて呼び出します

.appName("MySparkApp") \# ピリオドで前のメソッドチェーンとの継続を示します

.getOrCreate()

このコードを詳しく説明すると:

SparkSession.builder は、SparkSessionを構築するためのビルダーオブジェクトを取得します。

.appName("MySparkApp") は、このビルダーオブジェクトに対して、アプリケーション名を設定します。

.getOrCreate() は、既存のSparkSessionを取得するか、存在しない場合は新しいSparkSessionを作成します。

このコードにより、Sparkのセッションが開始され、これ以降のデータ処理操作が可能になります。

4. サンプルデータの作成

次に、サンプルデータを作成します。以下のコードは、簡単なデータセットを作成し、それをデータフレームとして表示します。また、CSVファイルからデータを読み込む場合のコードもコメントアウトして記載していますので、必要に応じて切り替えて使用できます。

# サンプルデータの作成

data = [

("Alice", 1, "2023-01-01"),

("Bob", 2, "2023-01-02"),

("Cathy", 3, "2023-01-03"),

("David", 4, "2023-01-04"),

("Eva", 5, "2023-01-05"),

("Frank", 6, "2023-01-06"),

("Grace", 7, "2023-01-07"),

("Helen", 8, "2023-01-08"),

("Ivy", 9, "2023-01-09"),

("Jack", 10, "2023-01-10")

]

columns = ["Name", "Value", "Date"]

# DataFrameの作成

df = spark.createDataFrame(data, columns)

# CSVファイルからデータを読み込む場合のコード(コメントアウト)

# df = spark.read.csv("/content/drive/My Drive/input.csv", header=True, inferSchema=True)

# データの表示

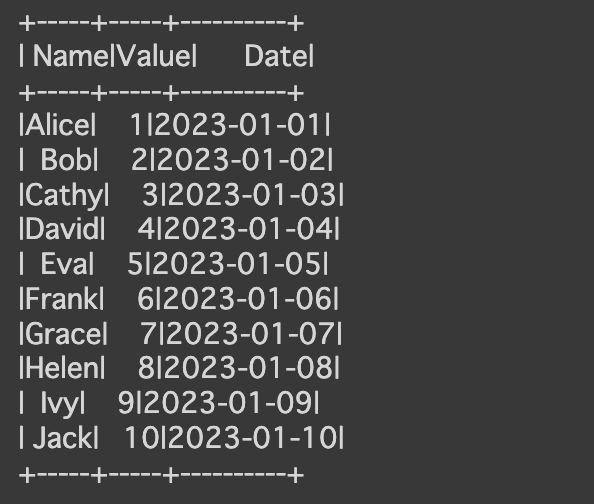

df.show()

上記のコードで作成したデータフレームは、名前、値、日付の3列を持ちます。これを元に、様々なデータ処理を行います。

5. データの操作

次に、作成したデータに対して、いくつかの基本的な操作を行います。ここでは、列の選択、フィルタリング、集計などの操作を紹介します。

# 特定の列を選択

df_selected = df.select("Name", "Value")

df_selected.show()

# 条件に基づくフィルタリング

df_filtered = df.filter(df["Value"] > 5)

df_filtered.show()

# データのグループ化と集計

df_grouped = df.groupBy("Name").count()

df_grouped.show()

-

select: 特定の列を選択する際に使用します。 -

filter: 条件に基づいてデータをフィルタリングします。 -

groupBy: データを指定した列でグループ化し、その後に集計操作(例:count)を行います。

6. データの保存

データ処理が完了したら、結果をファイルに保存することができます。以下のコードは、フィルタリングされたデータをCSVファイルとして保存する例です。

# データの保存

# CSVファイルにデータを保存する場合のコード

# df_filtered.write.csv("/content/drive/My Drive/output.csv", header=True)

このコードを使用することで、フィルタリングされたデータをCSV形式でGoogle Driveに保存できます。

7. SparkSessionの終了

作業が完了したら、SparkSessionを終了してリソースを解放します。

spark.stop()

これで、Sparkを使った基本的なデータ処理が完了します。

まとめ

この記事では、Google Colaboratoryを使ってApache Sparkの基本的な役割とデータ処理の手順を解説しました。基本的な操作をマスターすれば、より高度なデータ処理や分析に進むための基礎が築けます。次のステップとして、さらに複雑なデータ処理や機械学習のためのSparkの機能を学んでいきましょう。