そのうち製品チームから公開されるはずなのだけど、機能としては展開済みになっていたので使ってみたよという話。Power BI データフローでは Azure Data Lake Storage Gen2 + Common Data Model フォルダが採用されているのだけど、Common Data Model のメタデータである JSON ファイル(model.json)、つまりCommon Data Model フォルダの構成を知るものをインポートすることで、Power BI データフローを構成することも可能になったということでよいかと思う。

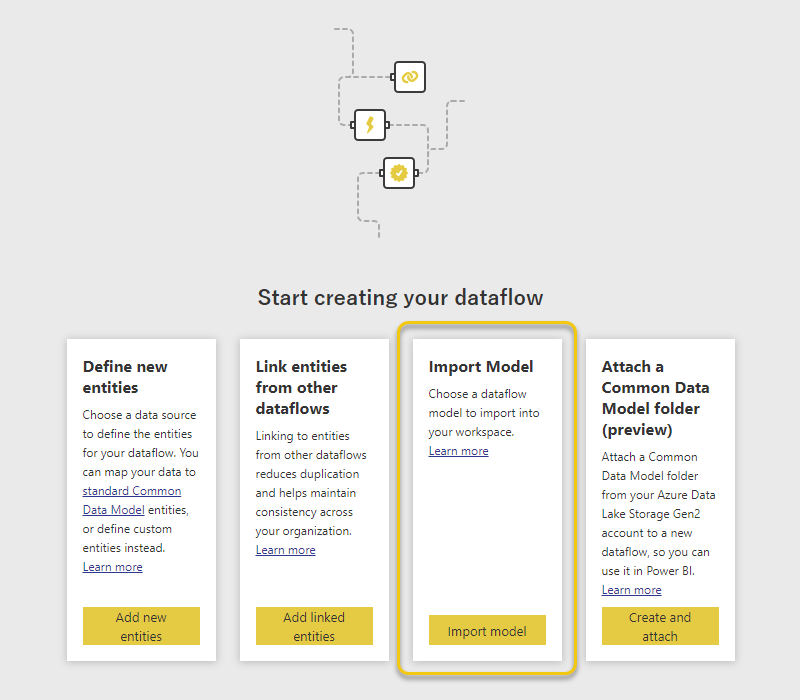

操作自体はいたってシンプル

モデルをインポート

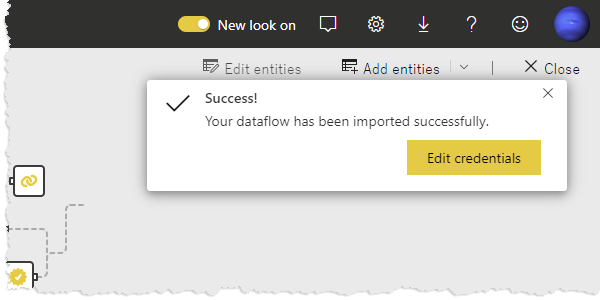

インポートが成功したらデータソースの資格情報を設定して、

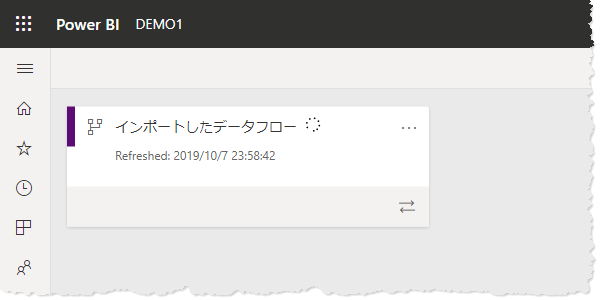

初回のリフレッシュ

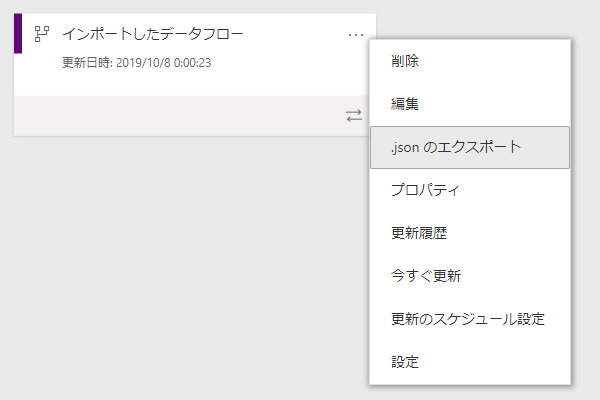

ほとんどの場合、すでに配置されたPower BI データフローから メタデータファイルをエクスポートする感じでしょう。

どんなフォーマットなのか?はThe metadata file (model.json) for the Common Data Modelに書いてある通り。

メタデータですからデータ本体は含まれないし資格情報も含まれない。何が含まれるかは実際に見てみても複雑なものではないから理解できるはず。Power Query と エンティティ情報(列名やデータ型)、実体となる CSV ファイルのURLとかですよね。

思ったこと🙄

モデルのインポートにあまり関係ないけれども。今のところ Power Query Online と Power BI Desktop の Power Query エディタ、これらには Common Data Model フォルダをサポートするコネクタがある。なので特段の準備なくPower BI データフローからデータを取得できる。

サポートするコネクタがない場合とか Azure Data Lake Storage Gen2 のCommon Data Model フォルダを直接見に行かなければならないとき、エンティティの情報 / CSV のURL / パーティションとかを model.json から読み解かなければならんのよね。