Google Assistant SDKの「アクション」を使ってRaspberry Piから写真を撮れるようにしてみました。こんな感じです。

Raspberry Pi Camera Actions on Google - YouTube

GoogleAssistantから「アクション(ここではSamantha)」を呼び出し、「インテント(意図)」により写真を撮影しています。画像はこんな感じで保存されています。

これ自体はどうということもないのですが、顔認識や画像認識と組み合わせることも可能だと思いますのでちょっとまとめてみます。

環境

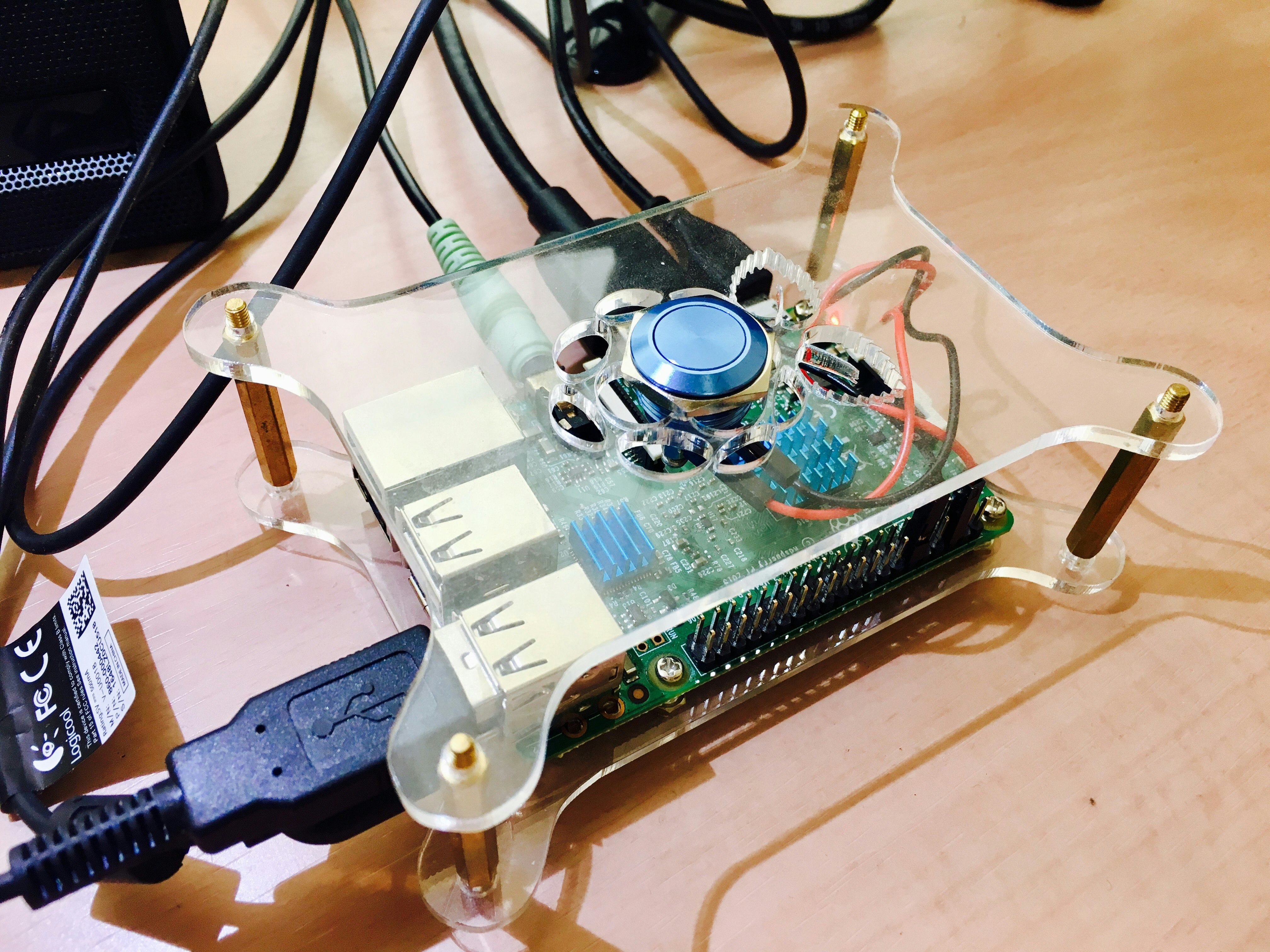

環境は前回記事と同じです。

Actions on Google

大まかな流れは前回記事でまとめました。

Google Assistantのアクション(要は音声アプリですね)はIFTTTを使って簡易的に行うことも出来るのですが、細かい音声コマンドの指定や、APIなどを利用した音声での返答は、Actions on Googleと名付けられた開発者ツールを使用します。

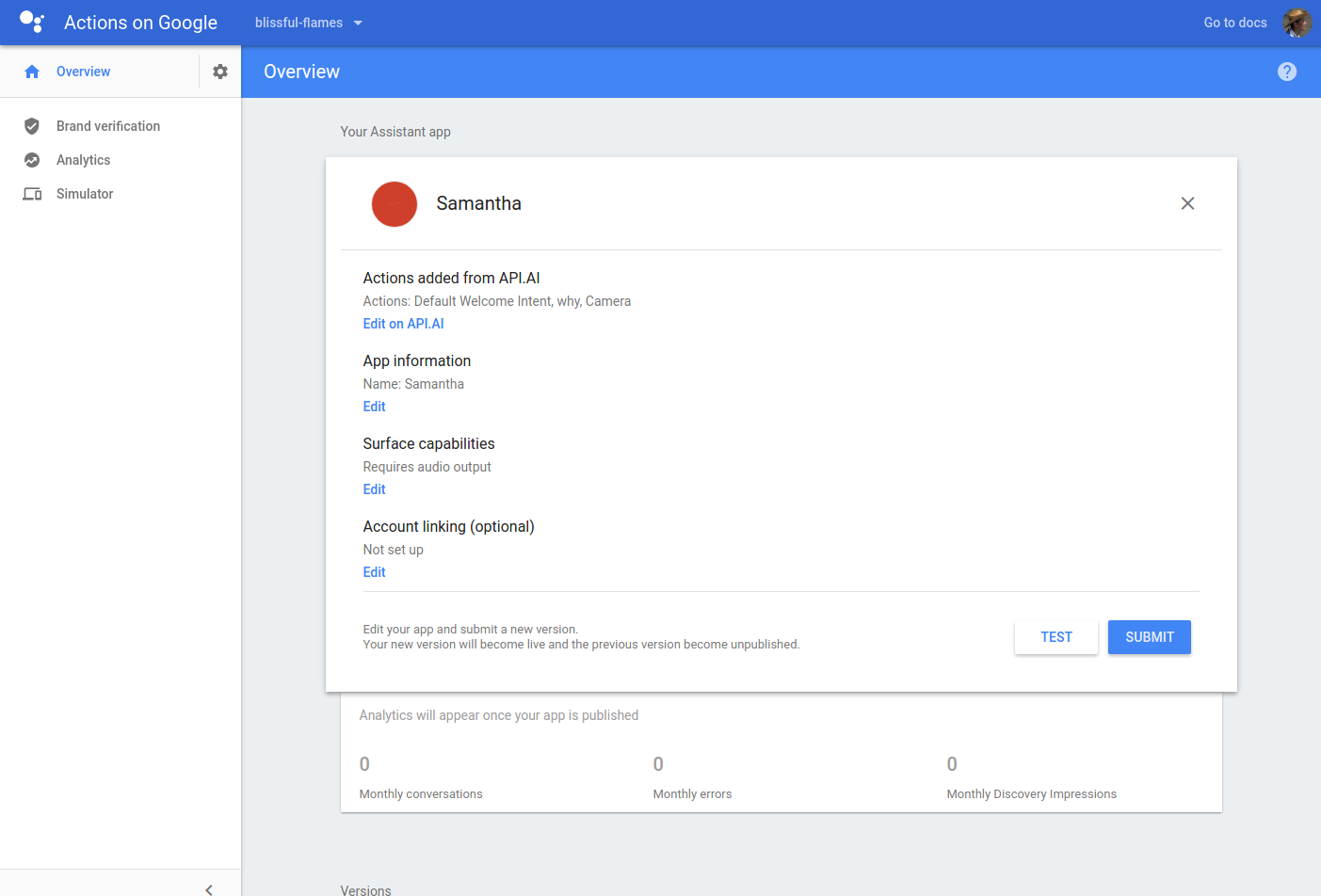

管理画面はこんな感じです。シミュレータもここから起動させることが出来ます。

ポイントになるのは、音声認識→音声発話の処理を「Google Cloud Functions」を使っていることです。「Google Cloud Functions」に関しては以下の記事でまとめられています。

【翻訳記事】Google Cloud Functions 対 AWS Lambda: サーバーレスクラウドを制する闘いが始まる - Qiita

調べてみると比較的新しいサービスのようです。AWS Lambdaに対抗して作られた、イベントで駆動するサーバレスアーキテクチャーとのこと。今のところライブラリはNode.jsのみ提供されています。

今回は音声コマンドを使って写真を撮り、実行後の戻り値をGoogle Assistantに返答させてみようと考えました。(わざわざ戻り値を返信させるのは、画像認識結果を返信させるテストの為です)

RaspberryPiはIFTTTでやった時と同じようにWebhookを利用すれば動作させられるはずです。調べたらサンプルレポジトリが公開されていましたのでこちらを利用して動作させます。

actions-on-google/apiai-webhook-template-nodejs - GitHub

やってみる

詳しくは公式ページの「Get started」に沿ってやっていきました。

Get started - Actions on Google

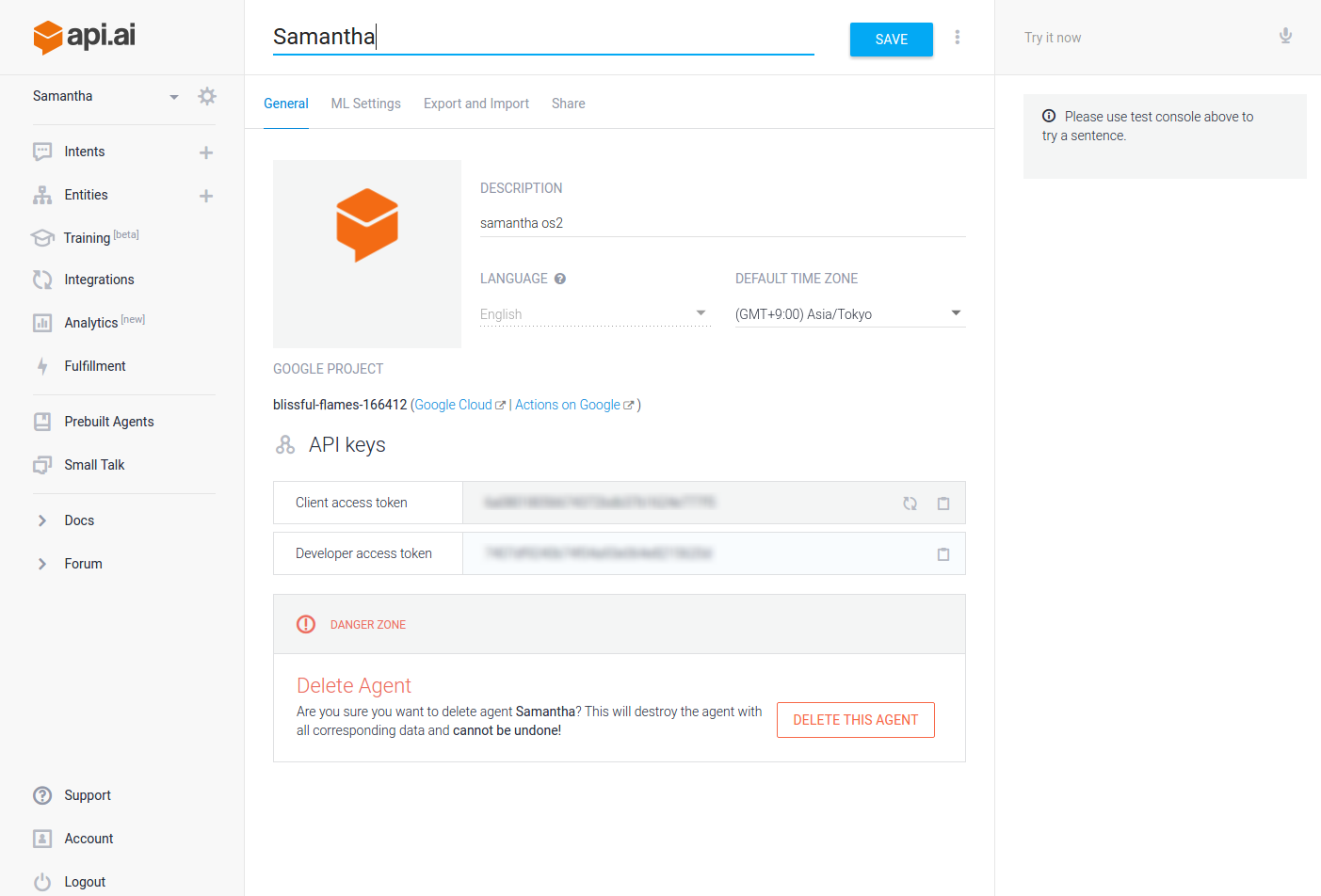

会話部ははAPI.aiを利用します。「エージェント」名は某映画の人工知能と同じ「Samantha」とつけてみました。

この「エージェント」の「インテント」で「Say Cheese」と話しかけると「Google Cloud Functions」にWebhookを送信し、イベント駆動させます。

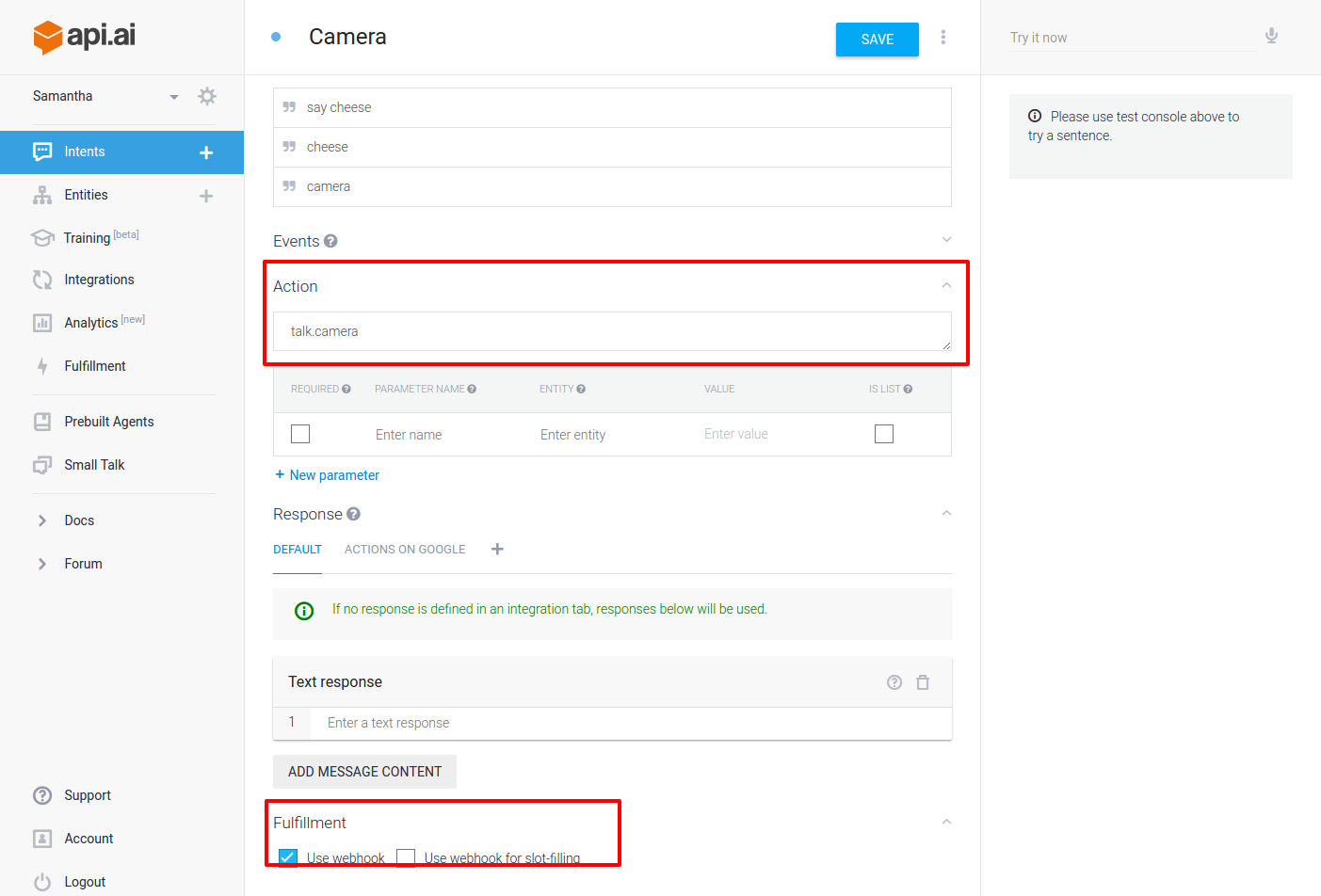

名前が同じでちょっと分かりづらいのですが「インテント」の中で「Action」の項目があるので、そこにした名前をWebhookで受け取ります。(ここではtalk.camera)

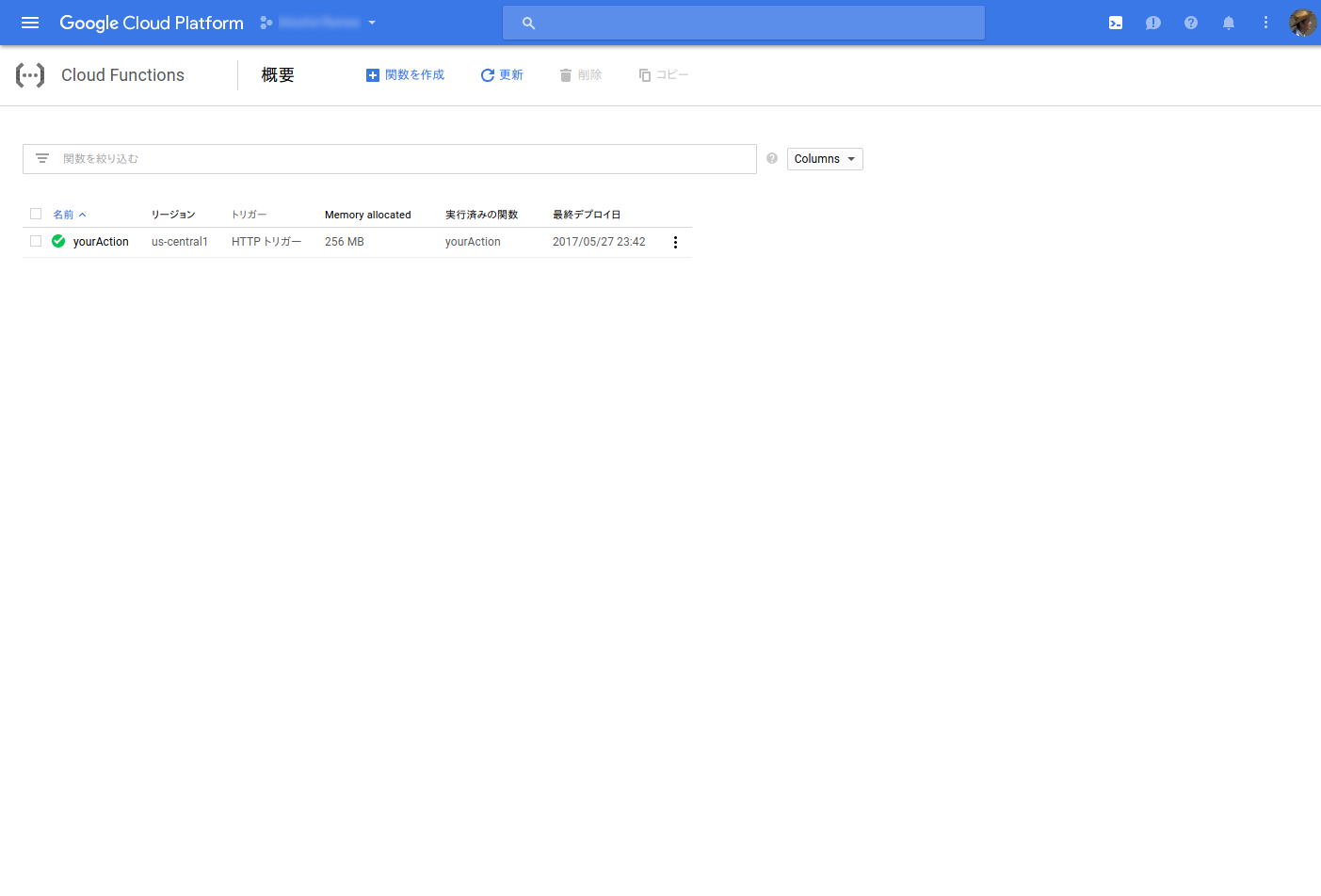

「Cloud Functions」のアクション名はここではyourActionになります。ちょっと分かりづらいので注意が必要です。

「Google Cloud Functions」の中身はこんな風に記述してみました。

'use strict';

process.env.DEBUG = 'actions-on-google:*';

const App = require('actions-on-google').ApiAiApp;

const exec = require('child_process').exec;

const adress = "https://xxxxxxx.ap.ngrok.io/camera"

// [START YourAction]

exports.yourAction = (request, response) => {

const app = new App({request, response});

console.log('Request headers: ' + JSON.stringify(request.headers));

console.log('Request body: ' + JSON.stringify(request.body));

// Fulfill action business logic

function responseHandler (app) {

// Complete your fulfillment logic and send a response

exec(`curl ${adress}`, (error, stdout, stderr) => {

if (error) {

console.error(`exec error: ${error}`);

return;

}

console.log(`${stdout}`);

app.ask(`<speak>I took your picture. <break time='1' /></speak>` + `${stdout}`);

});

}

const actionMap = new Map();

actionMap.set('talk.camera', responseHandler);

app.handleRequest(actionMap);

};

// [END YourAction]

API.aiから送付したリクエストを元に処理を行い、GoogleAssistantへレスポンスを返します。

ここではリクエストを受けとった際、Curlコマンドを利用してRaspberryPiに立てたローカルサーバー(ここではhttps://xxxxxxx.ap.ngrok.io/camera)へ更にWebhookを送信させています。

RaspberryPiのレスポンスはchild_processの${stdout}で受け取ることが出来、戻り値を発話させることが出来ています。

RaspberryPiで立てたローカルサーバーはこんな感じです。

from flask import Flask

from flask import request, jsonify

import json

import numpy as np

import cv2

import subprocess

import time

app = Flask(__name__)

@app.route('/camera')

def camera():

cap = cv2.VideoCapture(0)

cap.set(3, 760)

cap.set(4, 480)

while(True):

ret, frame = cap.read()

cv2.imshow('frame', frame)

subprocess.call( ["aplay", "camera.wav"] )

time.sleep(0.5)

cv2.imwrite("sample.png", frame)

text = "cool"

break

cap.release()

cv2.destroyAllWindows()

return text

if __name__ == '__main__':

app.run(host="127.0.0.1", port=8080)

Google Assistant SDKが仮想環境からでないと起動しなくなったので、同じフォルダenv内にOpenCVを入れ直しました。ローカルサーバーはFlaskで立て、エンドポイントにリクエストが来るとカメラで撮影し(ついでにシャッター音を再生させました)保存します。

return textで戻り値を返信できるので、Kerasを使って画像認識させ、戻り値を返信させるのも可能だと思います。

※Google Assistantの返信の待ち受け時間は5秒位の様です。画像認識させるにはその間にさせなければなりません。(RaspberryPiだと処理が遅いのでちょっと厳しいかも。ここら辺もクラウドを使った方が良いのでしょうか...。)

ローカルサーバーはngrokを利用してグローバルアドレスで接続出来る様にしておきます。

まとめ

今度は物体認識とか顔認識を試してみたいと思います。

正直かなり面倒くさいんですけど、GoogleAssistantの切れのある返信は魅力的です(ヘタするとこちらが言い終わると同時に即レスを返信してきます)。ではまた。