様々なWebスクレイピングツールが存在しますが、すべてのツールが非プログラマー向けというわけではありません。この記事では、初心者向けに無料で利用できるWebスクレイピングツールをご紹介します。

ソフトウェア型

1. Octoparse

Octoparseは、個人や企業にもデータ抽出サービスを提供する日本語スクレイピングツールです。ソーシャルメディア、Eコーマス、マーケティング、営業リストなどの情報やデータを抽出できます。単純なHTML構造でのみコンテンツをスクレイピングするWebスクレーパーとは異なり、OctoparseはAJAX、JavaScript、cookieなどを利用している静的および動的Webサイトの両方を処理でき、ログインが必要なサイトなどの複雑なWebサイトにも対応できます。Octoparseはソースコードを解析することによってWebサイトに表示されていない情報を扱うことさえできます。

Octoparseはクラウドサービスも提供しています。クラウドサービスは、複数のクラウドサーバーが同時に1つのタスクを実行するため、短時間で膨大な量のデータを抽出することができます。また、必要に応じて、定期実行のスケジュールも設定することもできます。

それに、初心者に向けのクローラーテンプレートもたくさん提供しています。タスクテンプレートを使うと、パラメータ(ターゲットページのURL、検索キーワードなど)を入力するだけで、データがどんどん抽出されてきます。取得したデータをCSV、Excel、またはデータベースなどの構造化フォーマットとして保存できます。

2. ParseHub

Parsehubは、Octoparseと同じ、AJAX、JavaScript、Cookieなどを使用するWebサイトからのデータ収集をサポートする優れたWebスクレイピングツールです。Parsehubは、Webドキュメントを読み取り、分析し、関連データに変換することができる機械学習テクノロジを利用します。URL指定とスクレイピングしたい箇所を選択するだけで、スクレイピングを実行します。

Parsehubは、Windows、Mac OS X、およびLinuxなどのシステムをサポートしています。またはブラウザ拡張機能を使用してインスタントスクレイピングを実現することもできます。無料版は40分に200ページまでしか対応できません。有料版には様々なサポートがあります。

3. Visual Scraper

VisualScraperは、もう1つの素晴らしい無料Webスクレイピングツールです。そのポイントアンドクリックインタフェースで、プログラミングスキルを持たないユーザーでも、自分の好みを設定してデータ抽出を設定できます。そのリアルタイム機能により、データの結果をすぐにテストして表示することができます。

VisualScraperはWindowsで利用可能で、無料プランなら、最大50,000のページ対応でき、有料プランで10万以上のページをスクレイピングすることができます。

プラグイン型

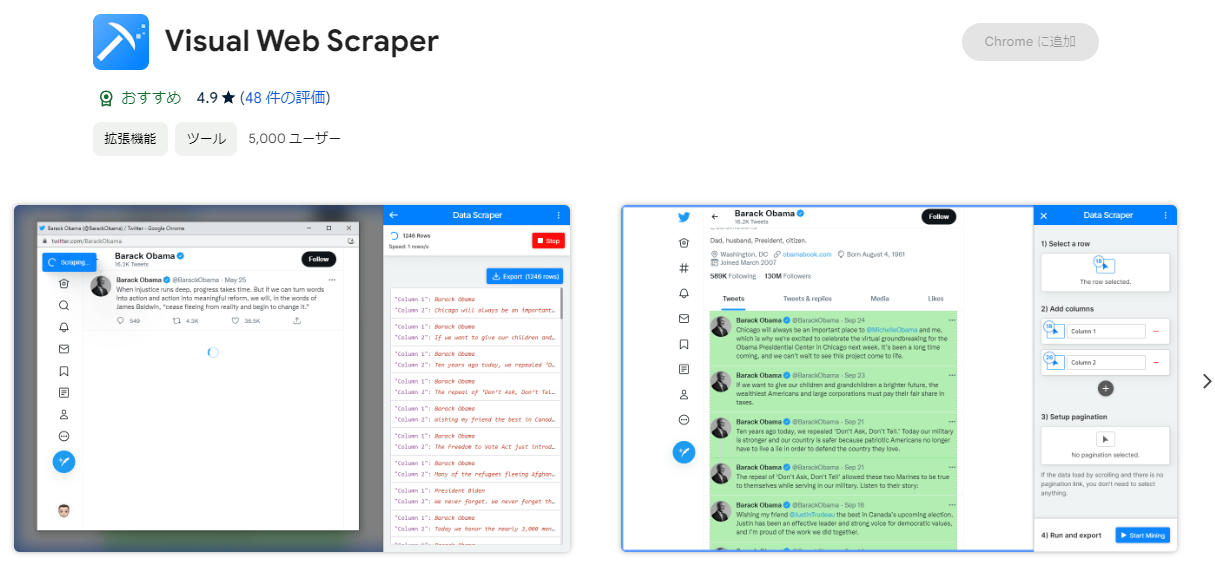

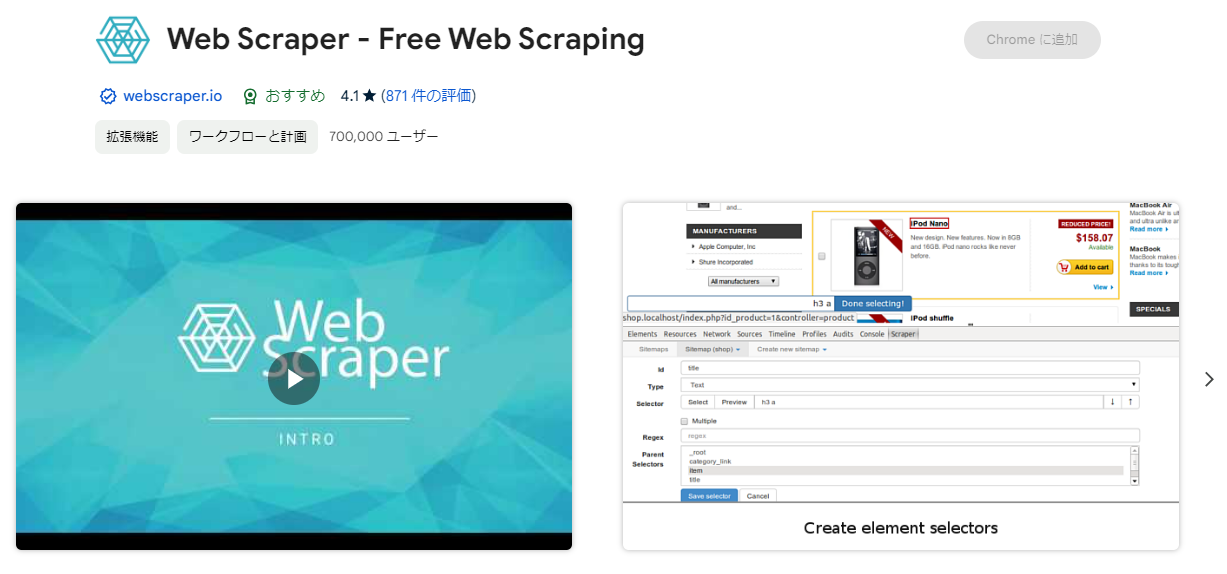

1. Webscraper

Webscraperは、Chromeの拡張として提供されているスクレピングツール。ブラウザの拡張として動作するため、windows、Macどちらでも可能です。拡張機能なら、Webサイトがどのようにナビゲートされるべきであり、どんなデータがスクレイピングされるべきであるかについてのサイトマップ(計画)を作成することができます。もし大量のデータをスクレイピングし、複数のスクレイピングタスクを同時に実行する場合はクラウド版(有料)を選択することができます。データをCSVでエクスポートするか、Couch DBに保存することができます。

2. Scraper

Scraperは、WEBページ上のあるデータを手軽に取得することができるChrome拡張です。テーブルまたはリストからテキストを選択し、選択したテキストを右クリックしてブラウザメニューから[Scrape Similar]を選択します。次に、XPathまたはJQueryを使用して新しい列を追加することによってデータを取得し、他のコンテンツを抽出します。また、その取得したデータをワンクリックでGoogleスプレッドシートに保存することができます。

3. Outwit Hub

Outwit HubはFirefoxの拡張機能で、Firefoxアドオンストアから簡単にダウンロードできます。プログラミングの知識を必要とせずに、OutWit Hubはリンク、メールアドレス、RSSニュースおよびデータテーブルを抽出してExcel、CSV、HTMLまたはSQLデータベースにエクスポートできます。Outwit Hubには、入力したURLのリストからデータをすばやくスクレイピングする優れた「Fast Scrape」機能があります。使い方もシンプルで、簡単な構成のWebサイトスクレイピングに適しています。

WEBサービス型

1. Webhose.io

Webhose.ioを使用すると、世界中のオンラインソースをさまざまなクリーンな形式にクロールして、リアルタイムのデータを取得できます。このWebクローラーを使うと、さまざまなソースをカバーする複数のフィルターを使用でき、取得したデータからさまざまな言語のキーワードをさらに抽出することができます。

スクレイピングしたデータをExcel、XML、JSON、RSSなども形式で保存でき、アーカイブから履歴データにアクセスすることができます。さらに、webhose.ioは取得したデータを最大80種言語でサポートします。ユーザーはWebhose.ioによってクロールされた構造化データに簡単にインデックスを付けて検索することができます。

2. 80legs

80legsは、カスタマイズされた要件に基づいて構成できる強力で柔軟なデータスクレイピングツールです。それは膨大な量のデータの取得と共に、抽出されたデータを即時にダウンロードするオプションをサポートしています。開発者は、クローリングネットを広げるために80legs APIを自分のアプリケーションに組み込むことができます。80legsは、無料からでも利用でき、1回あたり10,000 URLまでわずか数秒でデータを取得できる高性能クローリング体験を提供します。

3. Crawly

CrawlyはWebサイトをスクレイピングしてJSONまたはCSVの形で構造化データに変換する自動サービスを提供しています。数秒以内に限られた要素を抽出することができます。例えば、HTML、コメント、DateEntityタグ、作成者、画像URL、ビデオ、発行者、および国です。