はじめに

深層学習(人工知能学会著)について読み進めながら出てきた専門用語を解説します。第1章はニューラルネットワーク関連用語の基本知識がほとんどです。

(深いトピックに入る前の単語ばかりなので、追記する可能性があります)

第1章:階層型ニューラルネットワークによる深層学習

➢内部表現(internal representation)

潜在表現または特徴ともいわれる。観測データから本質的な情報を抽出した内容。つまりは、何かを与えた時、それを最もよく表すような特徴情報。深層学習(deep learning)では、多層ニューラルネットワークによって対象のデータから本質的な特徴を抽出する。

Ex)多数の筆跡から誰かの筆跡を特定したい際、文字のくせなどが特徴として現れる

➢次元削減(dimension reduction)

データの変動構造を説明する少数の変数を抽出する事。主成分分析などにおいて変数を削減する時に用いられる概念

➢醜いアヒルの子の定理(ugly duckling theorem)

醜いアヒルの子(白鳥の子)と普通のアヒルの子(アヒルの子)との類似点について、普通のアヒルの子同士の類似点と同数となる。(目が黒いか黒くないか、体が白いか白くないか)

すなわち、対象を表現するための特徴を選択する事、また重み付けする事なしに表現の近さに基づいた対象の分類が不可能である事を示している。

➢ノーフリーランチ定理(no free lunch theorem)

すべての問題に対して万能なアルゴリズムは存在しない定理。判別したい対象に対して最適化されたアルゴリズムが汎用的なアルゴリズムよりも有利という事。感覚的にもわかると思われる。

➢表現学習(representation learning)

人手で良い内部表現(特徴の重み付けなど)をデザインするアプローチではなく、データを入力して良い内部表現を観測データから学習させるアプローチ。

➢パーセプトロン(perceptron)

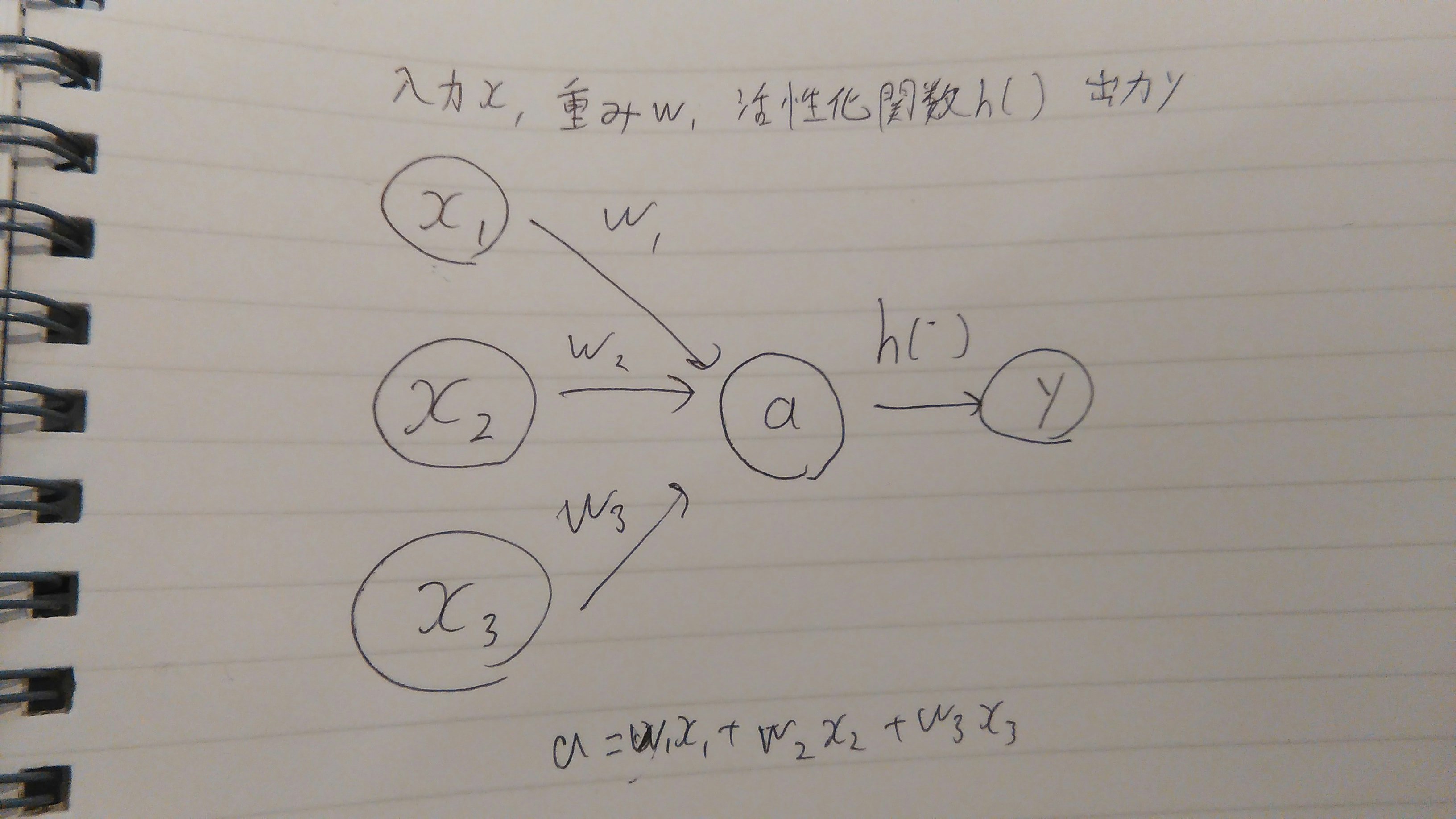

ニューラルネットワークの構成要素。

入力Xiに対して重みWiをかけ、その結果に関数を作用させて出力yとする。

この関数を活性化関数という。

i=3の場合