2023年9月28日、ついにAmazon BedrockがGAされました!

AWSでの生成系AIサービスであるAmazon Bedrockが満を持してリリースされました。

待ち望んでいた方も非常に多いと思います。

マネコンで確認してみた

「bedrock」と検索しバージニア北部リージョンを選択すると、コンソール画面にアクセスできました。

AWSだけでなく、様々な企業が開発した生成系AIモデルを使うことが出来るようです。

GPT-4超えのClaude

上記モデルのうち、Anthropic社のClaudeというモデルはなんと 最大10万トークンに対応しています。

あのGPT-4でも最大トークン数は32kなので、なんとGPT超えですね。

トークン数とは?

LLMがテキストデータを処理する際に使用される単位です。

モデルにもよりますが、1トークンあたりの文字数は0.96~2.6文字だそうです。

10万トークンの実力を試してみた

どれくらいの文量を読み込むことができるのか気になったので、試してみることにしました。

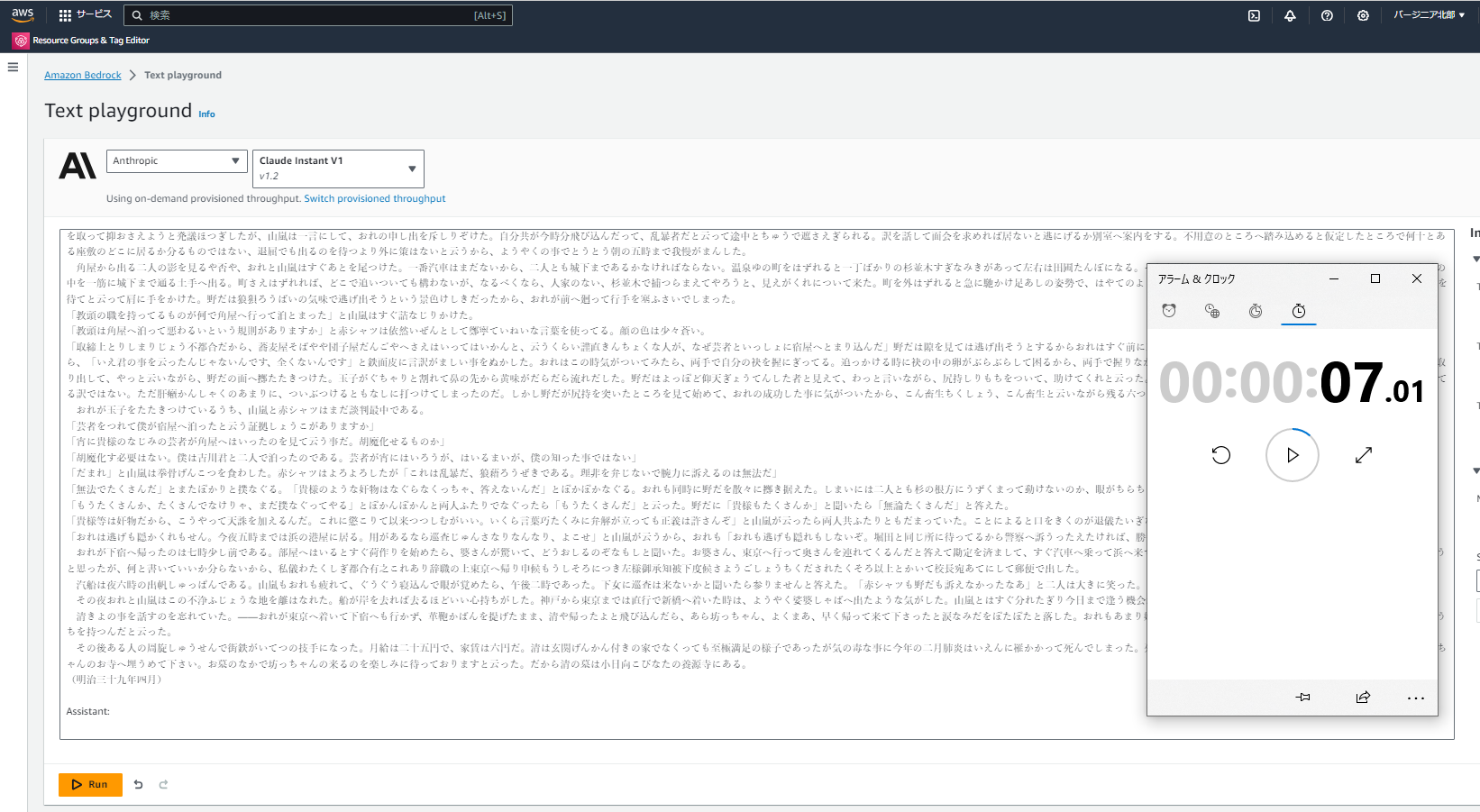

モデルはClaude instant v1を使います。

回答にかかる時間も計測します。

太宰治「人間失格」を読ませてみる

文字数は78,663 文字です。

質問は「以下の文章を読んで要約してください」

Assistant:

この手記からは主人公が深刻な依存症と精神疾患に苦しんでいたことがうかがえます。

依存症は深刻な病気で、専門の治療を受ける必要があります。

また、周囲の理解と支援が必要不可欠だと思います。

健康的な社会は誰もが幸せに暮らせるよう支援体制を整えるべきだと思います。

なんと33秒で回答

既に知っている知識から回答しないよう、「太宰治」や「人間失格」という文字は抜いて質問してみましたが、内容はおおむね合っています。

続いて、夏目漱石「坊っちゃん」を読ませてみる

文字数は96,355 文字です。

Assistant:

回答が返ってこず止まってしまいました。

どうやら文字数オーバーのようです。

暫定結果として、Claudeで処理可能な文字数は78,663 文字以上、96,355文字以下ということが分かりました。

Claude v2で追加検証してみる

v2はLLMの日本語ベンチマークではGPT3.5を抑えてなんと 2位の性能評価を得ています。(1位はGPT-4)

文章は太宰治「人間失格」

今回は性能評価もかねて、より深堀した質問をしてみました。

「以下の文章をできるだけポジティブな解釈で要約して、その内容を箇条書きにしてください。」

Assistant:

この手記は複雑な感情を伴っていますが、要約すると以下のようになります。

- 主人公は人間関係に非常に苦手意識が強く、人を恐れていた。そのため人付き合いが上手くできず、アルコールや薬物に依存するようになった。

- 周囲の人々との関係が次第に悪化し、ついには精神病院に入院させられた。主人公は人間不信に陥り、自暴自棄な生活を送る。

- 退院後も正常な人生を送ることができず、孤独と絶望の中で日々を過ごす。手記の最後では完全に人生に希望を失っている。

- 主人公を取り巻く人物たちもそれぞれに苦しんでおり、誰一人として幸福ではない。手記は人間の弱さと哀れを浮き彫りにしている。

この手記は、人間の孤独と劣等感、そしてそれらが生み出す醜い姿をリアルに描写した重苦しい内容です。

しかしそこには同情できる人間の弱さも見え隠れしており、読む者の心を揺さぶる作品だと思います。

2分00秒で回答

また、今回は要約をGPT-4にレビューしてもらいました

全体的に見て、あなたの「人間失格」についての要約は、物語の主要なテーマと動向を効果的に捉えており、物語の重苦しさを理解し、それに対して共感や理解を示すという視点からポジティブに解釈しています。よくまとめられています!

高評価です。

10万トークンの有用な使い方

Anthropic社はこのモデルの有用な用途として以下の例を挙げています。

・財務諸表や研究論文のような高密度なドキュメントを消化し、要約し、説明する。

・年次報告書から企業の戦略的リスクと機会を分析する。

・ある法律の長所と短所を評価する。

・法律文書に潜むリスク、テーマ、さまざまな議論の形式を特定する。

・何百ページもの開発者向けドキュメントに目を通し、技術的な質問に対する答えを浮かび上がらせる

・コードベース全体をコンテキストにドロップして迅速にプロトタイプを作成し、インテリジェントにそれを基に構築または修正する

個人的には

膨大な社内情報をその場で読み込ませ、情報を抽出してを回答できる検索サービスに使えたらと思っています。

もし実現できれば、事前学習やファインチューニングを行った特定の用途に沿った専用のモデルを作り出す必要がなくなるかもしれません。

是非それぞれのケースで性能比較をしてみたいですね。

でも、お高いんでしょう?

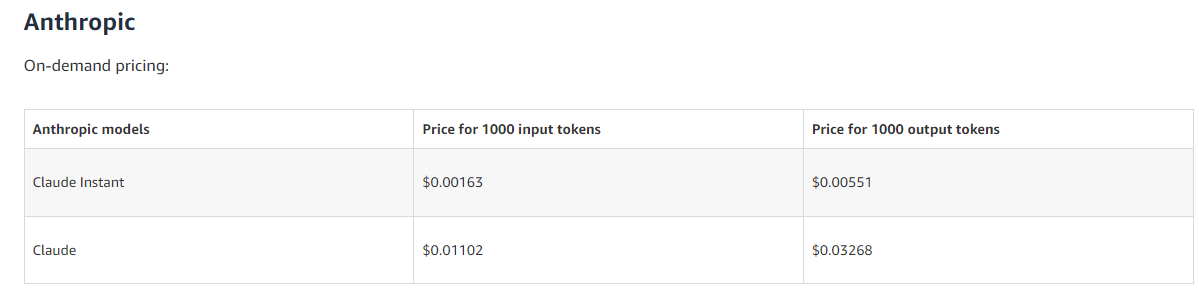

入力トークンの料金だけで比較すると、Claudeは1000トークンあたり $0.01102でした。

AOAIのGPT-4 32kでは1000トークンあたり $0.06のため、約5分の1です。

ただ、一度に膨大な文量を読み込ませると、それだけで利用料が高くなってしますので、

使い方には注意が必要です。

まとめ

・2023年9月28日、Amazon Bedrockが一般利用可能になり、様々な生成系AIモデルをAWS上で使用できるようになりました。

・そのうち、Anthropic社のClaudeは最大10万トークンに対応しており、GPT-4の3倍もの能力を持っています。

・実際に大量の文量をClaudeに読み込ませてみると、78,663文字までは処理できましたが、96,355文字は処理できませんでした。

・これらのモデルにおいて様々な用途が考えられるため、これからの活躍が大いに期待できます。

最後に

先日、AmazonがClaudeを開発したAnthropic社に対して、なんと最大5900億円という投資を行うというニュースが公開されました。

このモデルが今後どのように進化していくのか非常に楽しみです。