こんにちにゃんです。

水色桜(みずいろさくら)です。

今回は今(2022年12月現在)話題のAPIであるChatGPTについて、解説していこうと思います。

本記事は英語が苦手な方へ向けたものになっていますので、もし元の記事がそのまま読める方は、元の記事の方を読んでみてください。(本記事は元の記事以上の情報は提供できません。)

本記事のまとめ(お忙しい方向け)

- ChatGPTは自らの間違いを認めたり、不適切な要求を拒否したりすることができるよ。

- ChatGPTはコードを自動生成したり、コードのデバッグを行ったりすることができるよ。

- ChatGPTは人間からのフィードバックを用いた強化学習を用いてトレーニングされているよ(姉妹版のInstructGPTと同様)(近接ポリシー最適化(Proximal Policy Optimization, PPO)と呼ばれる独自のアルゴリズムを用いているよ)

- ChatGPTはGPT-3シリーズを元としてファインチューニングされているよ(ChatGPTとGPT-3はAzure AI supercomputing infrastructureでトレーニングされているよ)

- ChatGPTは正しそうに見えて、正しくないまたは無意味な回答をすることがあるよ(現状この点を改善することは難しいよ)

- ChatGPTは入力の言い回しに敏感で、少し言い方を変えるだけで適切な応答を返したりするよ。

ChatGPT

OpenAI社が発表した対話形式で会話できる言語モデル。ここから無料で利用できます。なお今現在(2022年12月)はテストのために公開されているだけですので、今後は利用できなくなるおそれがあります。初めての方はまずアカウントを作成してください。

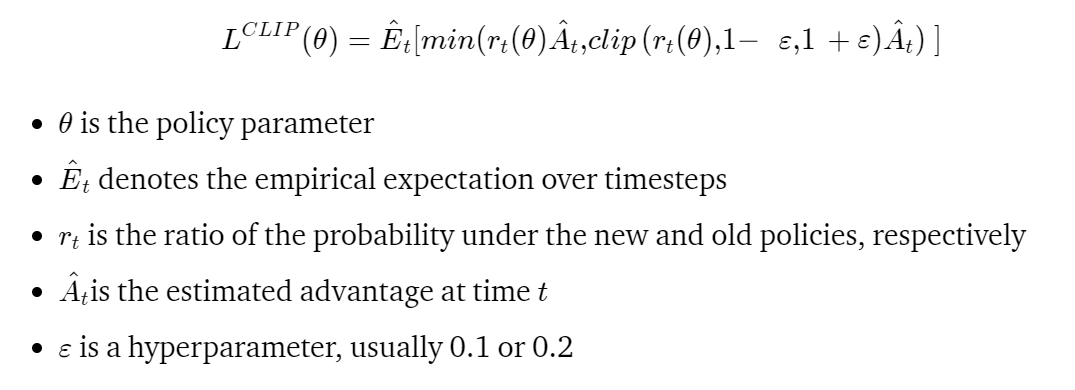

ChatGPTは自らの間違いを認めたり、不適切な要求を拒否したりすることができます。また、ChatGPTはコードを自動生成したり、コードのデバッグを行ったりすることもできます。ChatGPTは人間からのフィードバックを用いた強化学習を用いてトレーニングされています。(姉妹版のInstructGPTと同様)(近接ポリシー最適化(Proximal Policy Optimization, PPO)と呼ばれる独自のアルゴリズムを用いています。)

Proximal Policy Optimization (PPO) とは

最先端のアプローチと同等またはそれ以上のパフォーマンスを発揮し、実装と調整がはるかに簡単な最適化手法。その使いやすさと優れたパフォーマンスにより、OpenAIのデフォルトの強化学習アルゴリズムになっています。

PPOは、実装の容易さ、サンプルの複雑さ、およびチューニングの容易さのバランスを取っています。従来のポリシーからの偏差が比較的小さいことを確認しながら、コスト関数を最小化していきます。

PPOに関する詳しい説明はこの記事を参考にしてください。

ChatGPTの注意点

ChatGPTは正しそうに見えて、正しくないまたは無意味な回答をすることがあります(現状この点を改善することは難しいようです)また、ChatGPTは入力の言い回しに敏感で、少し言い方を変えるだけで適切な応答を返したりします。もし、望んだ返答が返ってこない場合は言い回しを工夫してみてください。

トレーニングデータの偏りから特定のワードに過剰に反応したりします。

終わりに

以上がChatGPTに関する解説でした。元の記事を和訳しただけなので需要があるかどうかはわかりませんが、書いてみました。コードの自動生成の精度はとても高く、もしかしたらエンジニアの職が奪われてしまうかもしれないと思うほどでした。

是非皆さんも使ってみてください。

では、ばいにゃん~。