はじめに

こんにちは。まっちゃ。です。![]()

今回は、物体検出モデルの代表的な評価指標mAPに関して、まとめていきます。

なぜ重要か

物体検出モデルの比較を行う際、評価指標としてmAPが主に取り上げられます。mAPを知ることで、各モデルの強みを理解できます。

目次

- 分類精度の評価指標

- Accuracy

- Recall

- Precision

- F1-score

- 位置精度の評価指標

- IoU

- 物体検出モデルの評価指標

- mAP

- まとめ

分類精度の評価指標

主に、「Accuracy(正解率)」、「Recall(再現率)」、「Precision(適合率)」があります。

-

Accuracy

全てのデータの中でどれくらい正解しているかを示す指標

$$Accuracy = \frac{TP+TN}{TP+FN+FP+TN}$$ -

Recall

実際に正解であるデータの中でどれくらい正解しているかを示す指標

$$Recall = \frac{TP}{TP+FN}$$ -

Precision

正解と予測したデータの中でどれくらい正解しているかを示す指標

$$Precision = \frac{TP}{TP+FP}$$

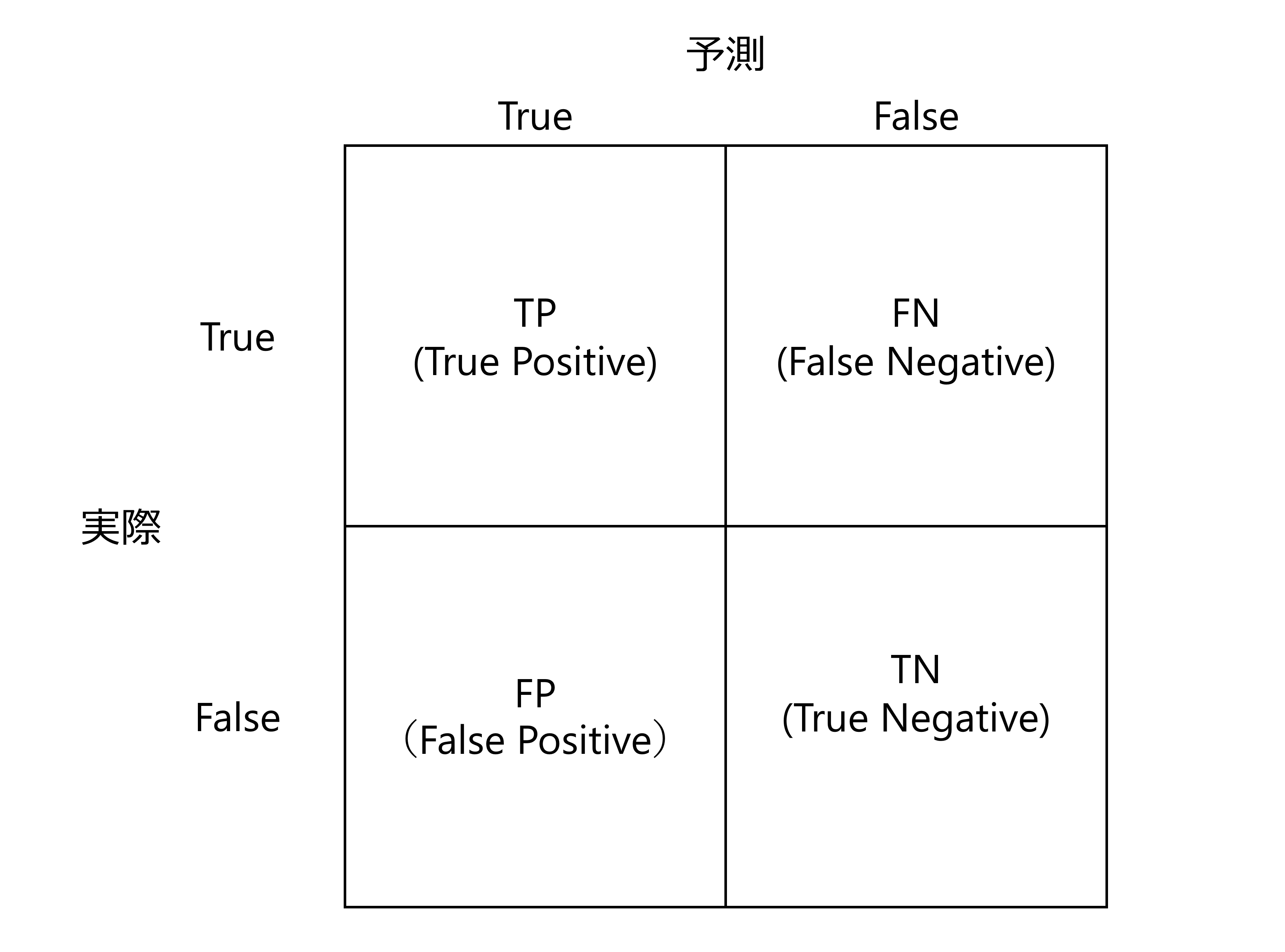

ここで、各指標を算出する際に使用する項目は。混合行列から理解することができます。以下の図に、混合行列を示します。また、以下の表に、各項目の概要を示します。

| No. | 項目名 | 概要 |

|---|---|---|

| 1 | TP (True Positive) | 正解として正しく予測された数 |

| 2 | FN (False Negative) | 不正解と予測されたが、実際には正解である数 |

| 3 | FP (False Positive) | 正解と予測されたが、実際には不正解である数 |

| 4 | TN (True Negative) | 不正解として正しく予測された数 |

上述したRecallとPrecisonは、トレードオフの関係をもちます。そのため、例えば、Recallが良くてもPrecisionが悪いといったように、それぞれ単体でみても評価の良し悪しを決定することはできません。

そこで、2つの指標を組み合わせたF1-Scoreという評価指標が用いられます。

- F1-Score

モデルに加えた変更が性能にどれくらい影響を与えたかを示す指標

$$F1-Score = \frac{2 * Recall * Precision}{Recall + Precision}$$

RecallとPrecisionの調和平均を取った値となります。

RecallとPrecisionのどちらを重要とするかはアプリケーション次第ですが、どちらも重要にする場合にはF1-Scoreが最大値となる閾値を選択してモデルを構築します。

位置精度の評価指標

- IoU (Intersection over Union)

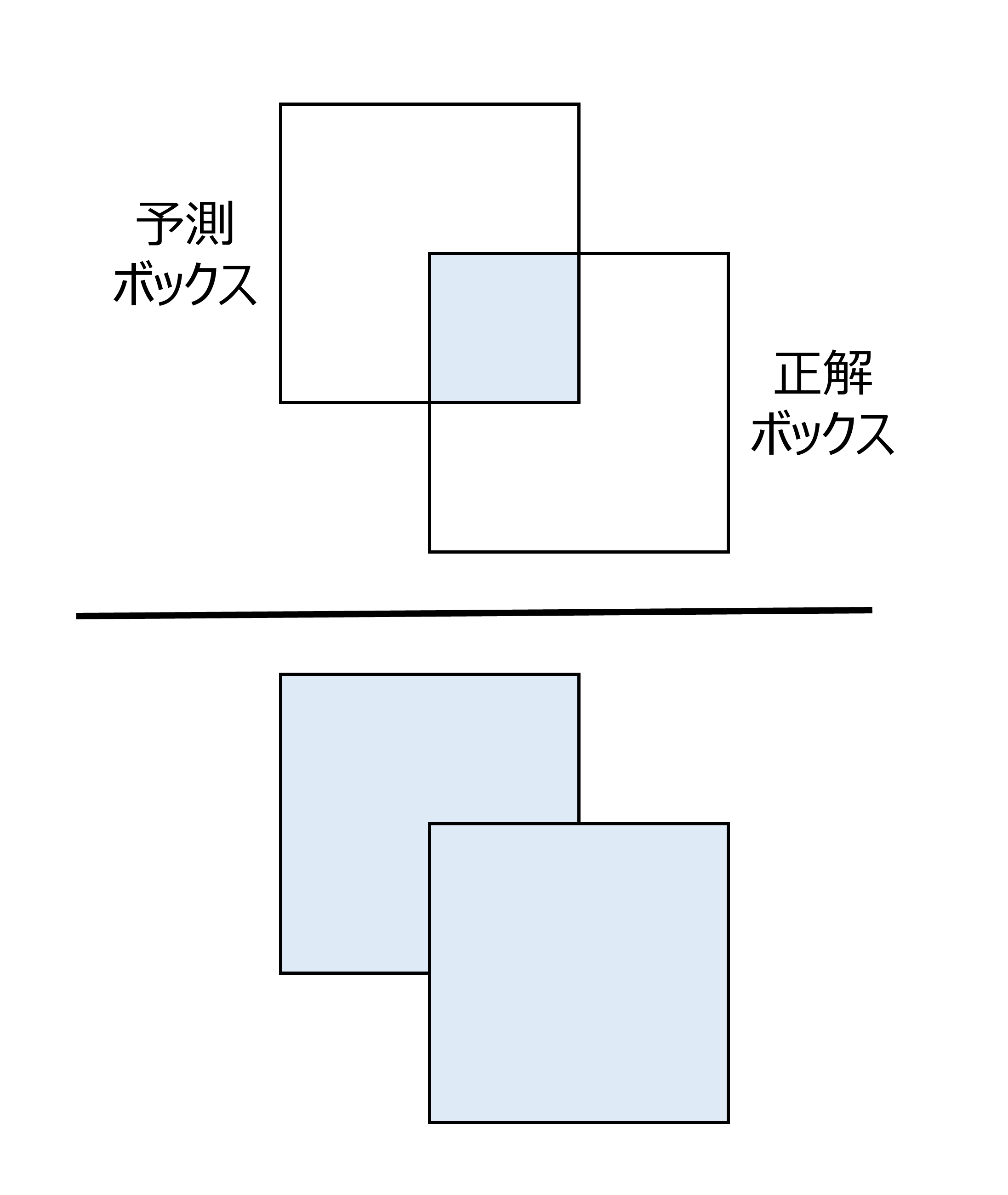

予測ボックスと正解ボックスがどれくらい重なるかを示す指標

以下の図に、図式化したIoUの計算を示します。各ボックスを合わせた領域に対してボックス同士が重なる領域の割合から算出します。

IoUは0.0から1.0の値を取り、1.0に近いほど2つの領域が重なっていることを意味します。

物体検出モデルの評価指標

- mAP (mean Average Precision)

上述したRecall, Precision, IoUを組み合わせた指標

すべてのクラスについてAP(平均適合率)を求め、それらを平均化した値となります。

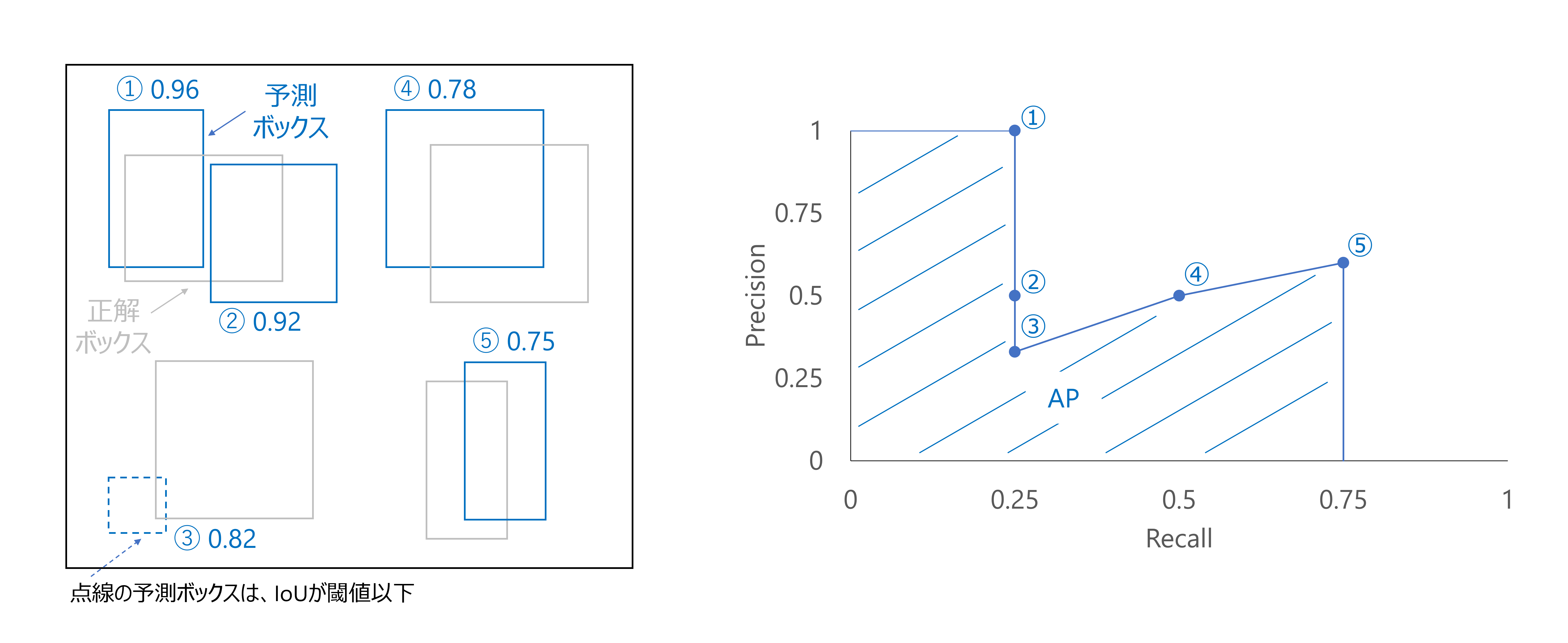

以下の図において、左図に画像中の予測ボックスと正解ボックス、右図にPrecision-Recall曲線(PR曲線)を示します。

以下に、各図を用いてAPを求める方法を示します。(1., 2.は左図、3., 4.は右図を参照してください。)

- あるクラスに関して、予測ボックスと正解ボックスを全てのテスト画像に対して描画

- クラスに対する予測確率をスコアとして、スコアが高い順に並べ替え

左図の①~⑤は予測ボックスであり、各番号横に記載される値はスコアを示します。 - RecallとPrecisionを計算し、PR曲線を描画

- PR曲線の下部の面積を求め、APを算出

PR曲線を描画するために①~⑤の予測ボックスから算出したRecallとPrecisionを、以下の表に示します。ここで、以下を考慮して、各評価指標を算出します。

- Recallの分母は、画像中の正解ボックスの数(上図の例では4)

- Precisionの分母は、その時点で予測したボックスの総数

- TPの加算は、予測ボックスと正解ボックスのIoUが閾値を超えた場合のみ

②について、正解ボックスは①と重複するためTPは加算されず、TP=1として各指標を計算します。

③について、予測ボックスと正解ボックスのIoUが閾値以下であるためTPは加算されず、TP=1として各指標を計算します。

| 予測ボックスNo. | Recall | Precision |

|---|---|---|

| ① | 0.25 (1/4) | 1.0 (1/1) |

| ② | 0.25 (1/4) | 0.50 (1/2) |

| ③ | 0.25 (1/4) | 0.33 (1/3) |

| ④ | 0.50 (2/4) | 0.50 (2/4) |

| ⑤ | 0.75 (3/4) | 0.60 (3/5) |

一般にIoUの閾値を0.5や0.75にした際($mAP_{50}$, $ mAP_{75}$)や各物体サイズを検出する際( $mAP_{S}$, $mAP_{M}$, $mAP_{L}$)の性能評価が用いられています。

まとめ

物体検出モデルに関して、分類・位置精度の評価指標を取り上げ、最終的にmAPについてまとめてきました。

文献を読み進める中で各モデルの精度を比較する際は、文献に記載のmAPの違いを意識します。また、RecallやPrecisionのように、1つの評価項目でモデルの良し悪しを決定することは難しいため、複数の指標を用いて評価を行い、モデルの汎用性を高めたいです。

参考

本記事の執筆にあたり、下記の書籍を参考にしました。

深層学習による画像認識の基礎