はじめに

こちらはIwaken Lab. 主催のアドベントカレンダー5日目の記事になります。

今回は、2022年の12月にリリースされたRealityScanについて紹介させてもらいます!

RealityScanとは

Capturing Reality社が開発していた「RealityCapture」をスマホで体験できるようにしたアプリで、写真から3Dオブジェクトを生成する、フォトグラメトリーの技術をスマホで楽しむことができます。

現状(2022/12/04)、AppleStoreでのみアプリのダウンロードが可能です。

RealityScanで作ったもの

詳細

- 撮影した枚数:108枚

- 撮影開始からSketchfabに出力するまでにかかった時間:65分

- 108枚撮り終えてから、メッシュ作成にかかった時間:6分

- メッシュ作成後、Sketchfabに出力するまでにかかった時間:50分

撮影した写真の枚数、アップロードする時間帯、通信環境などによって、撮影開始からSketchfab出力までにかかる時間は変わります。(実際、25枚の時は、撮影開始からSketchfab出力まで20分程度でした。)

RealityScanの強み

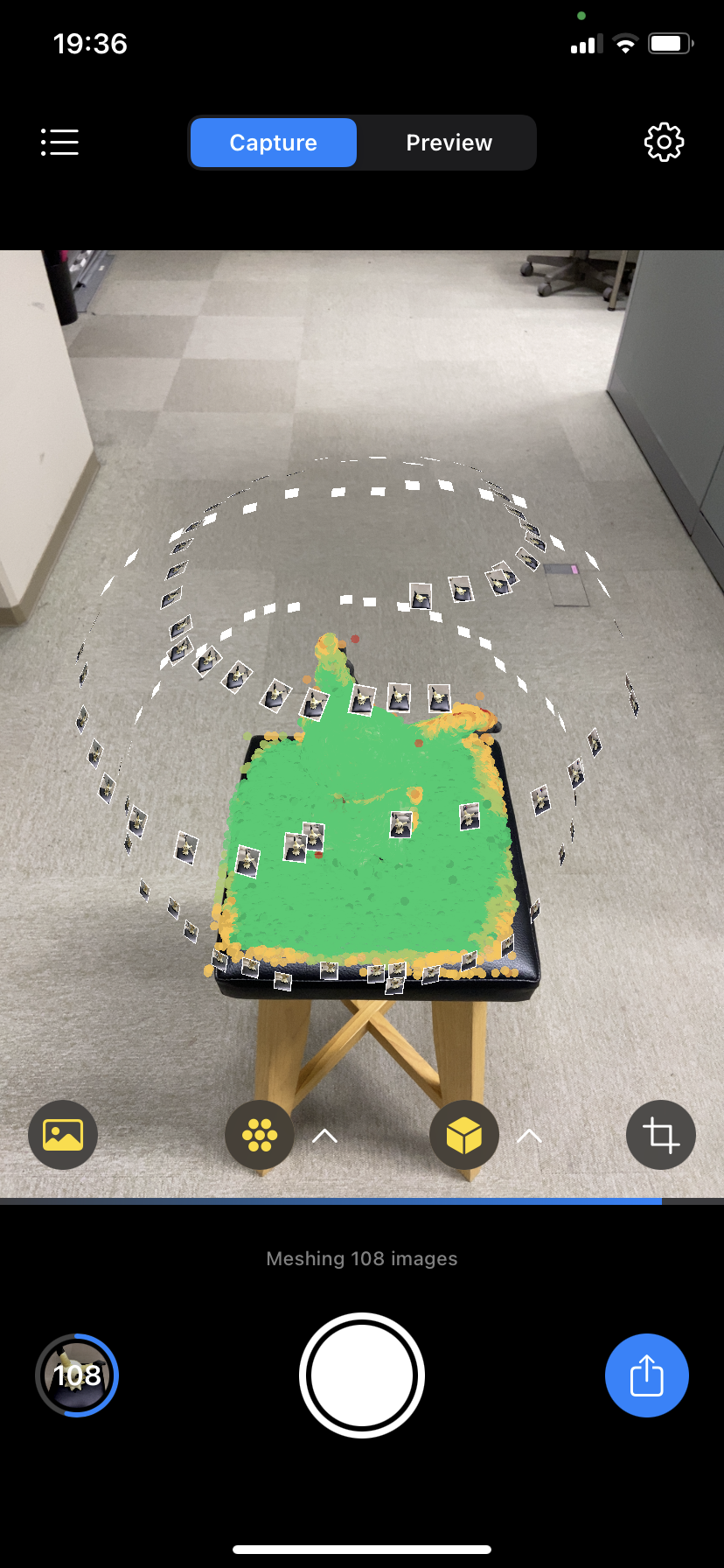

- 写真を撮った位置や角度がARで表示されるので、今までどのように写真を撮ってきたかが分かりやすい。

- リアルタイムで、撮った写真がどれぐらい3Dオブジェクトをカバーしているかが分かる。これが分かると、「もっとこの位置の写真が必要だな」というのを考えることができる。

- これにより、「生成した3Dオブジェクトを見たら、この部分がおかしくなってた

」みたいな事故が起こりにくくなる。

」みたいな事故が起こりにくくなる。

- これにより、「生成した3Dオブジェクトを見たら、この部分がおかしくなってた

RealityScanの弱み

- 写真を撮るごとに3Dオブジェクトのカバー率を計算をするので、時間がかかり、通信量が増える。

- オフラインモードで写真を撮り、後から撮った写真をアップロードすることでこれらの問題は解決可能。

- 生成された3DオブジェクトはSketchfabに出力されるので、3Dオブジェクトを使いたい場合は、Sketchfabからダウンロードする必要あり。

- 写真を撮るとマナーモードにしていても、シャッター音が出るのでうるさい。

RealityScanの使い方

公式ビデオを参考にして、重要そうなポイントをピックアップしていきたいと思います。

- 直射日光が当たらず、どの方向から見ても光のあたり方が一定な物体を被写体にするといい。

- 金属のように光沢があるものや、水やガラスのように透明なものはあまり良くないかも。

- 撮影しているとARビューで、撮影位置や角度を確認することが出来る。

- 被写体全体をカメラのフレームに収めながら、出来る限り近づいて写真を撮るのが良い。

- 被写体が大きい場合などは、カメラのフレームをはみ出ても大丈夫。

- 何枚か写真を撮るとAlignmentの質を表す、点群が現れる。

- 赤色の点群は、もっと写真でカバーしないといけない所。 黄色の点群はそれほど問題のない所。緑色の点群はしっかりカバーが出来ている所。

- 被写体が緑の点群で覆われるほど、質の高い3Dオブジェクトが生成される。

- 画面右下のトリミングにボタンでスキャンする領域を決めることができる。

- スキャンする領域を選択しておかないと、カメラフレームに収まる全てのものに対して計算をしてしまうので、トリミングボタンが表示されたら早めにスキャンする領域を選択した方が良さそう。

- プレビューモードでは、その段階で生成される3DオブジェクトのMeshを確認できる。

参考文献