これまでにも何度か紹介してきた、シリコンバレーのA16Zというトップクラスのベンチャーキャピタルの気鋭のアナリスト、ベネディクト・エバンスが、「AIのバイアス」についての考察をまとめていました。

いわゆる「AIのバイアス」といえば、例えば、白人の方が黒人より多い画像データで作ったAIシステムは白人を認識するのは得意だが黒人はそうでない、といったもののように、私達にとって想像つきやすいものについつい目が行ってしまいがちです。しかし実は、私達人間には認識すらできないもの、例えば光の当たり加減や、音の領域などがバイアスとしてデータに入ってきてしまった場合におきるAIのバイアスこそが、難しい問題なのではないかとベネディクトは言います。

いつものように、鋭い考察でいろいろな角度からAIのバイアスに切り込んでいきますが、彼のエッセイがおもしろいのは、もちろん彼の分析力、クリティカル・シンキング能力が素晴らしいからというのもありますが、それと同時に「たとえ」を使うのがうまいというのが大きいと思います。

今回も洗濯機や麻薬探知犬などわかりやすい「たとえ」が出てきます。

以下、要訳。

AIのバイアスについて - Link

生のデータとはばかで悪いものだ。なのでデータは注意深く料理される必要がある。

- Geoffrey Bowker

機械学習は今日のテクノロジーのトレンドとして最も重要なものの一つです。テクノロジーが次の10年の世界を大きく変えることになるのは、この機械学習による影響が大きいでしょう。

それもあって機械学習の一つの側面が私達を心配させます。それはAIのバイアスというものです。これが、例えば人の採用のときなどに起こす非道徳的な影響や、圧政の政府に大きな力を与えてしまうことになってしまうといったものです。

2013年くらいまでは、例えば写真の中にいる猫を認識するようなソフトウェアのシステムを作ろうとしたら、ロジカル(論理的)なステップを書いていくことになりました。輪郭、目、毛のあらさ、足の数など、そういった条件を書き留めていくことになります。

もちろんそのようなシステムはうまく動くはずがありません。

理論的にはできそうなのですが、現実にはそうした詳細を記述していくのは複雑過ぎます。おそらく、何百、何千と言った数のルールを書いていく羽目になってしまいます。

機械学習を使うとそうしたルールを手で書いていく必要がなくなります。そのかわりに何千と言うサンプルをコンピューターにわたして、予測モデルを作るのです。

機械学習はデータを使ってモデルを生成します。人間が手書きでモデルを作るのではありません。この手法は、特に画像を認識したりパターンを発見したりという領域ですばらしい結果を出します。このために、現在テック業界のすべてが機械学習によって、生まれ変わっている最中なのです。

しかし、これには問題もあります。

現実の世界のサンプルデータの中にはバイアス(偏り)が入っています。そしてシステムはそうしたバイアスを認識するのが得意です。

これがなぜ問題なのでしょう。

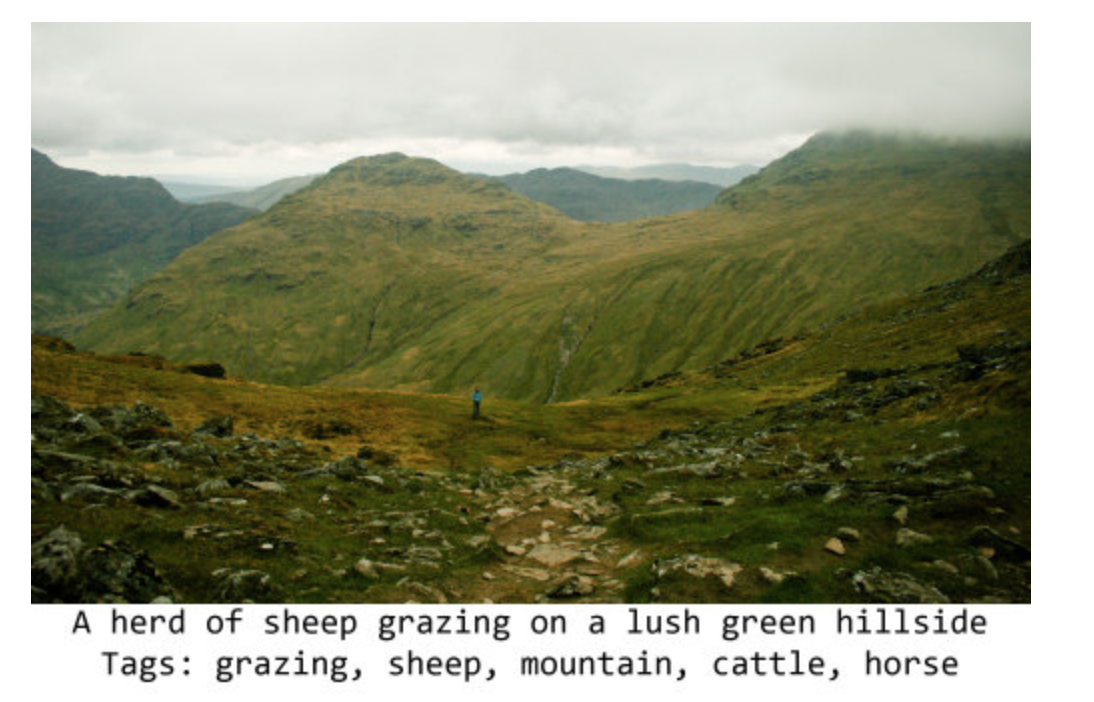

私のお気に入りの例は、画像認識のシステムが草原の丘をみて、「羊がいる」と間違えて認識してしまうというものです。

ほとんどの羊が写っている画像には、草原の丘が存在します。というのも羊はそういったところに存在するからです。画像の中では草原がほとんどを占め、羊は少しばかりです。そこでシステムはその草原に多くの重みを与えてしまうのです。

Microsoftの画像認識システムが上のタグを自動でつけました。Sheepとありますが、この写真の中には羊は一頭もいません。

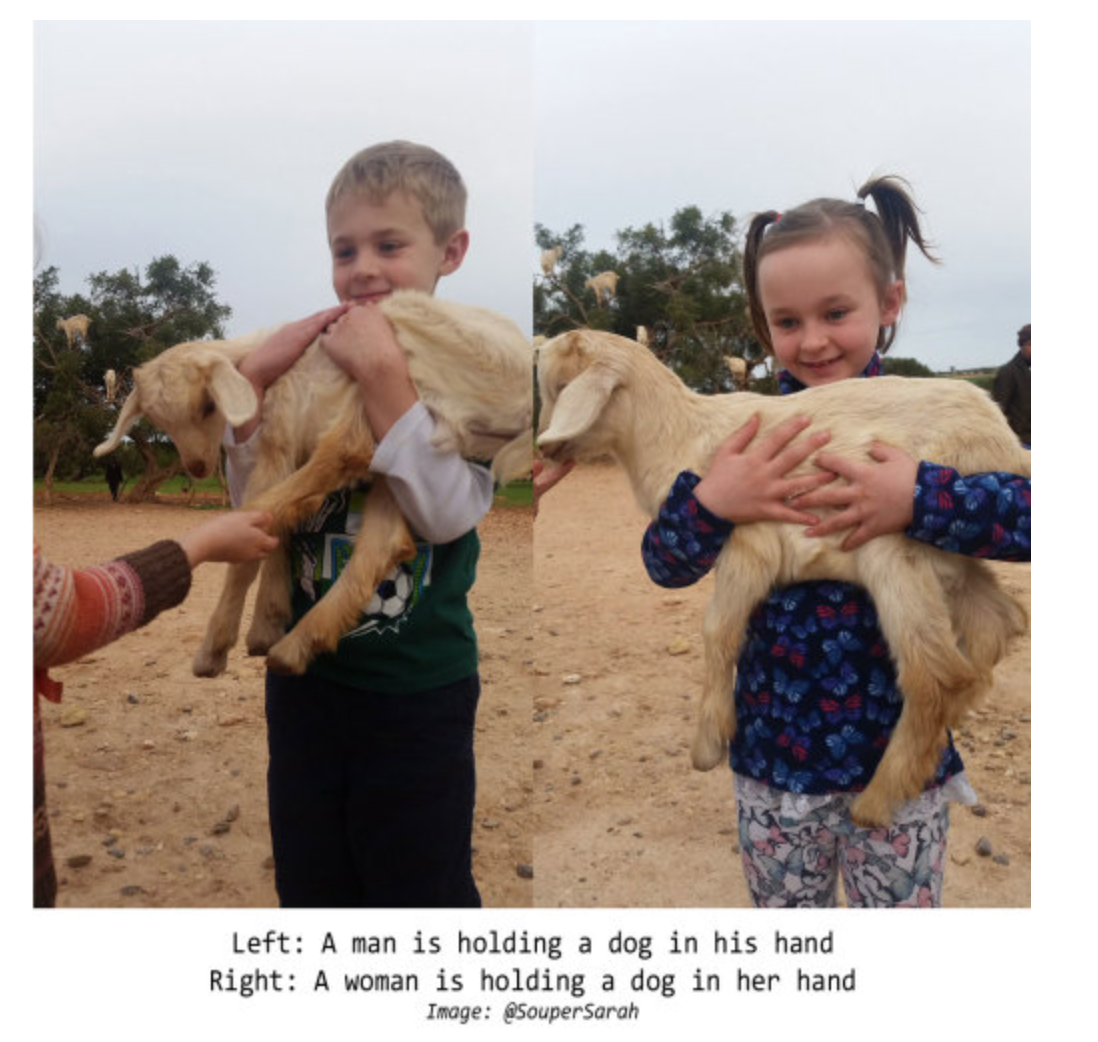

この上の写真もいっしょで、写真の中には羊は一頭もいませんが、Sheepというタグがつけられています。

逆に、上の写真は子供が羊の子供を抱えあげている写真ですが、犬とタグ付けされています。草原以外にいる羊の写真のサンプルデータがあまりなかったのでしょう。

もっと真剣な例としては、最近発表された写真を見て皮膚がんを発見しようとするプロジェクトです。後になってわかったのは、皮膚科の医者はよく皮膚がんの写真の中に大きさを示すために定規を入れる習慣があるということです。逆に、このAIシステムに与えられる健康な皮膚の写真には定規は入っていませんでした。

システムにとっては定規は皮膚がんと健康な皮膚のサンプルの写真の間にある違いに過ぎませんが、それは皮膚の上に見られるしみよりも大きな違いとして認識されました。そこで、皮膚がんを検出するためにデザインされたシステムは、定規を検出するシステムとして出来上がってしまったのです。

ここで重要なのは、システムは見ているものに関しての「意味」を理解していないということです。

私達人間はピクセルのグリッドを見てそれが羊、皮膚、または定規だと解釈します。しかし、システムは数字の列だとしか認識していません。

それは我々が認識するような3次元のものとして見ていないし、オブジェクト、手触り感、もしくは「羊」としては見ていないのです。

ただ単にデータの中にあるパターンを見ているに過ぎません。

こうした問題を理解するのがたいへんなのは機械学習によって作られたモデルは何千、何十万といったノードからなり、そのモデルの中身をみてそれがどのように意思決定を行っているのかを理解するのは一筋縄ではいきません。

そもそも、もし人間が理解できるほどシンプルであれば、機械学習なんていりません、そうであれば、自分でルールを書いてしまえばいいのです。

みんな機械学習がブラックボックスだということを心配していますが、ある意味、当たり前のことを心配しているようにかんじます。

AIのバイアス、もしくは機械学習のバイアスの問題とは、データの中からパターンを発見するためのシステムが、「間違った」パターンを発見してしまうかもしれず、あなたはその事に気づかないかもしれないということです。

これはアカデミアや大きなテック企業で働いている人であれば誰もが知っていることです。(もちろんデータの仕事をしている人はサンプル・バイアスということを理解しています)しかし、その結果起きることは複雑で、そうした問題に対する解決策も複雑なものとなります。

AIのバイアスのシナリオ

最近のことですが、Amazonが採用のための履歴書のスクリーニングを自動化するためのシステムを機械学習で作ろうとしました。

Amazonの従業員の男女比は現在、男に多く偏っているので、成功した過去の採用というのも「男」のデータに偏ってしまいます。当然そういったバイアスの入ったシステムが出来上がってしまいました。

Amazonはそのことに気づいたので、そのシステムがプロダクション・システムとして展開されることはありませんでした。

ここで最も重要なことは、男女を識別できる明らかな情報は履歴書のデータから、あらかじめ外されていたにもかかわらず、システムはバイアスを持ってしまったということです。

システムは「成功している従業員」というサンプルデータを見て、別のパターンを発見したのです。

例えば、女性は自分たちの達成したことについて男性とは違った言葉で表現するかもしれません。学校時代には違ったスポーツをやってたかもしれません。システムは何がアイスホッケーなのか、何が「人」なのか、何が「成功」なのかを知りません。ただテキストのデータをもとに統計的な分析をしているだけです。

しかし、それが見ているパターンは、人間が気づくようなものであるとは限りません。成功の話をする言葉づかいに男女間で違いがあるということは、私達はすでに知っています。しかしそれでも、そうしたバイアスをデータの中に見つけるのは難しいのです。

ここまでのところ、「人」と「人の性質」に関する話をしてきました。世の中の多くの議論はこのあたりに集中しています。

しかし「人」に関するバイアスとは問題の一部に過ぎません。私達は人間以外にも機械学習を使います。そしてそうしたもの全てにバイアスが存在するのです。さらに、たとえ「人」に関するシステムを作っているとしても、データの中に入っているバイアスは人間に関するものであるとは限らないのです。

これを理解するために以下の3つケースを考えてみましょう。

- 様々なタイプの人達が同じ数ずついるということはありません。なので、あなたの持っている写真に写っている肌の色が違う人たちの割合にはバランスが取れていないといったケースです。こうしたデータをもとに作られたシステムが肌の色素をもとに間違った予測をしてしまうことになります。

- あなたのデータには特に記述するほどではないが、それなりに目立つものが入っていて、それらは偏りをもって散らばっているといったケースです。皮膚がんの写真の中にある定規、または羊の群れの中にある草原をもとに学習してしまうシステムができてしまうようなケースです。

- あなたのデータには、人間が「たとえ見つけようとしても」見つけることのできない特徴が含まれているかもしれないというケースです。

ところで、この最後の「たとえ見つけようとしても」というのはどういう意味でしょうか?

私達には事前知識というものがあります、何に注意すべきかというものです。例えば「男女間には違いがある」と言ったようなことです。

定規が写っている写真を見れば、私達には定規が見えます。そして無視するでしょう。なぜならそれは私達の注意に値しないと思うからです。しかし、システムは何もそうした事前知識を持っていません。そしてこのことを、私達人間はついつい忘れてしまうのです。

もし健康でない肌の写真は白熱灯の電気を使ったオフィスで撮られており、健康な肌の写真は全て蛍光灯の光のもとで撮られていたとしたらどうでしょう。

または、もしかすると健康な肌の写真と不健康な肌の写真を撮る前後であなたのスマホのOSがアップグレードされていたかもしれません。そして、そのアップグレードの中に、Apple(またはGoogle)がノイズを抑えるための小さな変更を加えていたかもしれません。

これは、どんなにがんばっても人間の目には見えないというような違いかもしれません。しかし、機械学習のシステムには簡単に識別することの出来る違いであり、その違いが使われてしまうことになるのです。

AIのバイアスの管理

それでは、こうした問題にどう対処していけばいいのでしょうか。以下の3つが考えられます。

- 機械学習をトレーニングするためのデータの収集と管理に関しての徹底したプロセスを作る。

- モデルがどういう動きをしているかを分析、診断するためのツールを用意する。

- 機械学習を使ったプロダクトを展開するためのトレーニング、教育を提供する。

こうした問題はこれまでにもあったことなのですが、新しいのは、もう人間が統計的な分析を行っていないということです。それはマシンによって行われており、そうしたマシンが作り出すモデルを人間が分析するには大変複雑で大きすぎます。

「モデルの透明化」というのはバイアスに関する懸念としてよく問題とされますが、「バイアスがある」ということだけが問題なのではありません。

それよりもバイアスがあるかどうか見極めることが難しいということこそが問題なのです。

これは監査することができるような、明確で論理的なステップを持ったこれまでの組織の意思決定プロセスや自動化とは根本的に違うものなのです。

そもそも既存のシステムや組織における意思決定の仕組みを理解できるとか、監査できるというアイデアは理論上は正しくても、現実の世界では間違っています。

大きな組織でどう意思決定が行われるのかを監査するのは簡単ではありません。意思決定に関する公式なプロセスというのはあるかもしれませんが、中にいる人達が実際に毎日そういうプロセスに従っているということはないでしょう。そもそも人間は明確で論理的、さらにシステム化されたやり方で意思決定しているわけではないのです。

人間だってブラックボックスなのです。それを組織の中の何千もの人々が一緒になったとしたら、その問題は複式で増えていくほどに大きくなります。

組織や人間というシステムが、あなたが監査をし、理解し、変更を加えることができるような明確なロジックに裏打ちされたルールに従うというのは簡単です。しかしこれまでの経験はそうでないということがわかっています。これは、Gosplan(旧ソビエト連邦の国家計画委員会、国民経済に関する5カ年計画。)の迷信といっしょなのです。

もっと簡単なレベルで言うと、古くなったカーナビの地図に従って川に落っこちてしまった運転手が後を絶たないという問題といっしょです。もちろん、そこで使われている地図は絶えず最新のものにアップデートされているべきでしょう。しかし、あなたの車が川に浮かんでしまった責任のどこまでをTomTom(カーナビのシステムを作っている会社)が負う必要があるのでしょうか。

よくある大学や研究機関のトップクラスの研究者が訴えるAIのバイアスの問題というのは、ある意味わかりやすいものです。

しかし、一番の脅威となるのはテクノロジーのコンサルティング会社やソフトウェアのベンダーがオープンソースの世界で作られているコンポーネント、ライブラリー、ツールなどを理解することなくまとめて使ってしまい、それを「AI」という印がついていれば質問すること無しに買ってしまうようなあまり洗練されていない人たちに売ってしまい、それをさらに最低賃金で働いている従業員たちに渡し、システムの言うことは何でもそのとおりにやれと言ってしまうような事態でしょう。

これはAIに特別の問題というわけではありません。こういう問題は以前にもデータベースをもとにしたシステムの時代にもあったことです。そしてソフトウェアの問題でもないのです。これは実は人間の問題なのです。

結論

AIという単語はこういった話をするときには助けになりません。私達が映画に出てくるような、理解することの出きるインテリジェンスを持ったマシン(HAL9000やSkynetなど)を私達人類が作り上げたかのような印象を与えてしまします。しかし、そうではありません。こうしたものはただのマシンに過ぎません。

そういう意味では、むしろ洗濯機に例えたほうが役に立つかもしれません。洗濯機は服を洗うのは人間よりもはるかに得意です。しかし、もし皿を入れて、スタートボタンを押してしまったら、洗濯機はそのまま洗ってしまうことでしょう。

しかし、これはあなたが求めていた結果とはなりません。というのもこの洗濯機のシステムは皿を洗うということは考慮していない、つまり「バイアス」が入ったシステムだからです。洗濯機は何が服で何が皿かということを知りません。それはただ「洗う」ことの自動化に過ぎないのです。

車であれ、飛行機であれ、データベースであれ、こうしたシステムはものすごく力を持っていると同時に、ものすごく限られた使い方しかできません。

それらをどう使うかは人間次第で、使う人がどれだけ理解しているか、こうしたシステムの挙動に関してどれだけ教育されているかにかかっているのです。

機械学習はデータの中にあるパターンを見つけます。どんなパターンなのかはデータに依存しています。そしてそのデータは私達に依存していて、そうして見つかったパターンをどう使うかというのも人間に依存しています。

機械学習は特定のことをするには人間よりもはるかに優れています。それは犬が人間よりも麻薬の検出をするのがはるかに得意だというのと一緒です。しかし、犬が検知したからと言って、それだけでいきなり逮捕はしません。人間が間に入って確かめるものです。

そして、犬はどんな機械学習よりもはるかにもっとインテリジェント(知能がある)なのです。

以上、要訳終わり。

あとがき

本文の中に出てきた、洗濯機と麻薬の検知犬の例えはおもしろいですね。

これまでも言ってきたことですが、現在私達が目にしている「AI」には私達が理解しているような意味が理解出来ていないし、因果関係を理解することもできません。

そこで、結局は今までの自動化のシステムの延長として捉えたほうがいいのでは、ということですね。

結局の所、AIのシステムとは私達が行っていることをもっとはるかに効率よくやってくれるシステムだということです。ということは、私達が行っている「いいもの」はどんどんと自動化され効率良くなっていけばいいのですが、逆に私達が行っている「良くないこと」がどんどんと自動化され効率よく行われるようになっていくのであれば問題ですね。

そして、このときやっかいなのが、私達は自分が行っている「良くないこと」に対する客観的な自覚がないということが、よくあったりするのです。

AIのシステムを作るのも、使いこなすのも人間なのですから、私達人間の方にも最低限の知識と理解が要求されます。AIの専門家を増やすのはそれはそれで必要なのかもしれませんが、それ以上にもっと一般の人に、少なくともビジネスや組織で意思決定に携わる人は、AIやデータに対するより深い理解を持つことに責任を持つべきだと思います。

データサイエンス・ブートキャンプ、7月開催!

次回ブートキャンプの7月の開催が決まりました!

データサイエンス、データ分析の手法を1から体系的に学び、現場で使えるレベルのスキルを身につけていただくためのトレーニングです。

データを使ってビジネスを成長させていきたいという方は、ぜひこの機会に参加をご検討ください!

詳細はこちらのページにあります。

現在、早割期間中ですので、お早めに!