人種差別の慣習をもっている組織が作ったデータにはやはり人種差別なバイアスが入り込んでしまうわけで、そんなデータをもとに作った機械学習のモデルは、例えどんな高度なアルゴリズムやテクニックを適用したところで、人種差別的なものになってしまうものです。

アメリカでは人種差別的な慣習を持った警察がよく問題になることがあります。特に南部や中西部の方に行くとひどかったりします。

現在そういった組織が過去に記録したデータをもとに、犯罪予測システムを作り、そこから出てくる予測をもとに捜査を行ったり、容疑者の扱いや刑罰の決定を行ったりということがすでに行われ始めているようです。

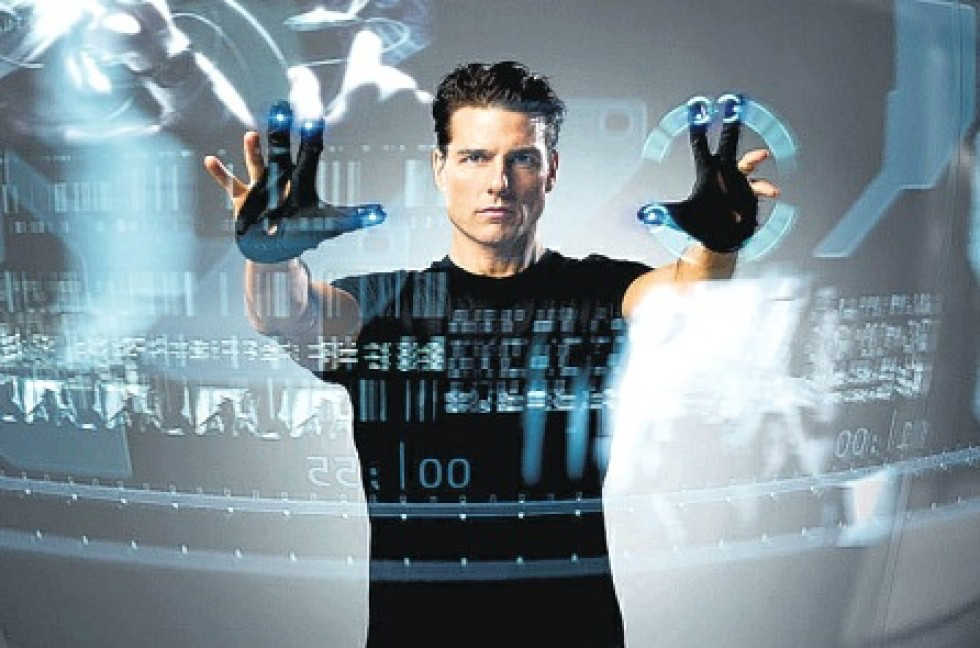

今から20年近く前に、トム・クルーズ主演の「マイノリティ・レポート」という映画がありましたが、まさにこうした犯罪予測システムによって間違って逮捕されてしまうという話の映画でした。

20年たった今、こうした問題がいよいよ現実になってきたのだなと実感します。

今回は、アメリカの南部の市であるニューオーリンズでの例を中心とした話がちょっと前に「Technology Review」の方で出ていたので、紹介したいと思います。

ちなみに、ニューオーリンズ市は、アメリカの南部、ルイジアナ州にあり、ジャズをはじめとした音楽やクレオール料理が有名な街です。しかし、全体的に貧しい地域でもあります。

以下、要訳。

Police across the US are training crime-predicting AIs on falsified data - Link

ニューオーリンズの政治や警察のシステムは汚染されています。

あまりにもひどいので、2010年にはアメリカ政府の司法省が乗り出して調査をしたところ、ニューオーリンズの警察庁はその捜査方法や容疑者の扱いについて何年にも渡って継続的に、アメリカ憲法や、連邦レベルの法律を破っていることが明らかになりました。

黒人や人種的なマイノリティ、また英語を話さない人たちやLGBTQ(レズビアン、ゲイ、バイセクシュアル、トランスジェンダー、Questioning/不明)の人達に対する必要以上な捜査、女性に対する暴力の抑止を行っていないなどと言った問題が上がっています。

当時の司法長官次官補が言うには、問題は深刻で、組織中に広がっており、構造的で警察組織の文化の中に深く根を下ろしているとのことです。

汚れたデータをもとにした犯罪予測システム

ところが、ニューオーリンズ市はその次の年にシリコンバレーに本社のあるデータ・マイニングのサービスを提供する会社であるPalantirと、秘密のパートナーシップ契約を結び、犯罪予測システムを作り展開しました。

このシステムは検挙に関する履歴や警察官から上がってくるレポートといった過去のデータを使って、これから起こるであろう犯罪を予測し公共の安全を守るための戦略を立てるために使われるとのことでした。

しかし、データをきれいにしたり、前述にあったような司法省によって指摘された問題を修正したりすることが行われることはなかったようです。

おそらく、間違ったデータはそのまま予測システムに読み込まれ、このことによってこれまでの警察部門の人種差別的なやり方がこのシステムによってさらに持ち込まれることになりました。

こうした犯罪予測システムを警察が使うのはアメリカの都市部では普通になってきています。こうしたシステムに対する透明性がないので正確な数字はつかみかねますが。

こうしたシステムは多くの場合、人員不足の警察組織の効率性を高めるため、さらにデータ・ドリブンな意思決定が行えるようにするために使われると謳われています。

機械学習のシステムというのは、学習したデータと同じレベルの品質しか出せないものです。

もしデータが間違っているのであれば、必要以上に監視されているマイノリティの人種のコミュニティーにより多くの警察の人員を割り当てることになってしまいます。

テック・ウォッシング

いわゆる「テック・ウォッシング」ということが起きています。

こうしたシステムを使う人達はそれがコンピューターなので、中立または客観的だろうという仮定のもとに使ってしまっているのです。

しかし、実際にはこうしたシステムのいくつかはあきらかに憲法や法律に違反しているのです。

犯罪予測システムをこれまでに使っていた13の司法管轄区を調べてみたところ、9つでシステムが「汚いデータ」によって学習された予測モデルを使っていることを示す強い証拠が見つかっています。

なぜデータは汚いのか

ニューオーリンズのように、マイノリティ(少数派)に関するバイアス(偏り)の入ったデータだけが問題だというわけではありません。

いくつかのケースでは、一般に公開される犯罪率の数値を下げるという政治的な重圧のもとで警察部門がわざとデータを加工したり結果を変えたりするということが行われていました。

ニューヨークの場合は、犯罪に関する数値を人工的に低く見せるために、犯罪の起きた現場で警察が被害者に正式にレポートしないように要請していました。

警察官の中には、麻薬に関する犯罪の検挙率の目標を達成するために、無実の人たちに対して麻薬を「植える」(家や車の中で見つかったというふりをして、実は自分たちが持ってきた麻薬を取り上げて見せること)ということを行っていました。

将来の犯罪を予測するための機械学習にたよっている今日の犯罪予測システムでは、こういった壊れているデータが正しい予測変数として扱われてしまっています。

他人ごとなシステム構築ベンダー

こうしたソフトウェアを作っているベンダーは、そのようなバイアス(偏り)のかかった結果は簡単に修正することができると言います。しかし、全てのケースでわかっているデータの問題とはシステム的な問題なのです。

それゆえ、この問題を解決するには単純に1つや2つの間違いを取り除くといった以上のことが必要になってきます。良いデータと悪いデータを切り離すというのはそんなに簡単なことではないのです。

さらにシステムを作ったベンダーはシステムに入っていくデータをまったく検査していないということがわかりました。

犯罪リスク評価システムにも問題がある

アメリカで使われている犯罪リスク評価システムにも非難が集まっています。これは機械学習を使ったシステムで、容疑者が裁判で刑が決まるまでの間どう扱われるべきかといったことや、犯罪が確定した場合の刑の重さを決めたりするのに使われています。

ここで問題になっているデータは取締りのシステムに使われているわけではありません。それは警察システムのあらゆるところで使われているのです。

予測結果ではなく、その仕組みの理解、そして因果関係の理解こそが重要

現在はシステムの仕組み自体に関しての議論ばかりです。つまり、どのようにシステムをデザインすることで数学的に公平な結果を出すことができるのかというものです。

しかし多くの研究者は、これは間違った質問だと言います。

「これを社会的なシステムの問題と切り離して、アルゴリズムの問題にフォーカスしてそれを解決しようとしても、本当の問題の解決には対して役に立たないでしょう。こうした数学や計算をもとにしたアルゴリズムだけではバイアスの問題を解決することができないということを認識する必要があります。」

こうした意思決定を自動で行なうようなシステムがどのように作られているのかを、作っている人たちにしっかりと説明させ、その使われ方を監視する仕組みを政府レベルで作っていくべきです。

そうした「汚いデータ」を生成することになった社会的、政治的な仕組みが改革されない限り、そうしたツールは役に立つというよりも、害になります。

このことに気づくことができると、議論は、「どのように機械学習や他の先端的なテクノロジーを使って犯罪のもととなる原因を解決することができるだろう。」というものにシフトしていきます。貧困や失業、そして住居の問題を解決するために政府のデータを使うことこそ、有効なやり方なのではないでしょうか。

要訳、終わり。

あとがき

これまでにもデータ・ドリブンの危なさ、みんなが思っているほどに客観的ではないデータなどの話をしてきました。

データ・ドリブンの問題は、「汚いデータ」を使って作られてしまった「間違った予測システム」でも、それを使う側には多くの場合十分なAIやデータに対する知識がないために、何の疑いもなくそのまま使い続けてしまうことになってしまうということです。

こうしたシステムによる予測結果をナイーブに信用してしまうことは、社会を良くするというよりは、かえって社会に害を及ぼしてしまいます。特にそうしたシステムによって影響を受ける方はたまったものではありません。

しかし、ここでデータや機械学習に対して悲観的になる必要はないと思います。

データサイエンスに使われるのではなく、使いこなす

データとAIの限界を正しく理解した上で、データと機械学習や統計のアルゴリズムを使いこなせれば、今までの人間ベースのシステムよりもはるかに優れたシステムを作ることができるチャンスがあります。

そもそも今回のような問題が起こるのは、人間が持ち込むバイアスが機械学習によって最適化され、その予測結果を盲目的に信じてしまうことでバイアスを持ったシステムが広く多くの人に使われてしまうということです。

ただここで一歩止まって、統計や機械学習のモデルを使ってデータの中にあるパターンを理解することに努めることで、データの中に入り込んでしまったバイアスに気づき、そのことに対する議論を進めることができます。

予測と因果関係

また、統計のモデルを使うことで、因果関係を構築していくための議論を進めていくことができます。

つまり、だれが犯罪を起こすかもしれないのかという予測ではなく、なぜその人達が犯罪をおこすという予測が出るのか、それはどういう理由があってそうなるのか、という因果関係のことです。

どれくらいの犯罪がどこで起きるかということが予測ができると、例えば取り締まりに必要な人員や予算を割り当てることができます。しかし、因果関係がわかれば、犯罪が起きる仕組みを変えていくことで、そもそも検挙しなくてはいけない犯罪者の数を減らしていくことにつながります。

これはビジネスでも同じですね。例えば、サブスクリプションのビジネスであった場合、誰がチャーン(キャンセル)するのか、または誰がコンバートするのかを予測できるというのはもちろん便利かもしれません。しかし、それよりもなぜコンバートするのか、なぜチャーンするのかといったことを解明できたほうが、対策を早めに打っていくことができますし、その効果は大きくスケールします。

データサイエンス x 人間

もちろん、こうした因果関係を調べるのはただ単にデータとアルゴリズムだけで片付けることができるようなものではありません。そこではドメイン知識や仮説を検証するための仕組みをデザインしたりする必要がでてきます。

しかし、こうした社会の、またはビジネスの因果関係の解明に努めることこそが自分たちの目的を達成するための施策を計画、実行に移す上で非常に重要になるのではないでしょうか。

これからは、データサイエンスと人間性(因果関係の構築、目的の定義、価値観の定義、創造性など)を交差させることのできる個人、そして組織こそがますます社会やビジネスに求められるのではないかと思います。

SaaSアナリティクスと探索的データ分析のトレーニング5月開催!

Exploratoryでは来る5月、データとアナリティクスを使ってSaaS/サブスクリプション・ビジネスを改善していくための**「SaaSアナリティクス」というトレーニングと、データの可視化とアナリティクスを使って、予測と因果関係の理解に役立つ仮説を構築していく「探索的データ分析」**のトレーニングを開催します

データとアナリティクスを使ってより良い意思決定を行っていきたいと言う方は、ぜひこの機会に参加をご検討ください!

詳細は以下のページよりとなります。