「 00. はじめに 」

__「AWS Lambda」を使って、「AWS Batch」__にjobをSubmitするまでの実装 (設定) 手順をまとめたいと思います![]() !

!

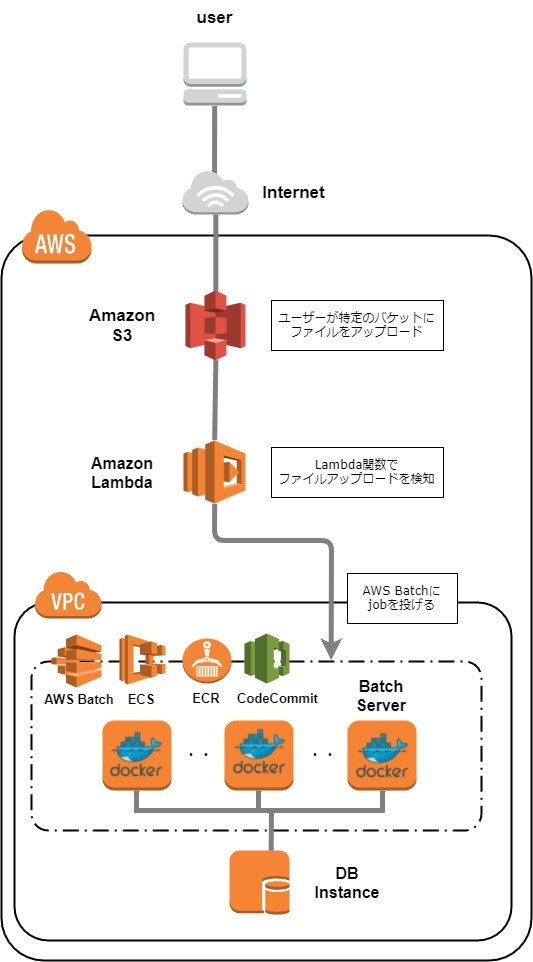

今回考えている構成は、下記の通り。

処理フロー

- 特定のBucketにファイルをアップロード (ユーザー)

- ファイルアップロードを検知 (Lambda:トリガー)

- AWS Batchにjobを投げる (Lambda: index.js)

この構成を実現するために実装が必要な部分は、下記の通り。

(1) S3バケットの作成 ( 本記事では、割愛 )

(2) AWS Batchの初期設定

(3) Amazon Lambda関数作成

(4) [検証]ファイルアップロード

「 01. AWS Batchの初期設定 」

「 01. AWS Batchの初期設定 」

AWS Batchとは?

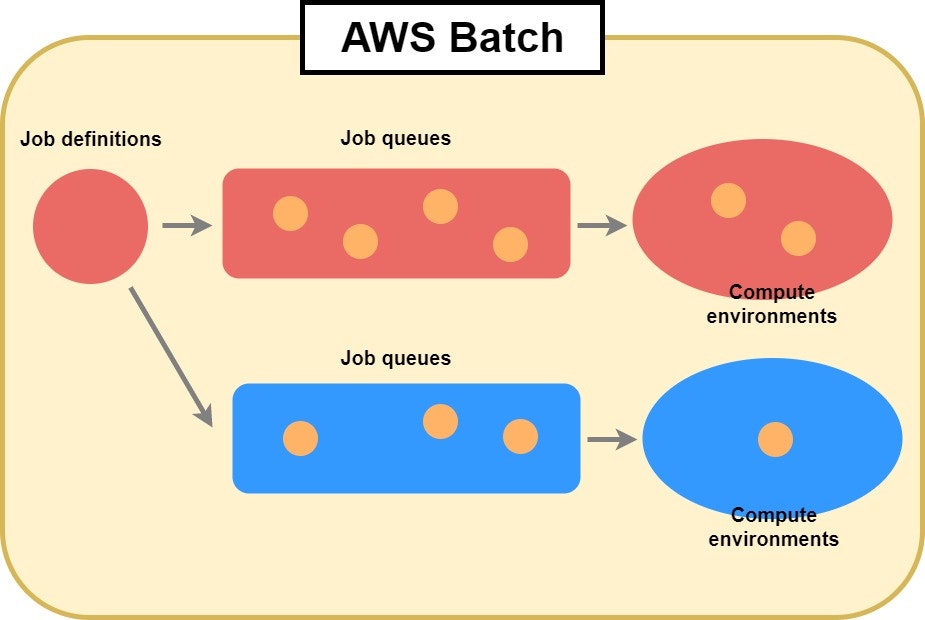

__「Job definitions(ジョブ定義)」を使って生成した「 Jobs (ジョブ) 」を「 Job queues (ジョブキュー) 」に投げると、job queuesに紐づいた「 Compute environments (コンピューティング環境) 」をプロビジョニングし、

job definition内で定義された__ECR ( EC2 Container Registory ) または、__Docker Hub__からコンテナイメージを取得して、

自動でバッチ処理を実行してくれるマネージドサービスです。

(※1) 後述「 Minimum vCPUs 」を 0 に指定しておくことで、実行しているタスクがない場合、

インスタンスを起動してから1時間以内に自動で停止・削除 ( Terminate ) を行ってくれます。

AWS Batchは、バッチ処理を行う実行コマンド、インフラ環境等をあらかじめ設定しておくためのものなので、

この時点では利用料金は無料です。AWS Batchの設定に基づいて起動したECS ( EC2クラスタ ) やその他、

AWS Batchにより起動したサービスにおいて従量課金モデルが適用されるので、デモ等を行った後は、

不要なインスタンスが立ち上がったままになっていないかチェックしてみてください!

AWS Batchに触れたことのない私のようなユーザーは、

まず最初に、下記の2つの記事を読むとサービスのイメージを掴みやすいと思います。

それでは、AWS Batchを扱う上で押さえておくべき3つのコンポーネントについて紹介したいと思います。

(上記記事内でも触れられている内容ですが、さらに初心者にも分かりやすいよう表現したつもりです。)

AWS Batch の3つのコンポーネントについて!

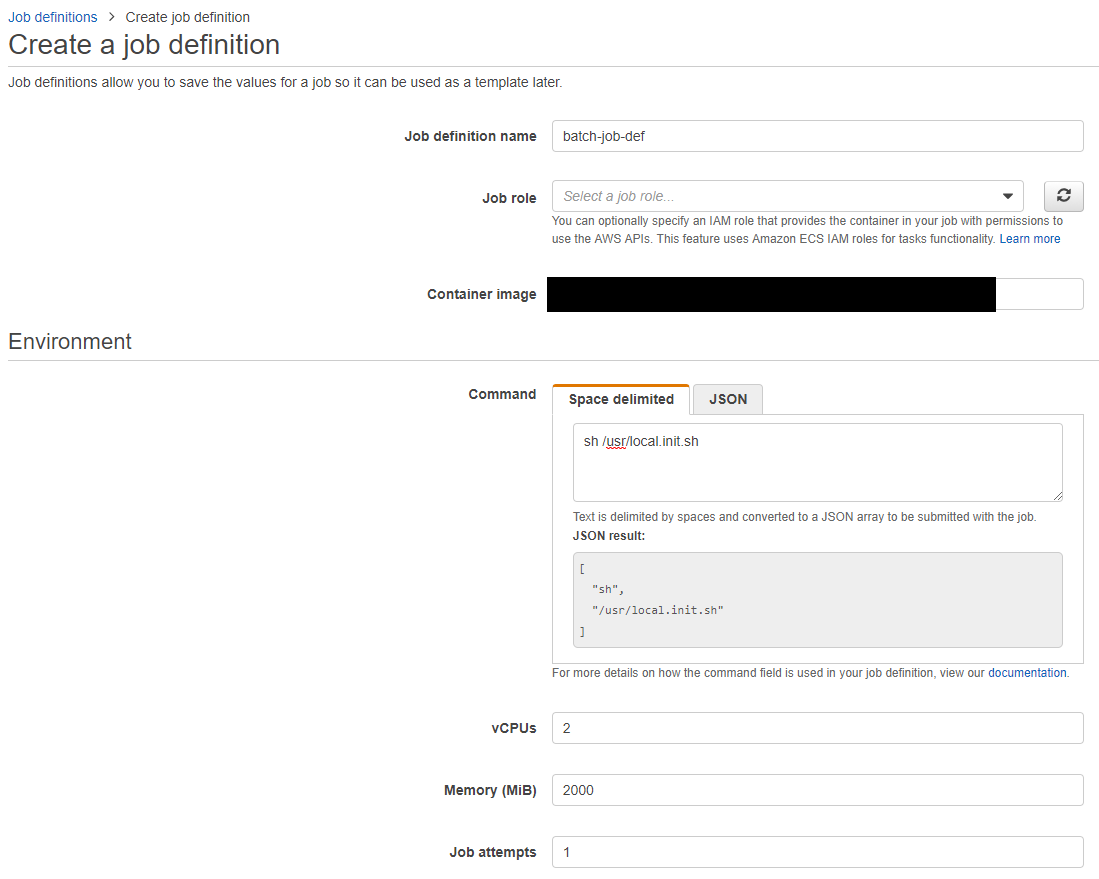

1. Job definitions [ ジョブ定義 ]

ジョブとして起動するコンテナイメージ、実行コマンド、環境変数、マウントするボリューム等を

指定することができます。また、エラー発生時のリトライ回数の指定を行うことも可能です。

分かりやすく一言で言うと、ジョブを生成する際のテンプレートです。

2. Job queues [ ジョブキュー ]

AWS Batch用のジョブキューです。 FIFO (First In First Out) に対応しており、

キューには優先順位をつけることができます。

サブミットされたジョブを管理するキュー。

どのコンピューティング環境でジョブを実行するのか紐づけをすることが可能です。

3. Compute environments [ コンピューティング環境 ]

バッチ処理を行うECS(クラスタ)の定義を行います。インスタンスタイプから、key pair、

ロールなどを指定することができます。また、AutoScalingの設定も可能です。

実際に処理を行うコンピューティング環境の設定が可能です。

実践編

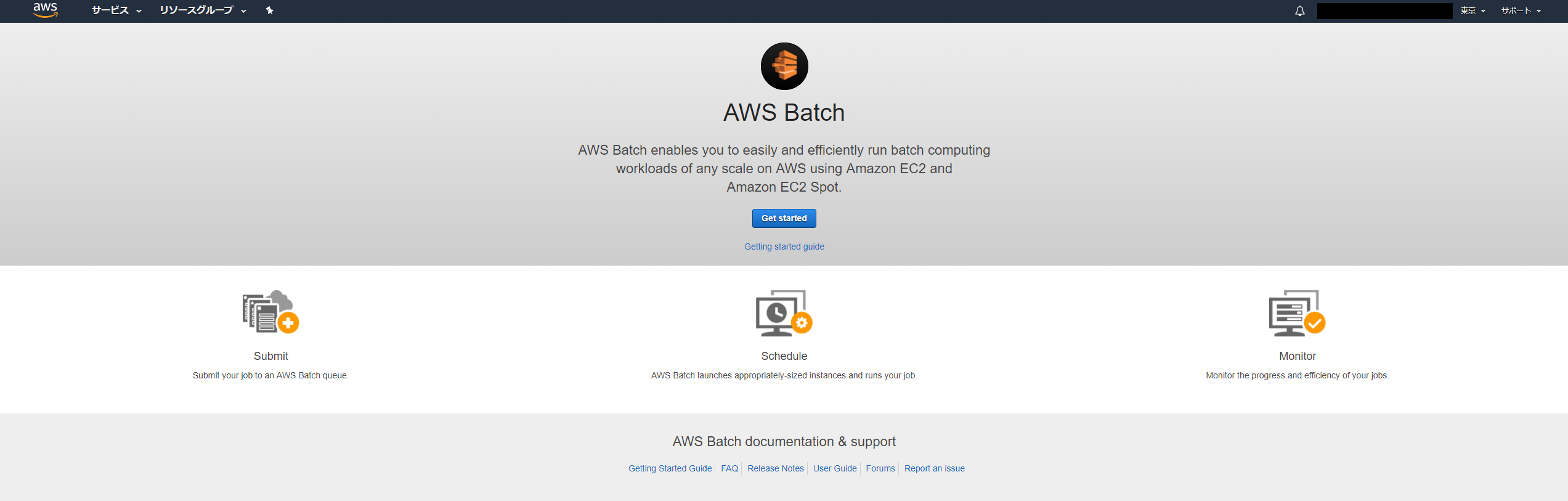

なにはともあれ、設定画面を見ずにテキストでできるだけ教えてもらっても意味がないので、

実際の設定を行いながら、解説を進めていきたいと思います。

さっそく、[ Get started ] をクリックして進めていきます。

はじめてAWS Batchの設定を行う際に表示される「初期設定ウィザード」はそのまま進めていき、

デフォルトのまま作成すると、後で個別の設定を行う際に楽になるので、とにかくデフォルトのまま進めていきます。

(※また、jobが実行されインスタンスが立ち上がりますので、削除しておいてください。)

[ 参考サイト ]

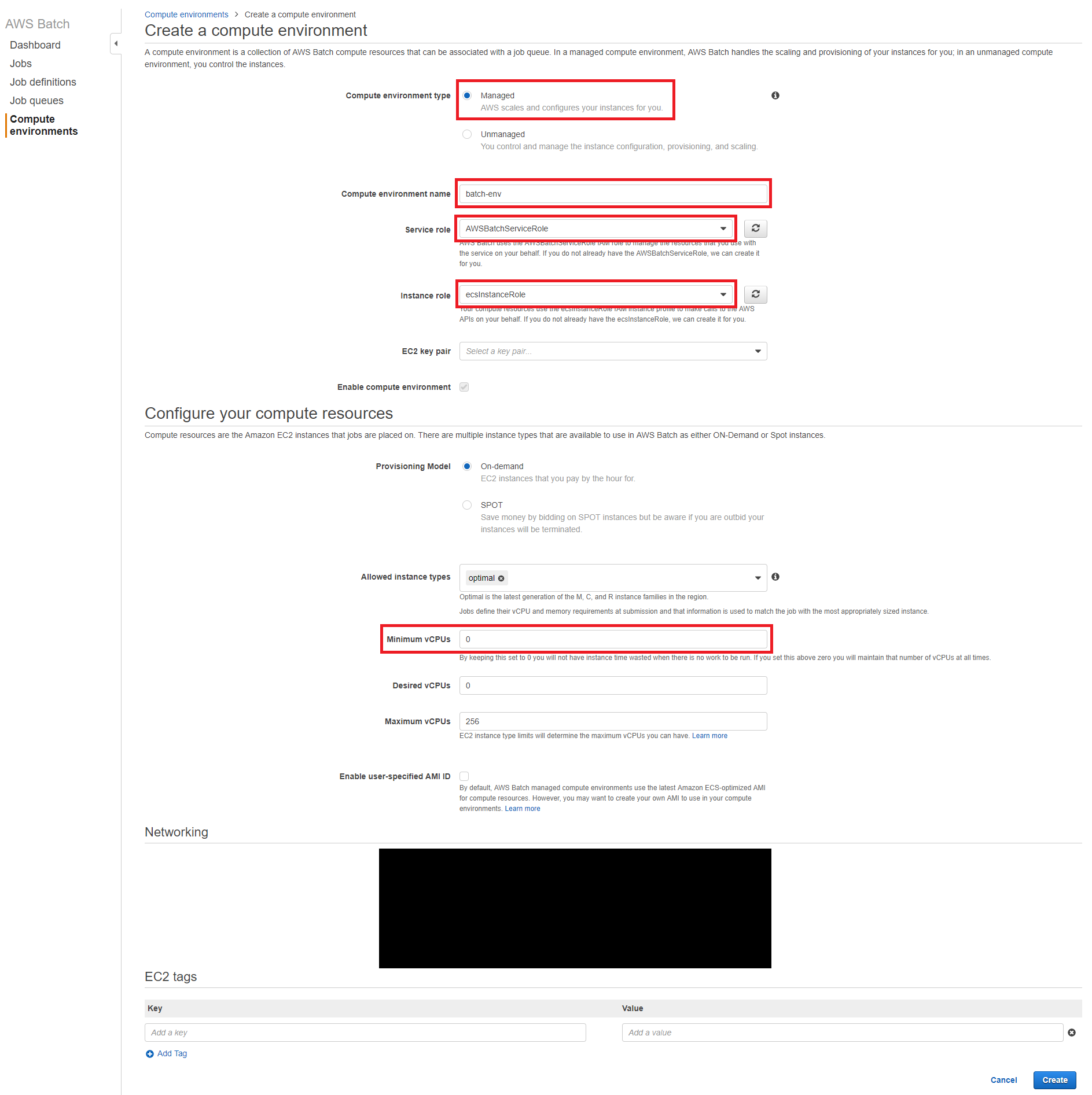

1. Compute environments ( コンピューティング環境 ) の設定

- Compute environment type は、「 Managed 」のままにしておく。

- 今回は「初回設定ウィザード」を使って作成したコンピューティング環境と区別をしたいので、適当に名前を付ける。

- 「Desired VCPUs」は起動するインスタンスの希望するvCPUの数なので、1~2に設定しておくのが良いと思います。

- また、冒頭でも記載しましたが、「Minimun vCPUs」を 0 に設定しておくと、

起動したインスタンスの実行タスクがなくなってから一時間以内に自動的にterminatedしてくれます。

詳しい設定方法については、下記URLを参照いただければと思う。

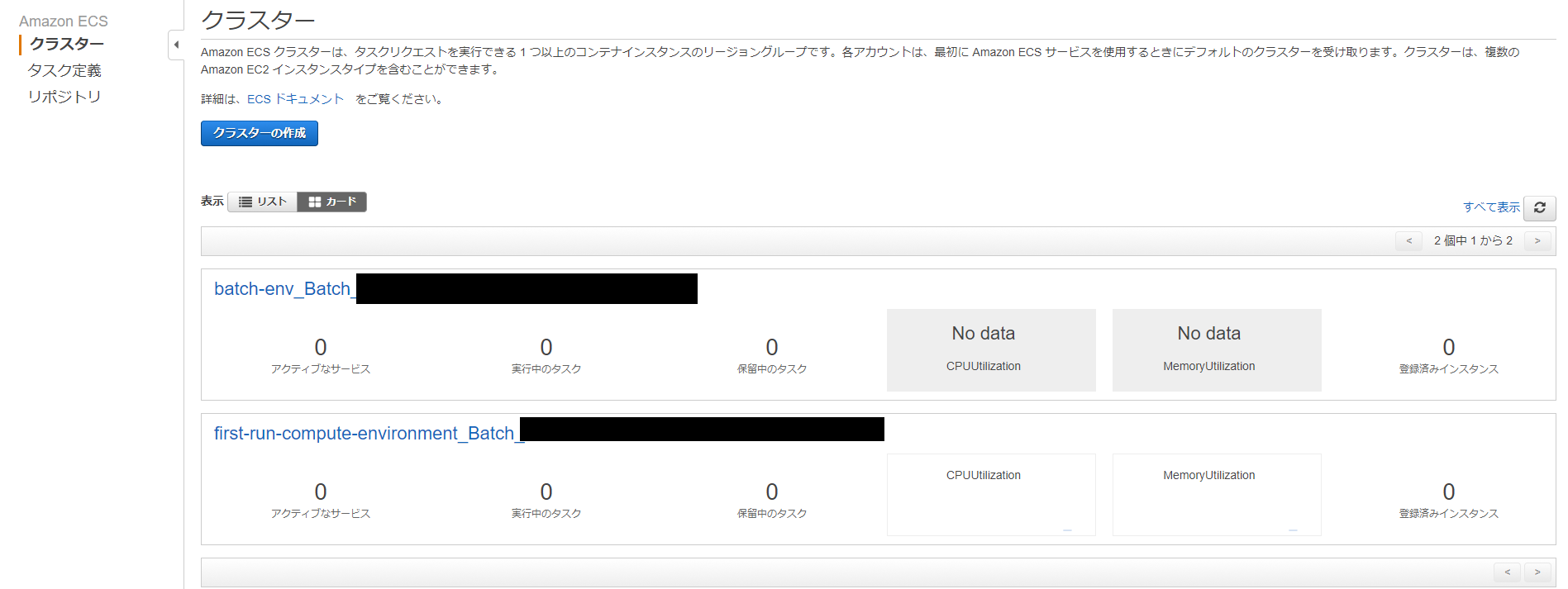

実際に、上記条件で、コンピューティング環境を作成してみると、、

ECSのクラスターが自動生成されていることが確認できると思います。

AWS Batchの裏側ではECSが動いているので、AWS Batchでタスクを実行すると、

こちらでもステータスを確認することができます。

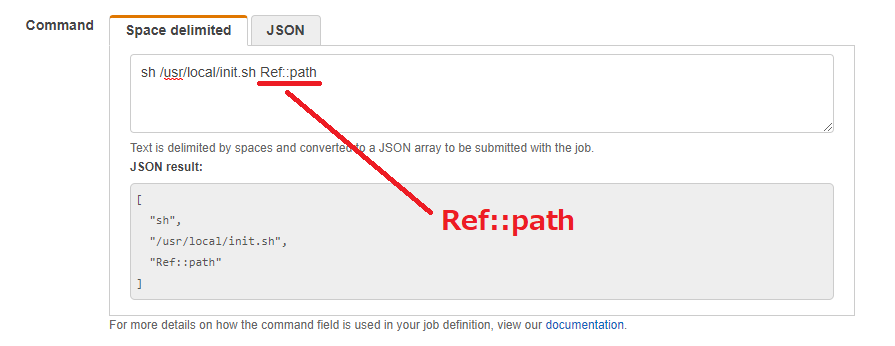

2. job queues の設定

新たにjob queuesを作成します。名前を適当に付けて、「Priority 1」「Select a compute environment 〇〇〇(さきほど作ったコンピューティング環境)」を設定し、Createボタンを押下すれば作業終了です。

続いて、job definitionsの設定に移ります。

3. job definitions の設定

「 02. AWS Lambda関数を作成する 」

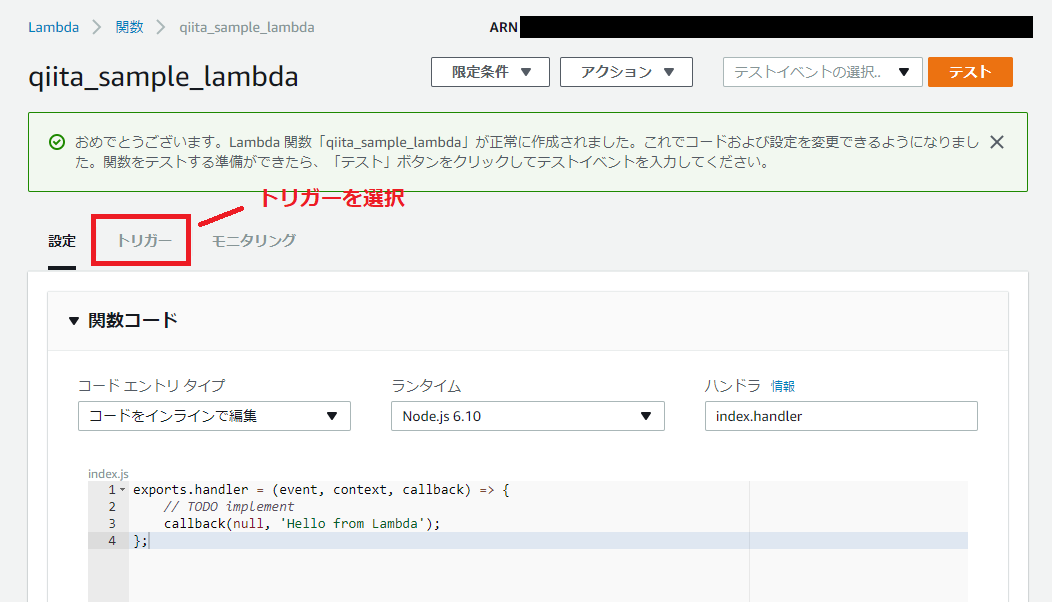

1. 名前と、Lambda関数を実行するロールを選択します。

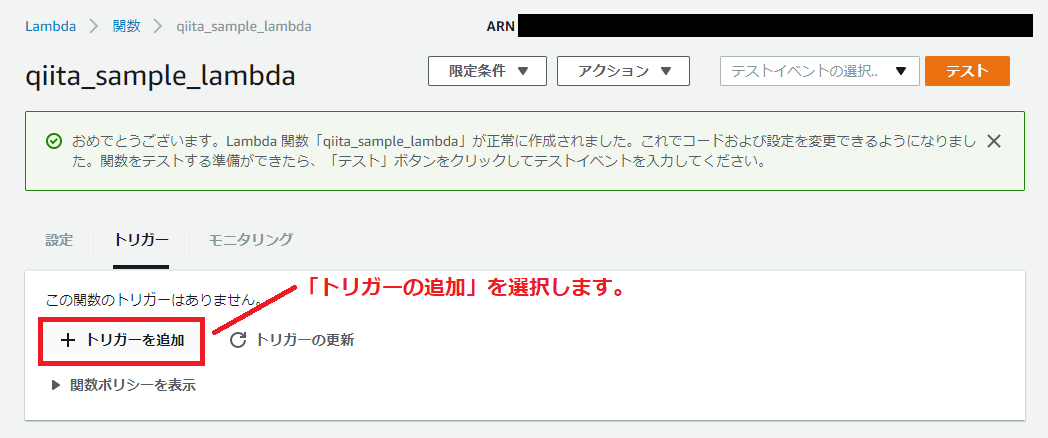

2. トリガーの設定を行います。

3. 設定を追加します。

2.で指定したイベントが発生すると、「AWS Batch」へ「job」を投げるソースコードを追加します。

今回は、コードを__インライン__で編集しますが、__ZIPファイル__や__S3__から読み込むことも可能です。

'use strict';

const AWS = require('aws-sdk');

const S3 = new AWS.S3();

// AWS Batch Setting

const BATCH = new AWS.Batch({apiVersion: '2016-08-10'});

const JOBDEFINITION = 'YOUR_JOBDEFINITION';

const JOBQUEUE = 'YOUR_JOBQUEUE';

console.log('Loading function');

exports.handler = (event, context, callback) => {

// どこにファイルがアップロードされたのかを検知します。

let bucket = event.Records[0].s3.bucket.name;

let key = event.Records[0].s3.object.key;

let filePath = bucket + '/' + key;

console.log(filePath);

let params = {

jobDefinition: JOBDEFINITION,

jobName: 'JOB_NAME(任意の値)',

jobQueue: JOBQUEUE,

parameters: { 'path' : filePath } // jobにパラメータを付加することも可能です。

};

// Submit the Batch Job

BATCH.submitJob(params, function (err, data) {

if (err) console.log(err, err.stack);

else console.log(data);

if (err) {

console.error(err);

const message = `Error calling SubmitJob for: ${event.jobName}`;

console.error(message);

callback(message);

} else {

const jobId = data.jobId;

console.log('jobId:', jobId);

callback(null, jobId);

}

});

};

jobをサブミットする際に、任意のパラメーターも付与することができますが、

job queues側で事前に設定していないとエラーがでるので、ご注意ください。

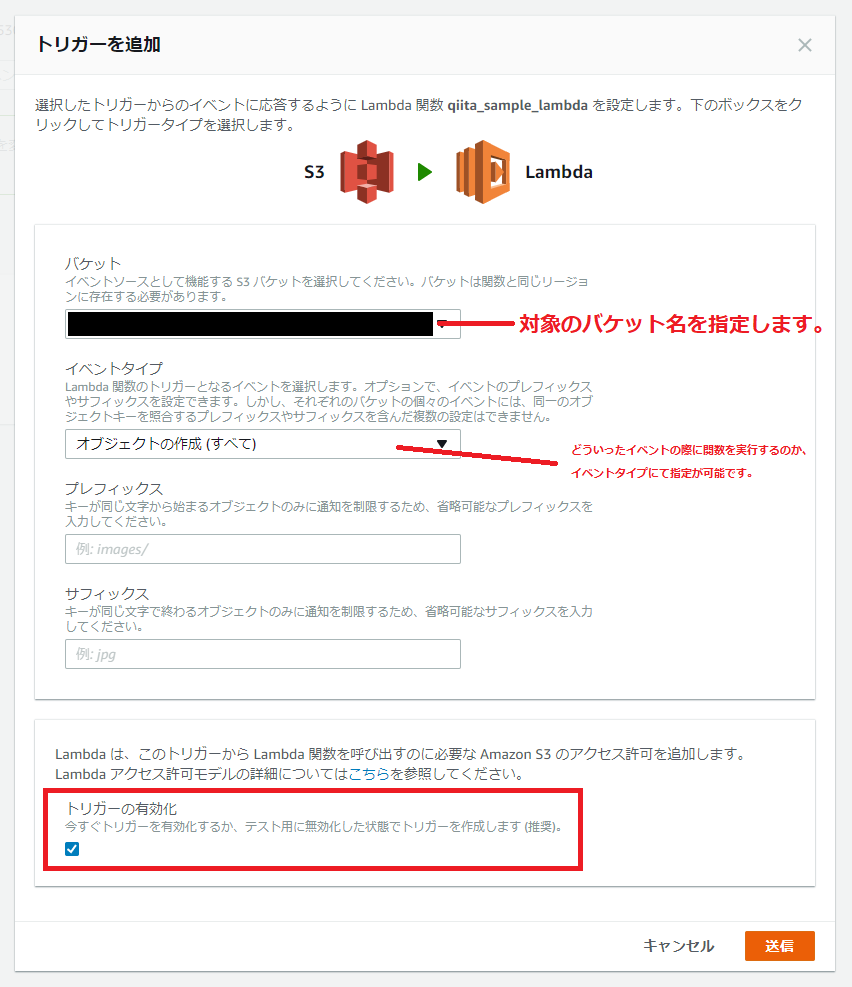

ちなみに、上記ソースコードのparameter:pathをjob実行時に使用したい場合は、

下記のように設定することができます。

詳しくは、下記公式サイトをご参照ください。

http://docs.aws.amazon.com/batch/latest/userguide/job_definition_parameters.html

「 03. 実際に作成したLambda関数を動かしてみる。 」

実際に、S3 (トリガーで設定したバケット) にファイルをアップロードしてみると、

関数が実行されることが分かると思います。AWS Batchのダッシュボードにて job のステータスを確認することが可能です。

「 04. おわりに 」

実際に手を動かして、作業を行うことで知識が身につくと思うので、

みなさんも是非試してみてください。最後までお読みいただき、ありがとうございました。

記事も随時アップデートしていく予定なので、「いいね」よろしくお願いいたします。