Scene understanding とは ..

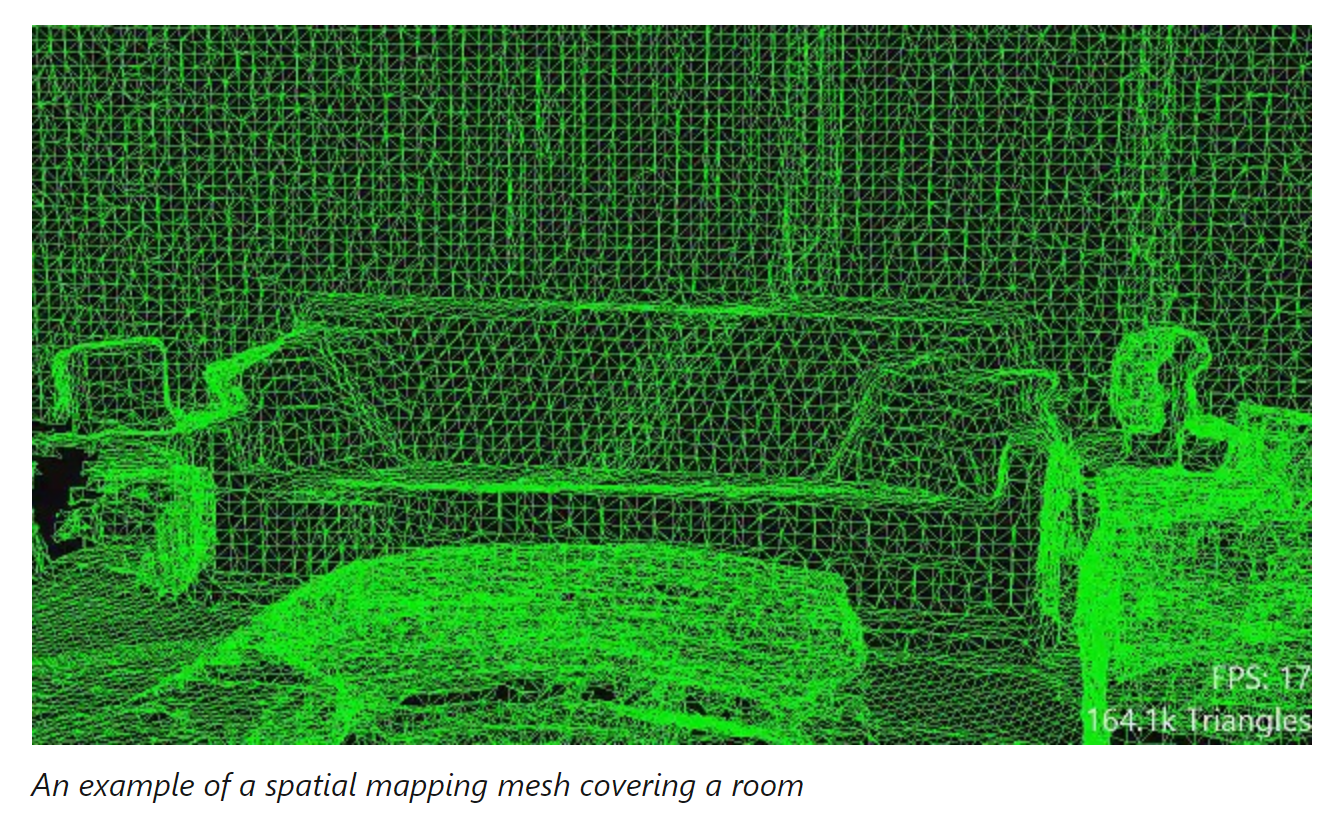

Scene understanding ( Runtime / SDK ) は Mixed Reality の開発者に対して 環境認識アプリケーションの開発を直観的に行うために設計された高いレベルの環境描画の構造 ( 仕組み ) を提供します。Scene understanding は、既存の Mixed Reality ランタイムの処理内容を統合し、実現されます。 ( 構造化されていない高い精度を持つ環境マッピング [ Spatial mapping ] 、新たなAI駆動のランタイム ) これらの技術を統合することによって、Unity や ARKit / ARCore で使用したことがあるような 3次元の環境描画を実現します。Scene understanding のエントリーポイントは Scene obserber で、アプリケーション内で新たなシーンを計算する際に処理が開始されます。現在、この技術は3つの異なる関連オブジェクトカテゴリを生成することができます。 ( Wireframe, Mesh, Quads )

実際にサンプルプロジェクトを動かしてみた動画

HoloLens 2 新機能

— Futo Horio (@Futo_Horio) February 27, 2020

Scene understanding を試してみた。

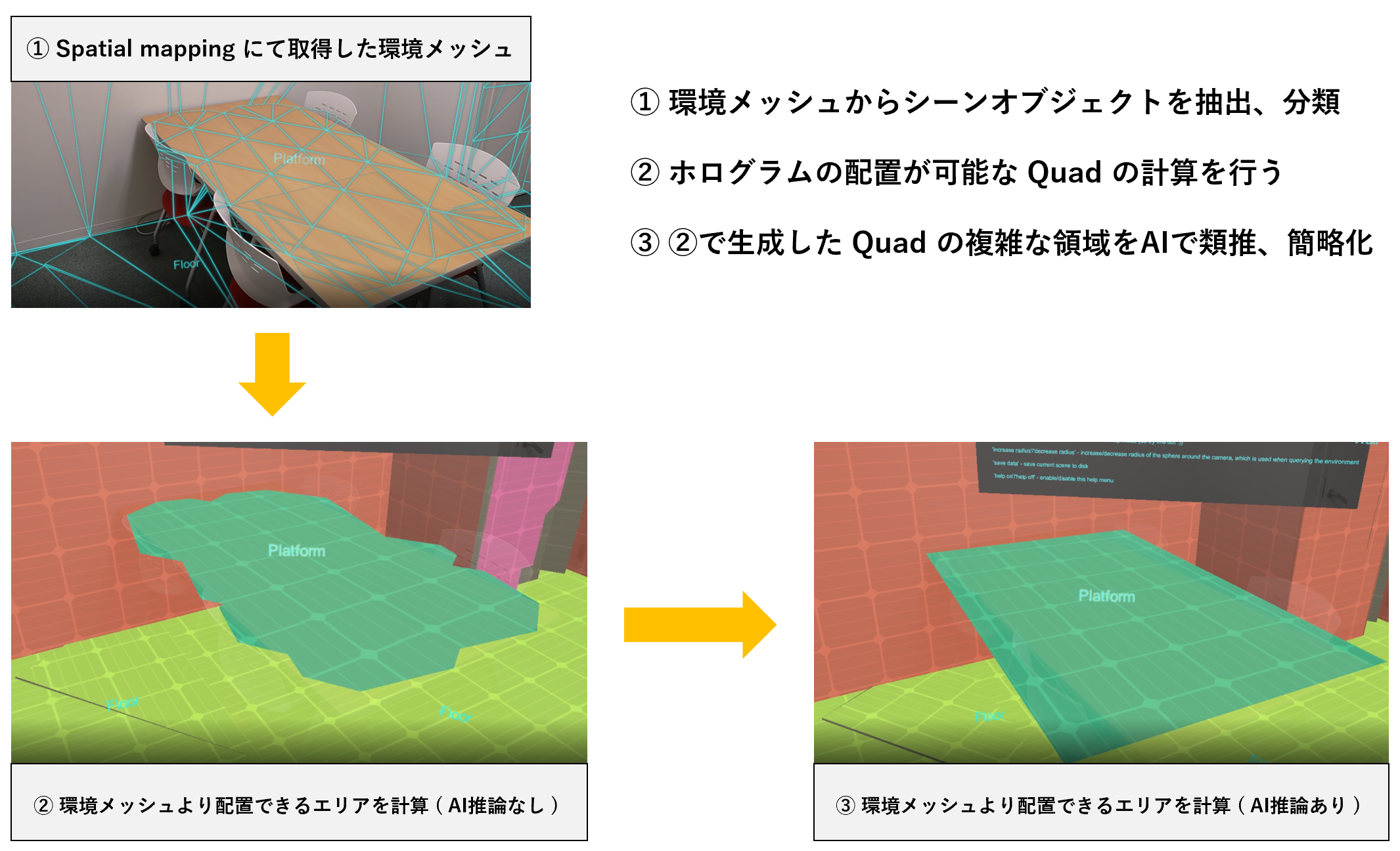

Spatial Mapping で取得した

環境メッシュデータを処理して、

壁、床、天井 etc に分類したり..

複雑な形状の環境メッシュでも

AIの推論機能を駆使して、

シンプルな Quad に変換してくれる。#HoloLens2 #MixedReality#SpatialComputing pic.twitter.com/ldygDqWldD

Scene understanding を使えば..

Mixed Reality デバイスから取得した非構造な環境センサーデータ ( Spatial mapping ) を直観的かつ容易な開発が実現できるよう抽象化された表現への変換を行ってくれます。

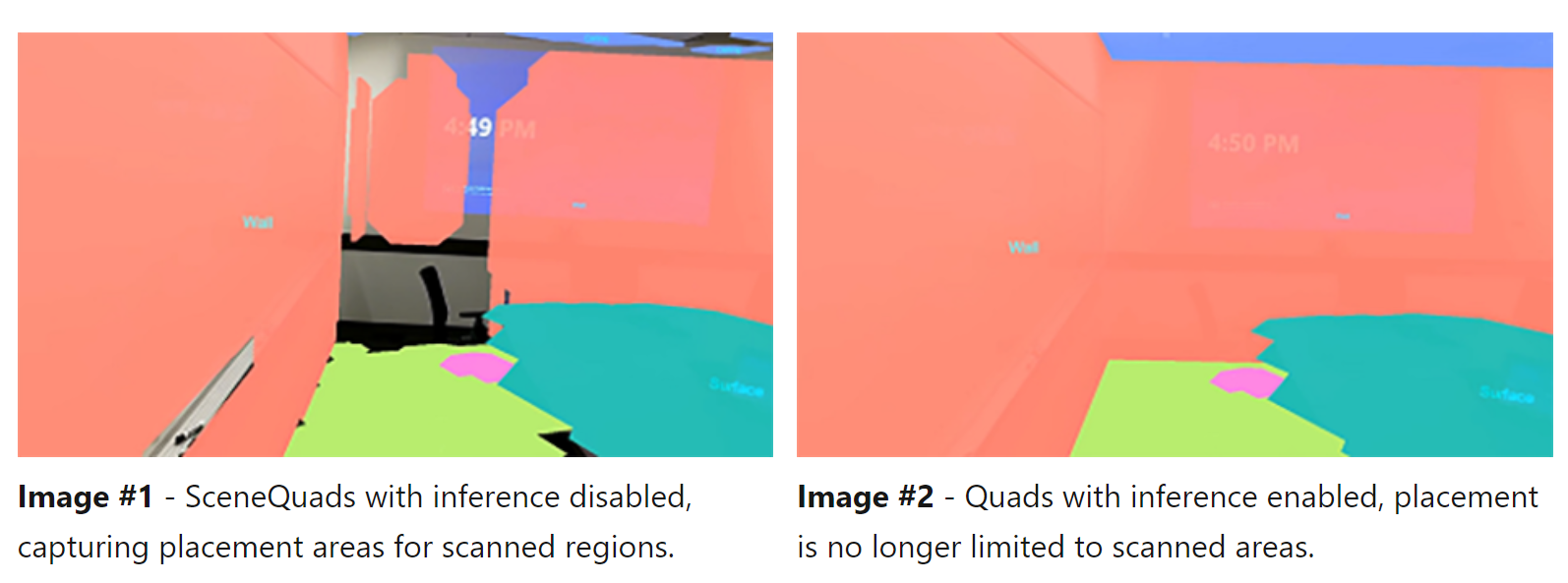

≒ Spatial mapping で取得できる環境メッシュデータを利用して、環境メッシュデータ内からオブジェクトを抽出 ( SceneObject ) 、そのオブジェクトが何であるかを分類 ( SceneObjectKind ) し、環境メッシュデータが粗く、複雑な箇所はAIを駆使して類推、シンプルな Plane として開発者が扱いやすいデータ構造とAPIを提供してくれる新機能。これらを実現すべく新たに機能追加されたのが、今回ご紹介する Scene understanding Runtime / SDK です。

上記のような空間マップのミニマップ化を実行することも可能です。

Scene understanding : 対応デバイス

Scene understanding Runtime を活用するための Scene understanding SDK は NuGet から入手することが可能です。Scene understanding をサポートしているMRデバイスは、現状 HoloLens 2 のみです。

| 機能 | HoloLens ( 1st gen ) | HoloLens 2 | Immersive Headsets |

|---|---|---|---|

| Scene understanding | × | ✅ | × |

※ これらの機能はPC上で検証を行うことも可能です。

詳しくは「Where can I get samples scenes?」をご確認ください。

「 Spatial mapping 」 vs 「 Scene understanding 」

環境認識アプリケーションの核となるシナリオ ( CGの配置、オクルージョン、ナビゲーションなど ) の多くは、 Spatial Mapping と Scene Understanding のどちらか一方を活用すれば実現することができます。

では、なぜ同様の機能を持つ ( と思われる ) Spatial mapping と Scene understanding が切り分けられているのでしょうか?

「 Spatial mapping 」 と 「 Scene understanding 」 の大きな違いは、 Spatial mapping データへのアクセス構造とシンプルさ ( structure & simplicity ) に対する精度 ( accuracy ) と 遅延 ( latency ) のトレードオフ にあります。

空間マッピングデータへのアクセス、更新頻度について

それぞれの特徴と空間マッピングデータをどのように活用できるのか整理しました。

- 「 Spatial mapping API 」 を使用する場合

- 空間マッピングデータへのアクセス制限 :

限定的な範囲 - ユーザーの周りわずかな範囲のキャッシュされた空間マッピングデータをアプリケーションから利用することが可能

-

SurfaceChangedイベントを通じて低遅延でのメッシュの更新が可能 - 「 Scene understanding SDK 」 を使用する場合

- 空間マッピングデータへのアクセス制限 :

無制限 - 空間マッピングデータのスナップショットも利用することが可能

- Query で指定した範囲の空間マッピングデータを全て使用することが可能 ( デフォルト: 10m )

Spatial mapping ランタイムはどこに物体 ( Objects ) が存在しているのか?という空間マッピングデータを提供してくれますが、これらのオブジェクトが何 ( What ) であるのか?という情報に関しては提供してくれません。HoloLens 2 で提供される Scene understanding の能力は、この Spatial mapping で取得した空間マッピングデータにさらに処理を加え、意味のあるオブジェクト単位に分割することで空間マップの理解深めてくれます。Scene understanding ランタイムは、空間マップを取得し、空間マップ内に含まれるオブジェクトを分割 ( SceneObjects ) 、分類 ( SceneObjectKind ) し、マッピングデータだけでは穴が空いた状態になってしまう箇所に対して防水メッシュを作成することが可能です。( ※AIモデルで推論を実行 )

| Spatial mapping |

Spatial mapping より画像引用 |

|---|---|

| Scene understanding |

Scene understanding より画像引用 |

SceneObjectKind

Scene Understanding は、空間マップ内のオブジェクトを以下7つのカテゴリーにに分類することができます。

| SceneObjectKind | 概要 |

|---|---|

| Background | 「 他のラベルに属さないオブジェクト 」 を表すラベル。Unknown とは異なるので注意。 |

| Wall | 物理世界 ( 現実 ) における 「 壁 」 表すラベル |

| Floor | 物理世界 ( 現実 ) における 「 床 」 を表すラベル |

| Ceiling | 物理世界 ( 現実 ) における 「 天井 」 を表すラベル |

| Platform | ホログラムを配置できる 「 平らな表面 」 を表すラベル( ex. テーブル、カウンター etc..) |

| World | 「 ラベル付けが行われない幾何学データ 」 を表すラベル ( 恐らくメッシュが複雑な箇所で表示される ) |

| Unknown | 「 まだ分類ラベルが作成されていないオブジェクト 」 を表すラベル。Backgroundとは異なるので注意。現時点での分類カテゴリに属さない Something という位置づけ |

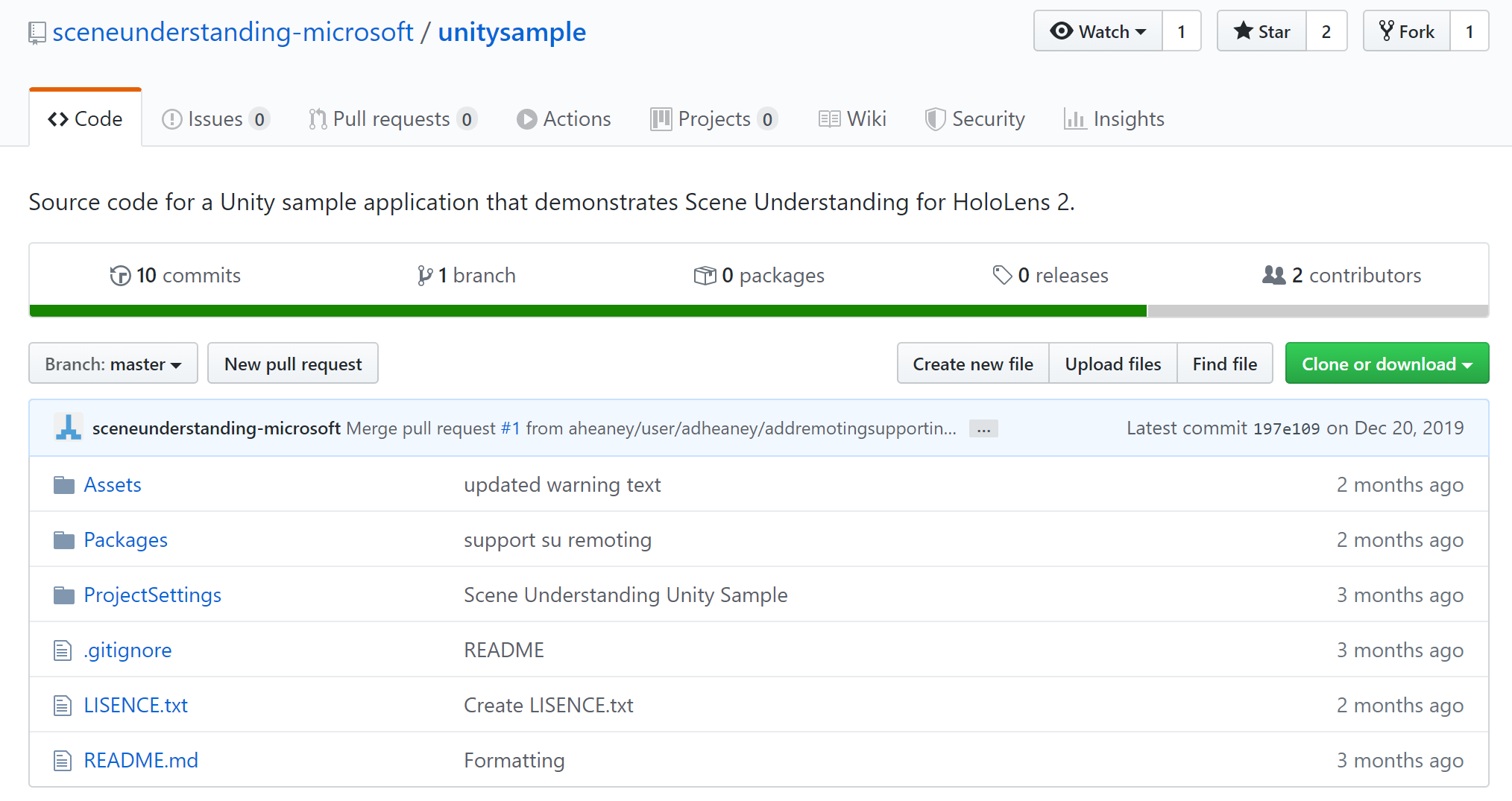

それでは早速、GitHub 上で公開されているサンプルを動かしてみたいと思います。

今回検証に使うサンプル

公式ドキュメントで紹介されている unitysample を使用します。

- sceneunderstanding-microsoft/unitysample ( GitHub )

動作環境

- Unity 2018.4.12.* or greater.

- Visual Studio 2017 or 2019 with Universal Windows Platform components.

- Windows SDK version 10.0.18362.0 or greater.

サンプル導入手順

-

sceneunderstanding-microsoft/unitysample からソースコードを

git cloneする - 対象シーン (

SceneUnderstandingSample.unity) を開く -

【 Hierarchy 】 SceneUnderstandingManager > 【 Inspector 】 [Scene Understanding Data Provider (Script)] > ✅ Run Device にチェックが入っているかどうか確認。

( チェックが入っていない場合は、チェックを入れる。) - ビルド実行

- HoloLens 2 へのデプロイ

SceneUnderstandingManager

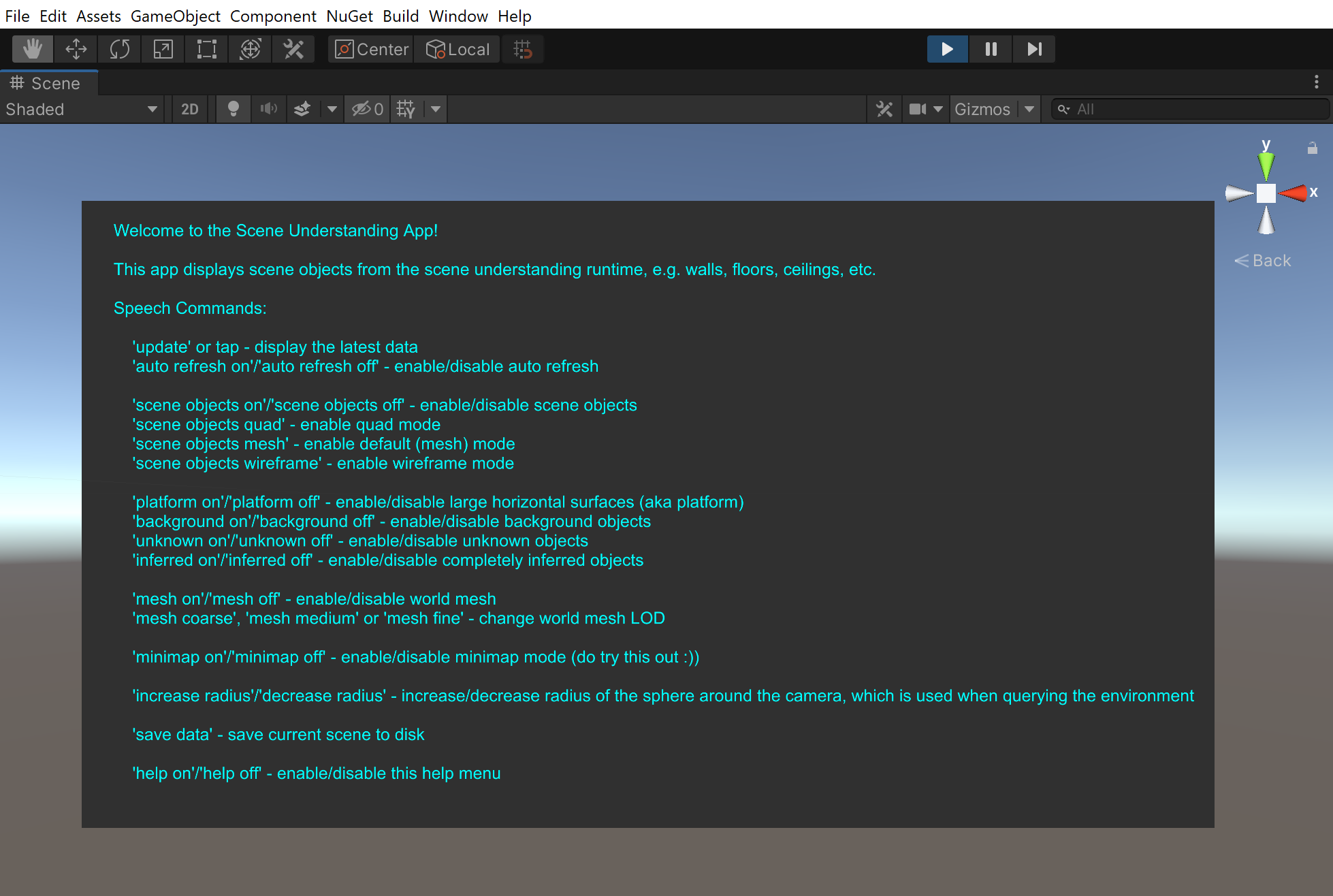

サンプル 「SceneUnderstandingManager.unity」 では、以下機能を試すことが可能です。

| ボイスコマンド (音声認識) | 処理内容 |

|---|---|

| Update ( / tap ) | 最新の空間情報に更新します。 |

| scene objects on / off | シーンオブジェクトの表示/非表示を切り替え |

| scene objects quad | quad mode をオンにする |

| scene objects mesh | mesh mode をオンにする |

| scene objects wireframe | wireframe mode をオンにする |

| platform on / off | 水平面の大きな境界線の表示/非表示 |

| background on / off | 背景にあるオブジェクトの表示/非表示 |

| unknown on / off | unknown オブジェクトの表示/非表示 |

| inferred on / off | 環境データから推測されたオブジェクトの表示/非表示 |

| mesh on / off | ワールドメッシュの表示/非表示 |

| mesh coarse (粗い), mesh medium (中程度), mesh fine (高精細) | ワールドメッシュの LOD ( Level of detail : 細かさの粒度 ) の切り替え |

| minimap on / off | ミニマップの表示/非表示 |

| increase radius ( 広げる ) / decrease radius ( 狭める ) | 取得する環境データのカメラからの半径 |

| save data | Scene understanding データを保存する |

| help on / off | ヘルプの表示/非表示 |

SceneUnderstandingSample シーン : 処理内容について

今回、Scene understanding の挙動を理解するために使用したサンプルですが、実際どのようなロジックで動作しているのか?簡単にソースコードを追っかけてみたいと思います。基本的に必要なスクリプトは__「SceneUnderstandingManager」__ にアタッチされています。

まず Scene understanding の 初期化を行います。

SceneUnderstandingDataProvider.cs (104行目) にて、デバイスが Scene understanding 対応デバイスであるかどうか 「SceneUnderstanding.SceneObserver.IsSupported()」 を確認し、「await SceneUnderstanding.SceneObserver.RequestAccessAsync();」 にて Scene understanding が必要とする情報へのアクセスを要求する必要します。

/// <summary>

/// Initialization.

/// </summary>

private async void Start()

{

if (RunOnDevice)

{

if (Application.isEditor)

{

Logger.LogWarning("SceneUnderstandingDataProvider.Start: Running in editor with the RunOnDevice mode set is not supported.");

}

if (SceneUnderstanding.SceneObserver.IsSupported())

{

var access = await SceneUnderstanding.SceneObserver.RequestAccessAsync();

if (access != SceneObserverAccessStatus.Allowed)

{

Logger.LogError("SceneUnderstandingDataProvider.Start: Access to Scene Understanding has been denied. Reason: " + access);

return;

}

// At the beginning, retrieve only the observed scene object meshes.

RetrieveData(BoundingSphereRadiusInMeters, false, true, false, false, SceneUnderstanding.SceneMeshLevelOfDetail.Coarse);

// Then, spin off a background thread to continually retrieve SU data.

Task.Run(() => RetrieveDataContinuously());

}

else

{

Logger.LogError("SceneUnderstandingDataProvider.Start: Scene Understanding not supported.");

return;

}

}

次に、RetrieveData関数内のtry-catch句にて、scene understanding のクエリを設定します。SceneUnderstandingDataProvider.cs (167行目) シーンオブジェクトの種類、ワールドメッシュの有無、メッシュの粗さなどを設定し、SceneUnderstandingDataProvider.cs (177行目)「SceneUnderstanding.SceneObserver.ComputeSerializedAsync(querySettings, boundingSphereRadiusInMeters).GetAwaiter().GetResult();」 にて新規シーンの計算を実行します。

/// <summary>

/// Calls into the Scene Understanding APIs, to retrieve the latest scene as a byte array.

/// </summary>

/// <param name="enableQuads">When enabled, quad representation of scene objects is retrieved.</param>

/// <param name="enableMeshes">When enabled, mesh representation of scene objects is retrieved.</param>

/// <param name="enableInference">When enabled, both observed and inferred scene objects are retrieved. Otherwise, only observed scene objects are retrieved.</param>

/// <param name="enableWorldMesh">When enabled, retrieves the world mesh.</param>

/// <param name="lod">If world mesh is enabled, lod controls the resolution of the mesh returned.</param>

private void RetrieveData(float boundingSphereRadiusInMeters, bool enableQuads, bool enableMeshes, bool enableInference, bool enableWorldMesh, SceneUnderstanding.SceneMeshLevelOfDetail lod)

{

Logger.Log("SceneUnderstandingDataProvider.RetrieveData: Started.");

Stopwatch stopwatch = new Stopwatch();

stopwatch.Start();

try

{

SceneUnderstanding.SceneQuerySettings querySettings;

querySettings.EnableSceneObjectQuads = enableQuads;

querySettings.EnableSceneObjectMeshes = enableMeshes;

querySettings.EnableOnlyObservedSceneObjects = !enableInference;

querySettings.EnableWorldMesh = enableWorldMesh;

querySettings.RequestedMeshLevelOfDetail = lod;

// Ensure that the bounding radius is within the min/max range.

boundingSphereRadiusInMeters = Mathf.Clamp(boundingSphereRadiusInMeters, _minBoundingSphereRadiusInMeters, _maxBoundingSphereRadiusInMeters);

var serializedScene = SceneUnderstanding.SceneObserver.ComputeSerializedAsync(querySettings, boundingSphereRadiusInMeters).GetAwaiter().GetResult();

lock(_latestSerializedSceneLock)

{

_latestSerializedScene = new byte[serializedScene.Size];

serializedScene.GetData(_latestSerializedScene);

_latestSceneGuid = Guid.NewGuid();

}

}

catch(Exception e)

{

Logger.LogException(e);

}

参考文献

- Microsoft.MixedReality.SceneUnderstanding.Samples - UnitySample

- Scene understanding SDK overview

- Spatial mapping

- HoloLens 2 & Scene Understanding

おわりに

やってみた感じ、CG配置するのとオクルージョンをする際に非常に役立つと思います。ただ、体感の精度は非常に良いとまではいかないので実際にCGを配置してみて、どれくらいのUXの向上が見込まれるのかはこれから試してみようと思います。機械翻訳ではなく、自分で英語のドキュメントを翻訳しながら書いたので少しドキュメントの内容とズレている箇所があるかもしれませんが、ご了承いただけますと幸いです。Twitter ( @Futo_Horio ) でも Mixed Reality 関連の情報を発信しているので、そちらもご覧ください。最後までお読みいただき、ありがとうございました。

備考

Runtime ( ランタイム ) ・・・ アプリケーションの開発・実行の両方の機能を備えたソフトウェアから、開発の機能を除き、実効の機能のみを取り出したプログラムのことである。

NuGet ・・・ .NET Framework に対応する Free & Open source のパッケージマネージャーを指す。