市場では、光モジュールとGPUの比率を計算するための複数のアプローチが存在し、一貫性のない結果をもたらしています。これらの違いの主な原因は、さまざまなネットワーク構造に実装される光モジュールの数の変動に由来しています。必要な光モジュールの正確な数量は、いくつかの重要な要因に主に依存しています。

ネットワークカードモデル

主に2つのネットワークカードが含まれており、ConnectX-6(200Gb/s、主にA100と使用される)とConnectX-7(400Gb/s、主にH100と使用される)です。

同時に、次世代のConnectX-8 800Gb/sが2024年にリリースされる予定です。

スイッチモデル

主に2種類のスイッチが含まれており、QM 9700スイッチ(32ポートOSFP 2x400Gb/s)があります。合計64チャンネルの400Gb/sの転送速度と、合計51.2Tb/sのスループット速度があります。

そして、QM8700スイッチ(40ポートQSFP56)があります。合計40チャンネルの200Gb/sの転送速度と、合計16Tb/sのスループット速度があります。

ユニット数(スケーラブルユニット)

ユニットの数は、スイッチネットワークのアーキテクチャの構成を決定します。数量が少ない場合は二層構造が採用され、数量が多い場合は三層アーキテクチャが導入されます。

H100 SuperPOD: 各ユニットは32ノード(DGX H100サーバー)で構成され、最大4ユニットをクラスターとして形成するために、二層スイッチングアーキテクチャがサポートされています。

A100 SuperPOD: 各ユニットは20ノード(DGX A100サーバー)で構成され、最大7ユニットをクラスターとして形成することができます。ただし、ユニットの数が5を超える場合は、三層スイッチングアーキテクチャが必要です。

4つのネットワーク構成における光モジュール需要

-

A100+ConnectX6+QM8700三層ネットワーク: 比率は1:6、すべて200G光モジュールを使用します。

-

A100+ConnectX6+QM9700二層ネットワーク: 800G光モジュールの1:0.75 + 200G光モジュールの1:1。

-

H100+ConnectX7+QM9700二層ネットワーク: 800G光モジュールの1:1.5 + 400G光モジュールの1:1。

-

H100+ConnectX8(未発売)+QM9700三層ネットワーク: 比率は1:6、すべて800G光モジュールを使用します。

光トランシーバの市場拡大:

2023年にH100が30万個、A100が90万個出荷されると仮定すると、総需要は200Gが315万個、400Gが30万個、800G光モジュールが787万5千個となります。これにより、AI市場は13.8億ドルの大幅な拡大が予想されます。

2024年にH100が150万個、A100が150万個出荷される場合、総需要は200Gが75万個、400Gが75万個、800G光モジュールが675万個となります。 これにより、AI市場は目覚ましい成長を遂げ、その規模は49億7,000万ドルと推定され、これは2021年の光モジュール業界の市場規模を合わせた規模にほぼ匹敵します。

以下は、それぞれのシナリオに関する計算の詳細な分析です:

第一のケース:A100 + ConnectX6 + QM8700の三層ネットワーク

A100 GPUは8つのコンピュートインターフェースを備えており、図に示すように左側に4つ、右側に4つのインターフェースが均等に配置されています。現在、A100 GPUのほとんどの出荷品はConnectX-6と組み合わせて外部通信に使用されており、最大200Gb/sの接続速度を提供しています。

第一層アーキテクチャでは、各ノードには8つのインターフェース(ポート)があり、ノードは8つのリーフスイッチに接続されます。20ノードごとに1つのユニット(SU)が形成されます。したがって、第一層では、8xSU個のリーフスイッチ、8xSUx20本のケーブル、および2x8xSUx20個の200G光モジュールが必要です。

第二層のアーキテクチャでは、ノンブロッキング設計を使用するため、上り速度は下り速度と同じです。第一層では、片方向の総伝送速度はケーブルの数に200Gを乗じたものです。第二層も1本のケーブルあたりの伝送速度が200Gであるため、第二層のケーブル数は第一層と同じであり、8xSUx20本のケーブルと2x8xSUx20個の200G光モジュールが必要です。必要なスパインスイッチの数は、ケーブルの数をリーフスイッチの数で割ることで計算され、(8xSUx200) / (8xSU)のスパインスイッチが必要になります。ただし、リーフスイッチが十分でない場合、スパインスイッチの数を節約するために、リーフスイッチとスパインスイッチの間に複数の接続を持つことができます(ただし、40のインターフェースの制限を超えないようにします)。したがって、ユニット数が1/2/4/5の場合、必要なスパインスイッチの数は4/10/20/20であり、必要な光モジュールの数は320/640/1280/1600です。スパインスイッチの数は比例して増えませんが、光モジュールの数は増えます。

システムが7つのユニットに拡張されると、第三層のアーキテクチャ設定の実装が必要になります。ノンブロッキング構成を採用しているため、第三層で必要なケーブルの数は、第二層と変わりません。

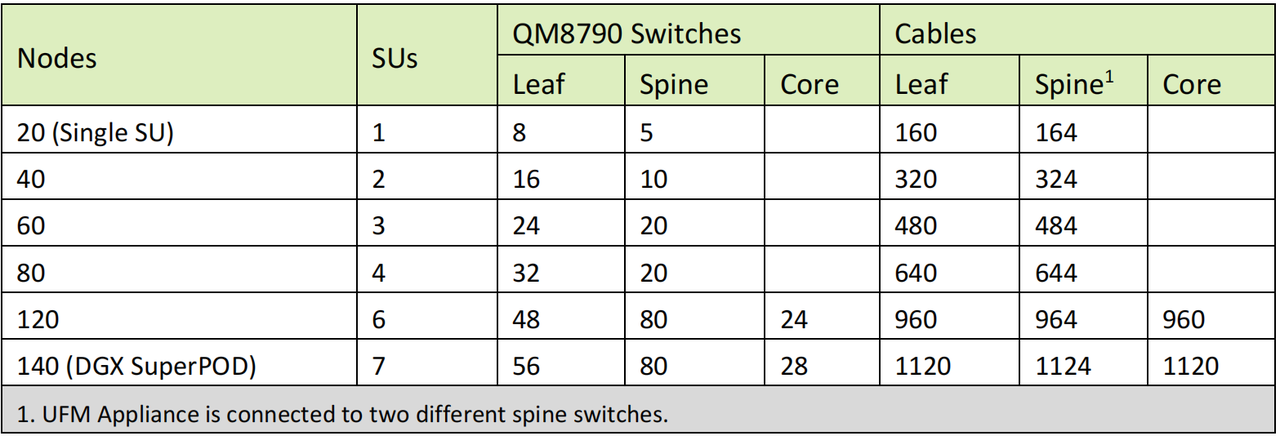

NVIDIAが提案するSuperPODの設計図では、7つのユニット間でのネットワーキングの統合、第三層アーキテクチャの導入、およびコアスイッチの採用が含まれています。詳細なグラフィックでは、異なる層でのスイッチの数量と、さまざまなユニット数に必要なケーブリングが示されています。

140台のサーバーのセットアップでは、合計で1,120個のA100 GPUが使用されます。これは、140台のサーバーを8で乗算することで得られます。この構成をサポートするために、140台のQM8790スイッチが展開され、3,360本のケーブルが必要です。さらに、6,720個の200G光モジュールの使用も必要です。A100 GPUと200G光モジュールの比率は1対6であり、1,120個のGPUに対して6,720個の光モジュールが対応します。

第二のケース:A100 + ConnectX6 + QM9700の二層ネットワーク

現時点では、述べられている特定の配置は提案されている設定の一部ではありません。ただし、時間の経過とともに、より多くのA100 GPUがQM9700スイッチを介して接続することを選択する可能性があります。このような変化により、必要な光モジュールの数は減少しますが、800G光モジュールが必要になります。主な違いは、第一層の接続に見られます。現在の方法では、8つの独立した200Gケーブルを使用していますが、これはQSFPからOSFPアダプタの使用に置き換えられ、各アダプタは2つの接続を可能にし、つまり1対4の接続が実現されます。

第一層において、7つのユニットと140台のサーバーを持つクラスターでは、合計で1,120のインターフェースがあります。これは280本の1対4ケーブルに対応し、280個の800Gモジュールと1,120個の200G光モジュールが必要となります。このため、12台のQM9700スイッチが必要です。

第二層では、800Gの接続のみを使用する場合、280x2 = 5600個の800G光モジュールが必要になります。また、QM9700スイッチは9台必要です。

したがって、140台のサーバーと1,120個のA100 GPUには、合計で21台のスイッチ(12台+9台)が必要であり、840個の800G光モジュールと1,120個の200G光モジュールが必要です。

A100 GPUと800G光モジュールの比率は1,120:840であり、これは1:0.75に簡略化されます。A100 GPUと200G光モジュールの比率は1:1です。

第三のケース:H100 + ConnectX7 + QM9700の二層ネットワーク

H100のアーキテクチャの特徴的な点は、カード内に8つのGPUを搭載しながら、8つの400Gネットワーキングカードが装備されており、これらが組み合わされて4つの800Gインターフェースを形成することです。この融合により、800G光モジュールへの相当な需要が生じます。

第一層では、NVIDIAの推奨構成に従い、サーバーインターフェースに1つ接続することが提案されています。これは、2本の光ケーブル(MPO)を使用したツインポート接続によって実現できます。各ケーブルは別々のスイッチに挿入されます。

したがって、第一層では、各ユニットには32台のサーバーがあり、各サーバーは24個のスイッチに接続されます。4ユニットのSuperkPODでは、第一層には合計で48個のリーフスイッチが必要です。

NVIDIAは管理目的(UFM)のために1つのノードを確保することを推奨しています。光モジュールの使用には限定的な影響があるため、128台のサーバーを持つ4ユニットを基に計算を行いましょう。

第一層では、合計で4×128=512個の800G光モジュールと2×4×128=1024個の400G光モジュールが必要です。

第二層では、スイッチは800G光モジュールを使用して直接接続されます。各リーフスイッチは下向きに32x400Gの双方向速度で接続されます。上りの接続では、上り方向の速度を一貫させるために16x800Gの単方向速度が必要です。これにより、16台のスパインスイッチが必要となり、合計で4×8×16×2=1024個の800G光モジュールが必要です。

このアーキテクチャでは、インフラストラクチャは合計で1536個の800G光モジュールと1024個の400G光モジュールを要求します。SuperPODの完全な構成を考慮すると、各々8つのH100 GPUが搭載された128(4x32)台のサーバーが含まれており、合計で1024個のH100 GPUが存在します。したがって、GPUと800G光モジュールの比率は1:1.5で、1024個のGPUに対して1536個の光モジュールが必要です。GPUと400G光モジュールの比率は1:1であり、1024個のGPUに対して1024個の光モジュールが必要です。

第四のケース:H100 + ConnectX8(まだリリースされていない)+ QM9700の三層ネットワーク

この想定されたシナリオでは、H100 GPUがネットワークカードを800Gにアップグレードする場合、外部インターフェースは4つから8つのOSFPインターフェースに拡張する必要があります。それに応じて、インターレイヤーの接続にも800G光モジュールを使用します。基本的なネットワーク設計は最初のシナリオと一貫しており、唯一の変更点は200G光モジュールを800G光モジュールに置き換えることです。したがって、このネットワークフレームワークでは、GPUの数と必要な光モジュールの相関関係は、初期シナリオと同じ1:65の比率を維持します。

上記4つの状況を次のように整理します:

2023年には30万個のH100 GPUと90万個のA100 GPUの出荷が予想されており、それにより、合計で315万個の200G光モジュール、30万個の400G光モジュール、および78万7500個の800G光モジュールが必要となります。2024年には、150万個のH100 GPUと150万個のA100 GPUの出荷が予想されており、需要は75万個の200G光モジュール、75万個の400G光モジュール、そして大量の675万個の800G光モジュールを含んでいます。

-

A100 GPUの場合、接続は200Gスイッチと400Gスイッチの間で均等に分割されます。

-

H100 GPUは、400Gスイッチと800Gスイッチへの接続で均等に分割されます。

結論

技術の進歩と発展に伴い、ネットワーキングの分野では400Gマルチモード光モジュール、AOC(アクティブオプティカルケーブル)、DAC(ダイレクトアタッチケーブル)が登場しています。これらの高速ソリューションは、デジタル時代のネットワーク要求に堅牢なサポートを提供し、さらなる発展の先駆けとなることが期待されています。FSは1Gから800Gまでの幅広い光モジュールを製造することを専門としています。皆様に当社の製品を探索して入手していただくよう、心より歓迎いたします。