とりあえずというレベルですが、Vision Proでllama2が動きました。

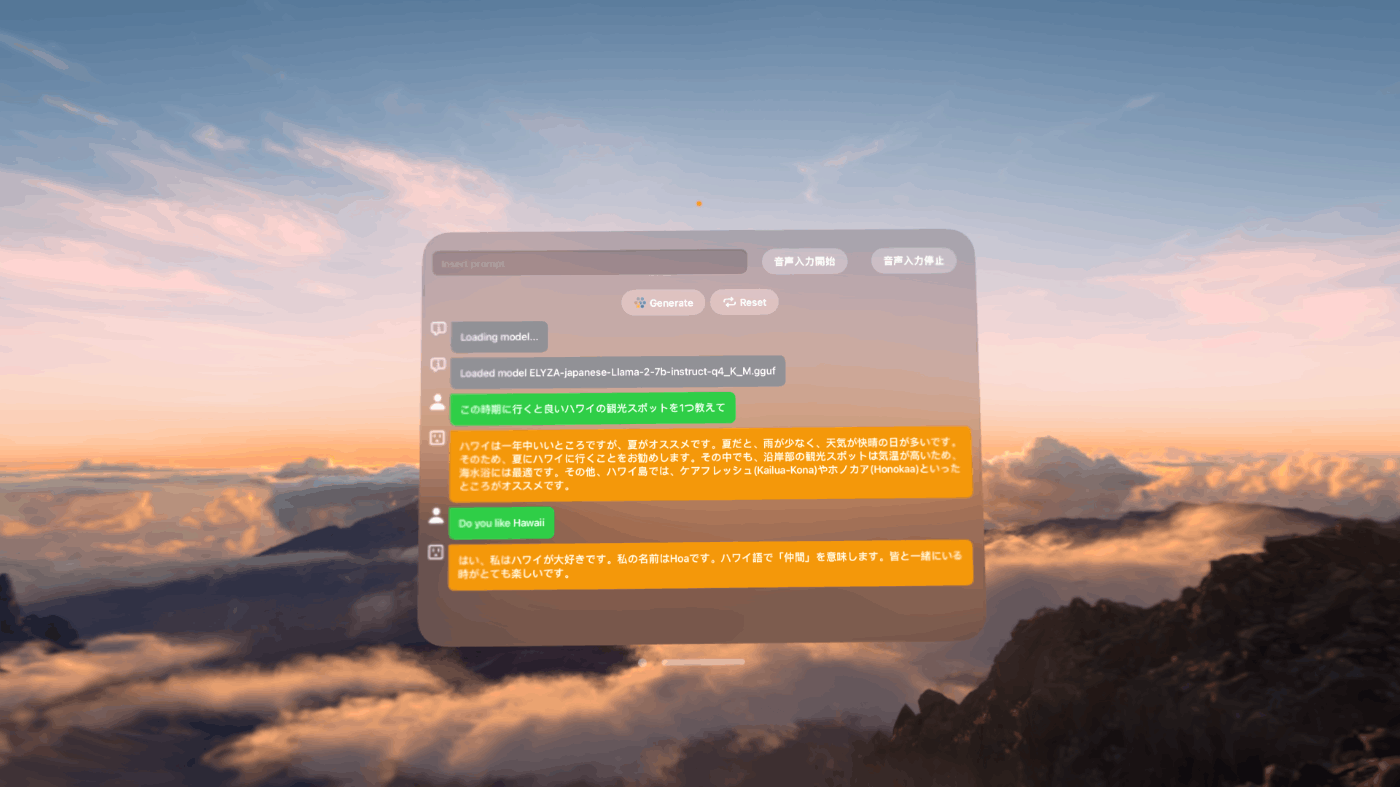

llama.cppのSwiftパッケージを使った日本語チャットSwiftLlamaAppを利用してVision Proネイティブのllama2チャットを作ってみます。

VisionPro内では音声で呼び出したいので音声認識と音声合成を追加することにしました。

イマーシブなハレアカラ頂上で動いています(笑)

現在のVision Proは英語しか使えないというのを忘れており、日本語では音声認識してくれませんでした(ja-JPだと初期化で落ちる)。日本語の音声合成は可能なのに不思議です。

英語の音声認識でllama2に"Do you like Hawaii?"と投げたら、日本語で返してくれました。

「ん?もしかして翻訳みたいな事ができるのかな」と思って識者にたずねたら「言語依存しないで学習していて、バイリンガルのような動作をするらしい」とのことでした。

モデルはELYZA-japanese-Llama-2-7b-instruct-q4_K_Mを使っています。

モデルのサイズが4GBあるのでWiFi接続しかないVisionProへのアプリ初回インストールに10分ほど時間が掛かりました。MacとUSB-C接続できるデベロッパーストラップが欲しいところです(日本からは買えないけど...)

引き続き研究中。

** シンギュラリティ・ソサエティのAI Innovators Hubに参加しています。**