前置き

Googleが出したPixel3のカメラが話題ですね。

暗い場所でも圧倒的な明るさで写真を撮れる、みたいなやつです。

例えば別所さんの記事とか。1000ブクマ到達しそうな勢いです。

Googleの新スマートフォンPixel 3の「夜景モード」が問いかけるもの(あるいはAIとはなんなのかという実感について)

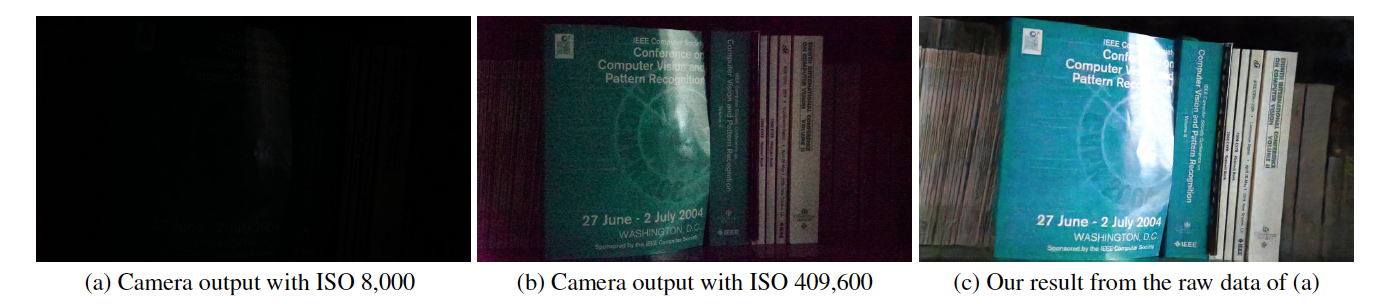

この記事を見て、とりあえず今年5月に出たこの論文を思い出しました。

めっちゃ暗い写真をDeepLearningで明るくするやつ。

普通にすごい。

今回、これをiPhoneのカメラで撮った写真で試してみました。

実装について

論文中では実装についてはざっくりと触れられている程度ですが、github上にコード一式が置かれています。

論文を読む前はGANに暗い画像ぶちこんでるのかなと思っていましたが、コード見てもらえれば分かる通り実際はU-Netでした。

想像通り、暗いRAW画像 -> 明るい画像 という変換を行っています。

特徴としては入力がRAWなので、通常の画像のような3channelではなく、4channel(RGBG)になってます。

また、明るさを調節するためのレートを事前に指定します。

RAW画像のデータをネットワークに入力する前に画素値にレートを掛けています。

iPhoneで試してみた

というわけで、実際に動いてるところが見たいなと思ったので動かしてみました。

iPhoneで撮った写真を明るくしてみます。

動かした環境

- Python 3.6.7

- tensorflow 1.1.0

二通りの学習モデルが用意されています。

SonyのベイヤーセンサーとFujifilmのX-transセンサー。

何も考えず脳死で手持ちのRAW画像をぶち込んでみました。ちなみにPanasonicのミラーレスとiPhoneのRAW持ってます。どちらもベイヤーセンサーのはずなのでSonyのモデルで試します。

# test_Sony.py上で適当に

raw = rawpy.imread(filename)

input_full = np.expand_dims(pack_raw(raw), axis=0) * ratio

output = sess.run(out_image, feed_dict={in_image: input_full})

output = np.minimum(np.maximum(output, 0), 1)

output = output[0, :, :, :]

plt.imshow(output)

plt.show()

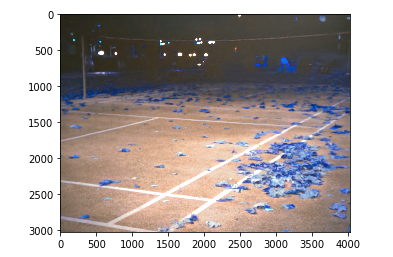

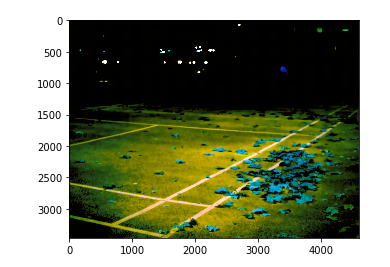

色がおかしいのですが。。。

RGBGの順番が違うのかなと思ってpixel部分の並びを総当たりしてみる。

総当たりするときPythonだとitertools.permutations([0,1,2,3])で一行で書けるので便利ですね。

input_full = np.expand_dims(pack_raw(raw)[:,:,perm], axis=0) * ratio

二行目の部分を上のように書き換えて、pixel部分の順番(perm部分)を(2, 1, 0, 3)もしくは(2, 3, 0, 1)にするとiPhoneのRAWは自然な色合いになりました。

PanasonicのRAWはどの順番でも色合いが変でした。自社センサー積んでるカメラなのでSonyセンサーのモデルと相性が悪いんでしょうね。

比較

RAWをそのままjpeg化したものと、ネットワークに入力したものの比較をしてみます。

ネットワーク自体はSonyの(それもフルサイズの)ミラーレスで撮った画像で学習が行われているので、iPhoneでうまくいくかというと微妙なところです。

実用を目指すなら、iPhoneで撮った写真のデータセット集めてFine-tuningする必要がありそう。

今回はiPhoneで撮ったRAW画像を、直接Sonyで学習したモデルに突っ込んだ結果です。

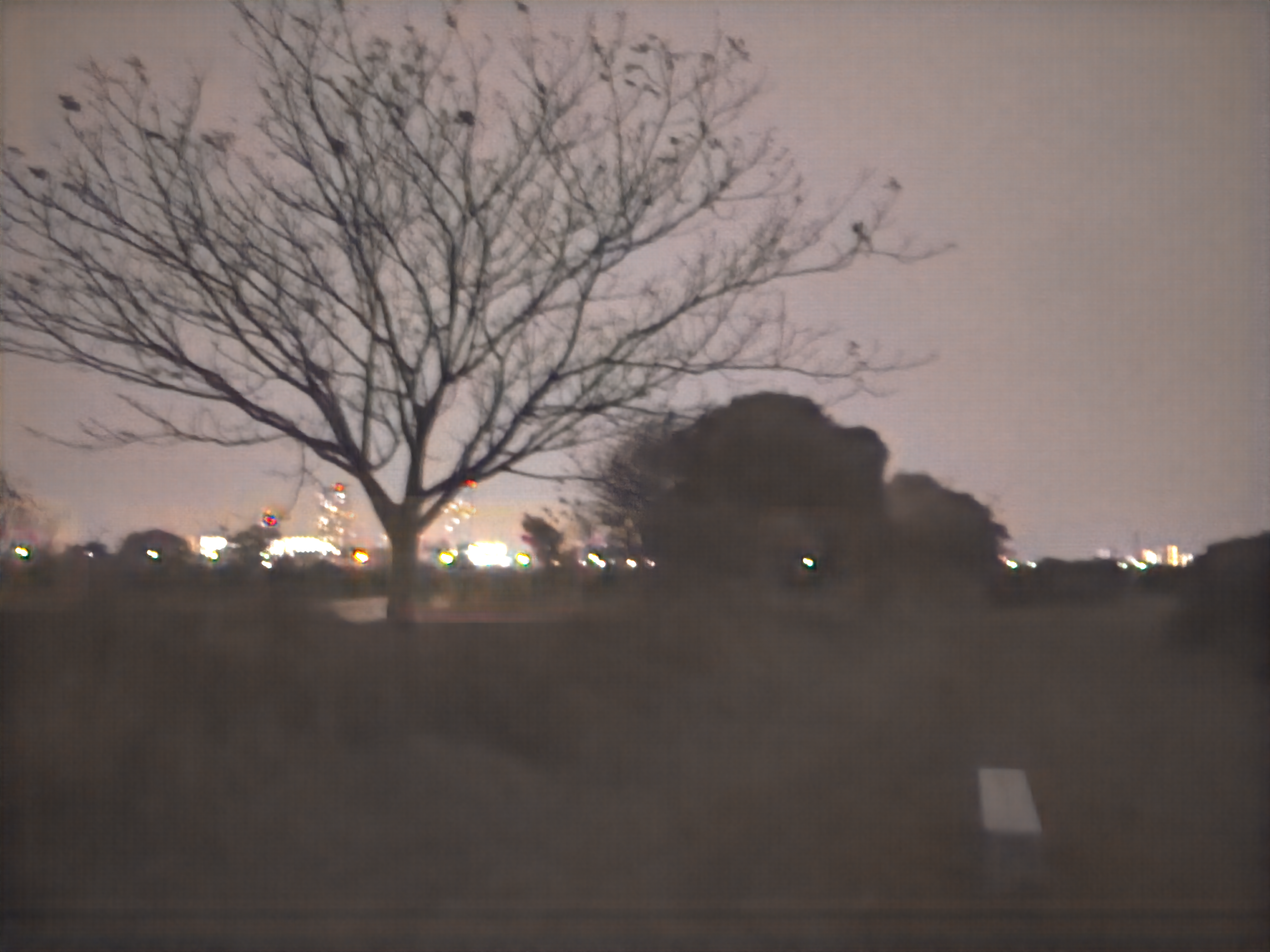

RAWでの撮影が必要なため、カメラアプリはProCam6を使いました。昔無料の時にダウンロードしたやつ。

元画像, Macのプレビューで無理やり明るくした画像, ニューラルネットに突っ込んだ画像の順番,で並べてます。

なるほど?

確かに効果があるみたいですね。かなりノイズが削減できています。

色乗りはよくないですが、ここら辺はちゃんとiPhone用のモデルを作れば解決できそう。

逆に元が明るい写真の場合は崩れてしまうことが多かったです。

元画像, ニューラルネットに突っ込んだ画像の並び。

ちなみに

GoogleのAIブログの記事を読んだのですが、「夜景モード」は複数枚の写真を自動で重ね合わせることで実現されているようです。

Thus, depending on which Pixel phone you have, camera selection, handshake, scene motion and scene brightness, Night Sight captures 15 frames of 1/15 second (or less) each, or 6 frames of 1 second each, or anything in between.

動体か風景かで写真を撮る間隔や枚数を変えるみたいです。へー。

これ読んでると「夜景モード」ってもしかしてDeepLearning関係ない気がしてきてしまったわけなんですが、となるとこのQiitaの記事を書いた意味は。。。