Machine Learning by Stanford University WEEK9 のまとめ

アノマリー検出 (異常検知)

概要

既知のデータセットに対し、あるデータが異常値かそうでないかを判断する手法。データセンタでの異常値検知等の分野で実用されている。

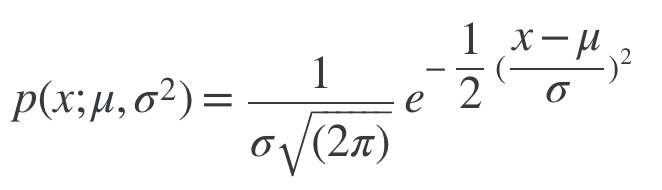

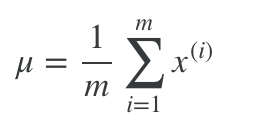

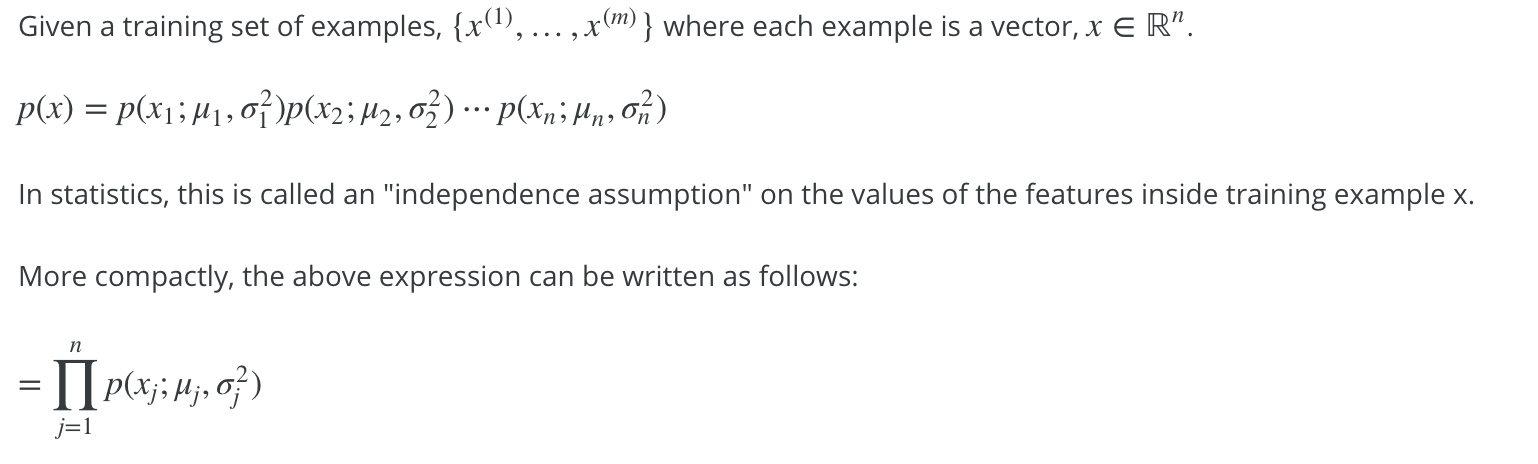

モデルをp(x)、x(i)をi個目の変数セットと定義し、

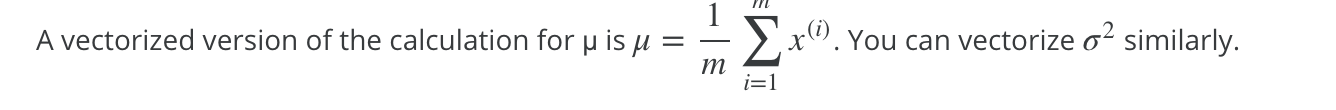

p(x)<ε

の場合異常値と判断する。もし、異常値の検出率が高すぎる場合はεの値を減らす。

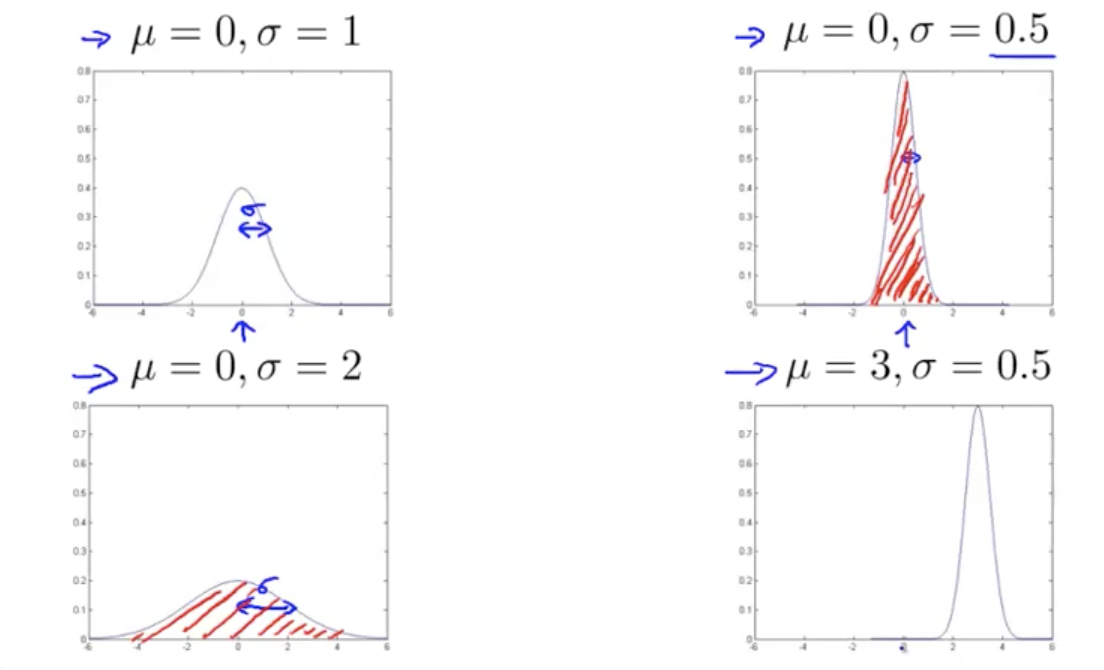

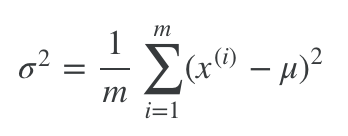

ガウス分布=正規分布の復習

ガウス分布の例は以下

μは平均値 σは分散 赤い部分の積分値は1となる。

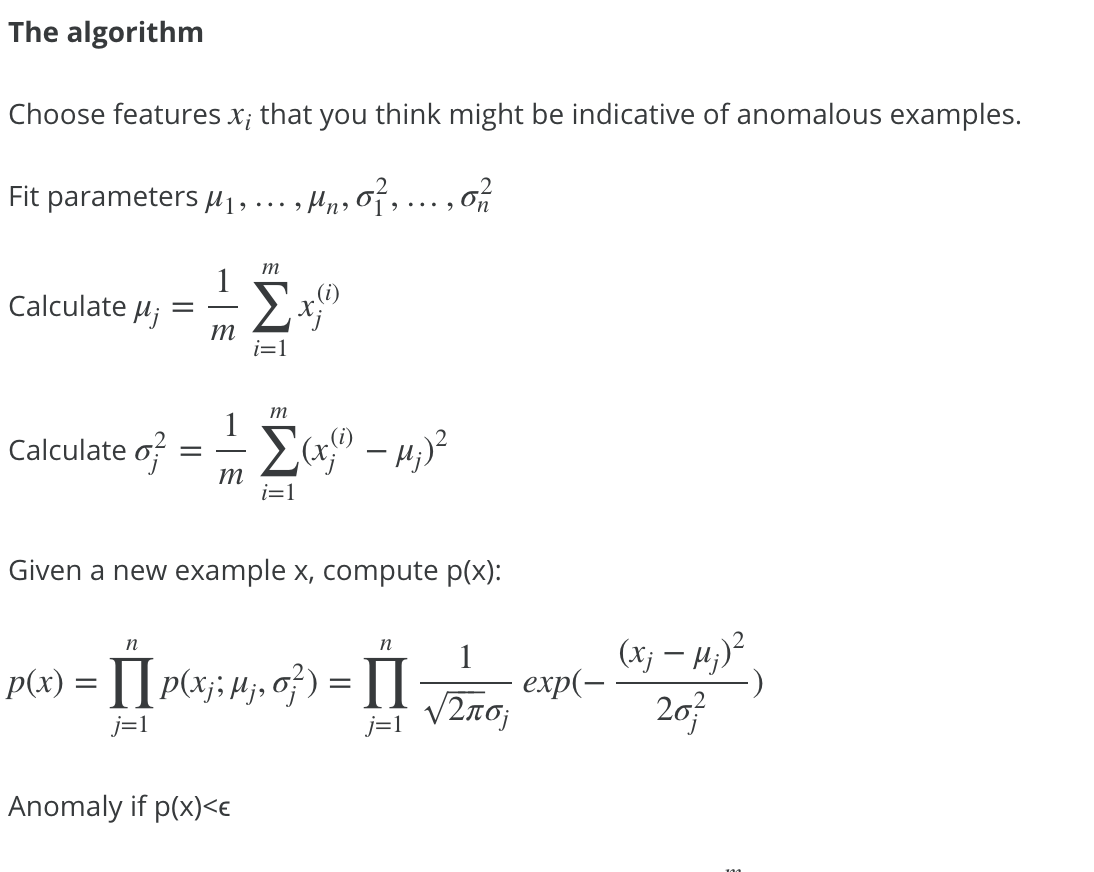

アノマリー検出のアルゴリズム

データセットがガウス分布(正規分布)していると仮定して、トレーニングのデータセットから平均値μ、分散σを算出し、確率pがε以下であればアノマリー(異常値)と判断する。データの次元数分pを掛け合わせる。

アノマリー検出の適用 アルゴリズムの評価

アルゴリズムの評価には異常値(y=1)と正常値(y=0)にラベル付けされたデータを用いる。(具体例:0.2%の確率で異常値となるデータセットには60%をトレーニングデータセット、20%をクロスバリデーションデータセット、20%をテストデータセットとして用いる)

アルゴリズムの評価の手順は以下の通り

- モデル p(x)にトレーニングセットx(i)を適用する。

- クロスバリデーションセット、テストセットに対して p(x)<εの場合はy=1(異常値)、p(x)>=εの場合はy=0(正常値)と予測させ、ラベル付けされたyとの差異を小さくする。

y=1のデータ数はy=0のデータに比べて非常に少なくなる(データが歪んでいる)ので、評価指標は 予測とリコール、や、F1スコア 等を用いる(WEEK6の偏りのあるクラス分類の問題を参照)

また、適当なεの値はクロスバリデーションセットを用いて決定する。

教師あり学習 vs アノマリー検出

アノマリー検出の学習には、異常値、正常値のラベル付けしたデータがあるのだから、ニューラルネットワーク等教師あり学習をなぜ使わないのか?という疑問を持つかもしれない。どのような場合にアノマリー検出を使うべきか?

以下の場合アノマリー検出を利用する

- 異常値データ(y=1)が正常値データ(y=0)より極端に少ない場合

- 異常値の種類が多い場合。例えば飛行機の故障の種類等。

以下の場合教師あり学習を利用する

- y=1,y=0両方のデータが十分にある場合

アノマリー検出で、どの変数を利用するか?

どの変数を利用するか?はアノマリー検出の精度を大きく左右する。

変数をプロットし、正規分布しているかどうかを事前にチェックする事が有効。

正規分布していない場合はlog(x)、√x等に変換する等して正規分布するように変数を置き換えるとアルゴリズムの精度が上がる。

また、アノマリー検出で異常値がうまく検出できない場合、検出に失敗したデータを分析し、新たな変数xを利用して再度試してみる事が有効。

アノマリー検出の拡張

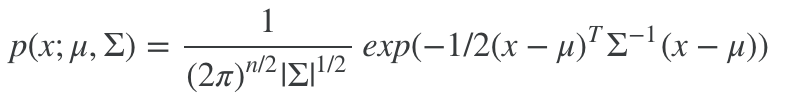

多変量ガウス分布

多変量ガウス分布は変数x(1),..x(i)を行列化して表現する。

これにより、変数間の相関を把握する事ができる。

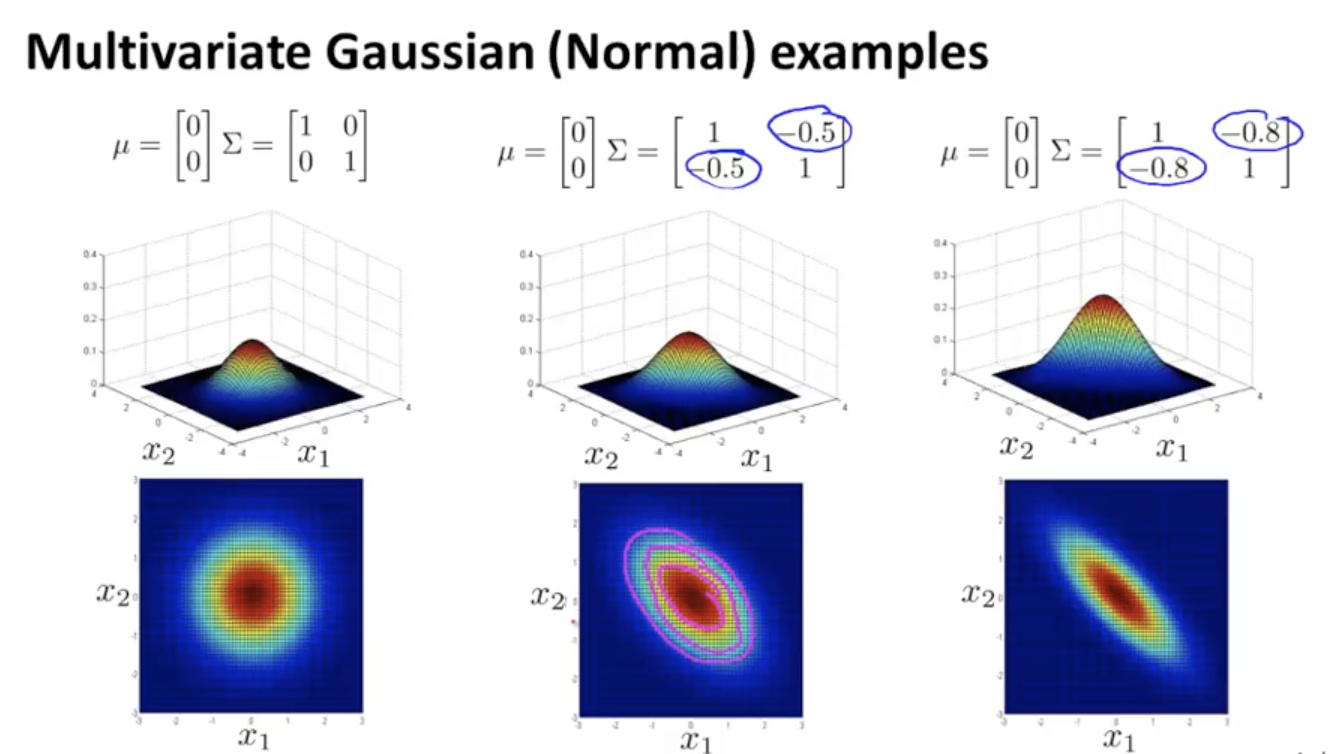

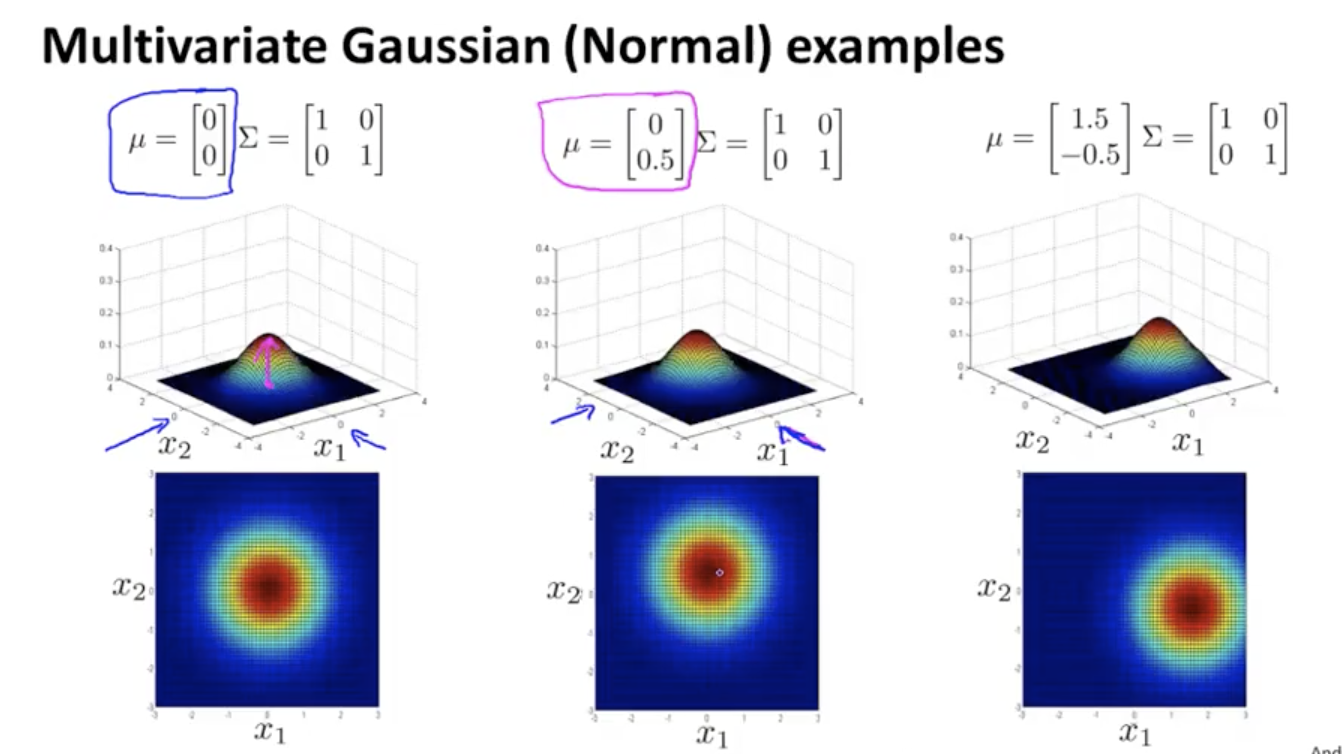

μ、σの値と多変量ガウス分布のグラフの具体例は以下

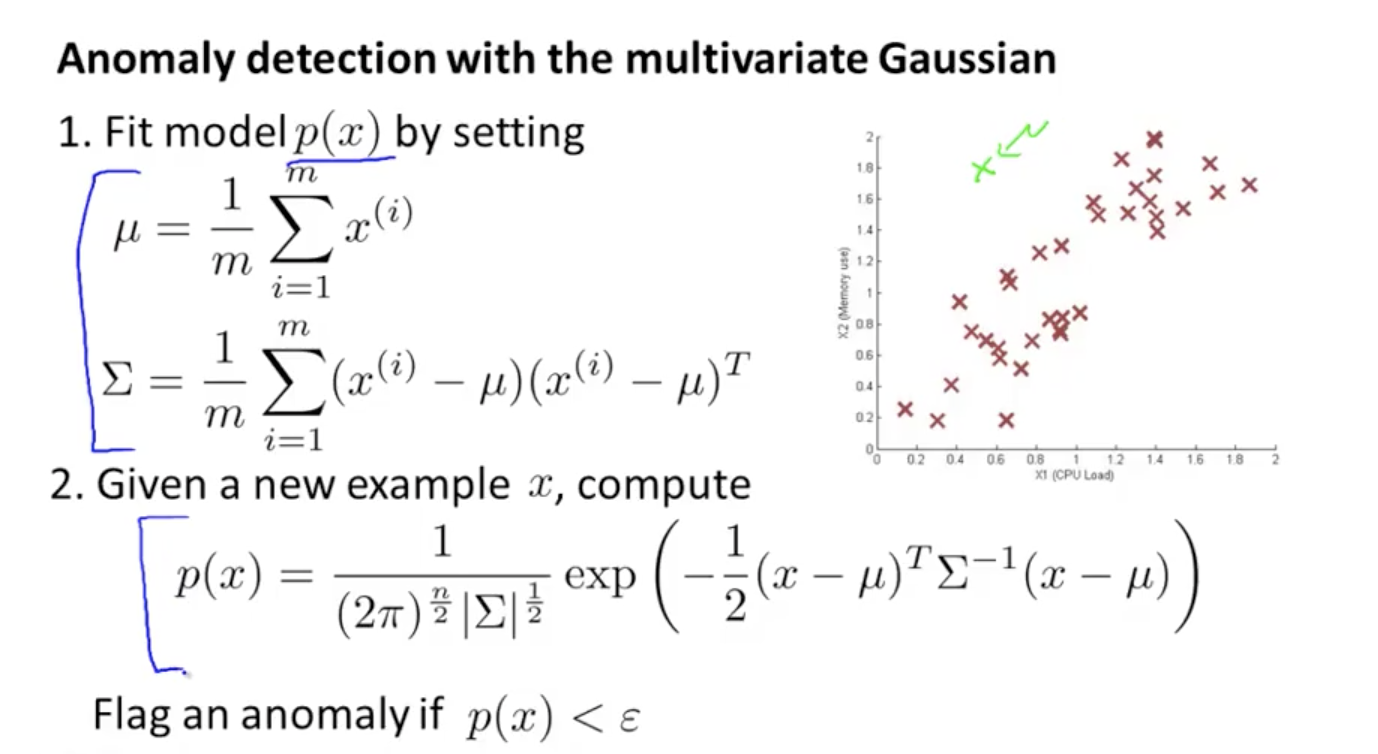

多変量ガウス分布のアノマリー検出への適用

適用手順

通常のガウス分布 vs 多変量ガウス分布

通常のガウス分布を用いた場合、変数間に相関がある場合に新たな変数を作り出す必要があるが、多変量ガウス分布はその必要がない点がメリット。

ただし、計算コストが高くなる点はデメリット。変数の数n×n行列の計算をするので、例えば変数n = 10,000の場合は通常のアノマリー検出を使う方が現実的。また多変量ガウス分布にはトレーニングデータの数mが変数の数nよりも大きい(m>n)という数学的な条件がある点にも注意。

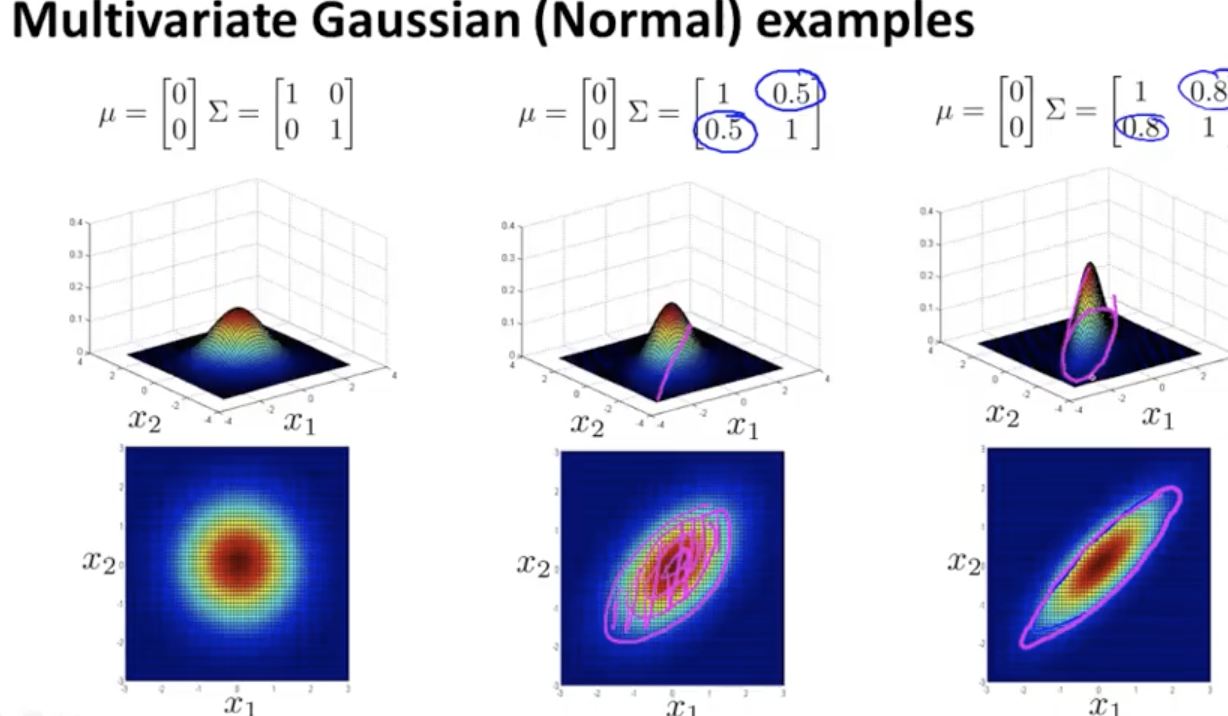

リコメンダーシステム

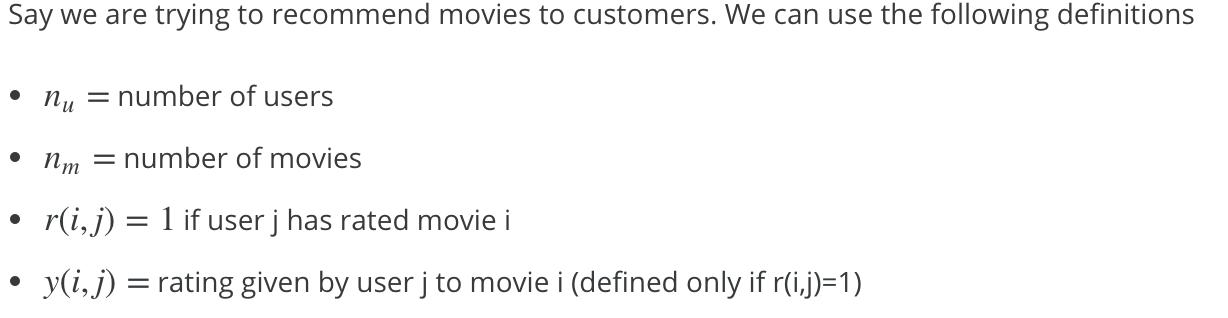

リコメンダーシステムのモデル化

リコメんだーシステムは機械学習の重要な応用事例。

AmazonやNetflix等多くの企業で実際に適用されている。

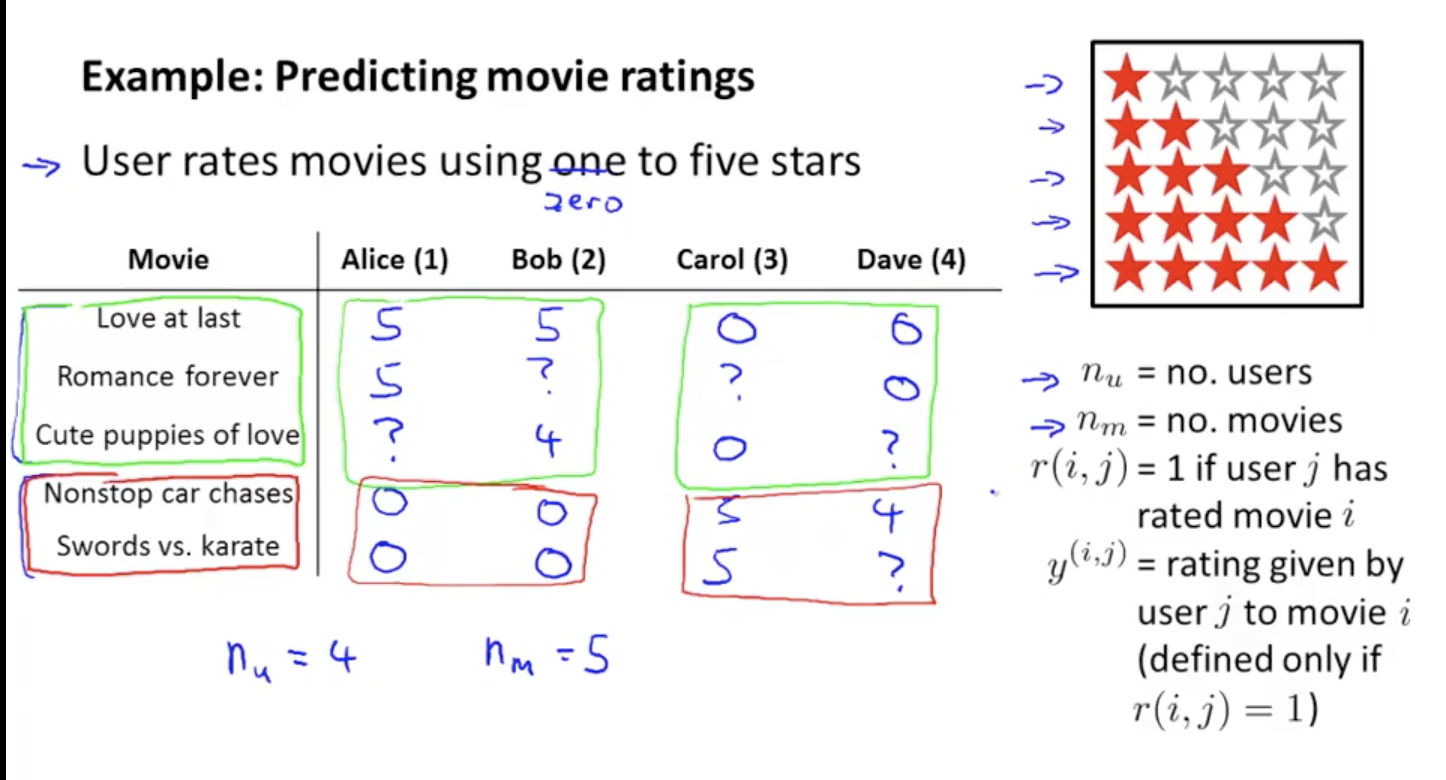

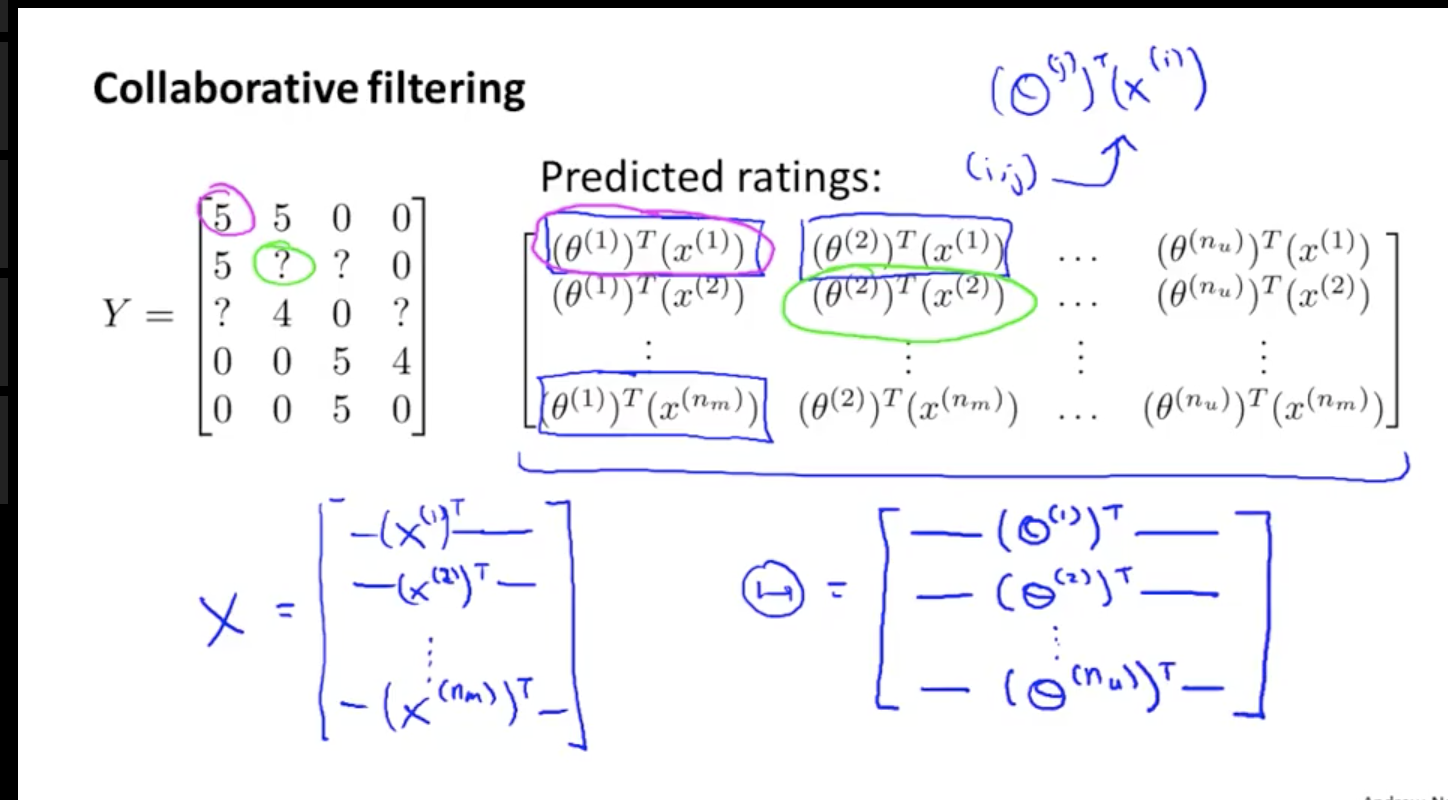

nu =4 nm=5 r(2,1)=1 y(2,1)=5

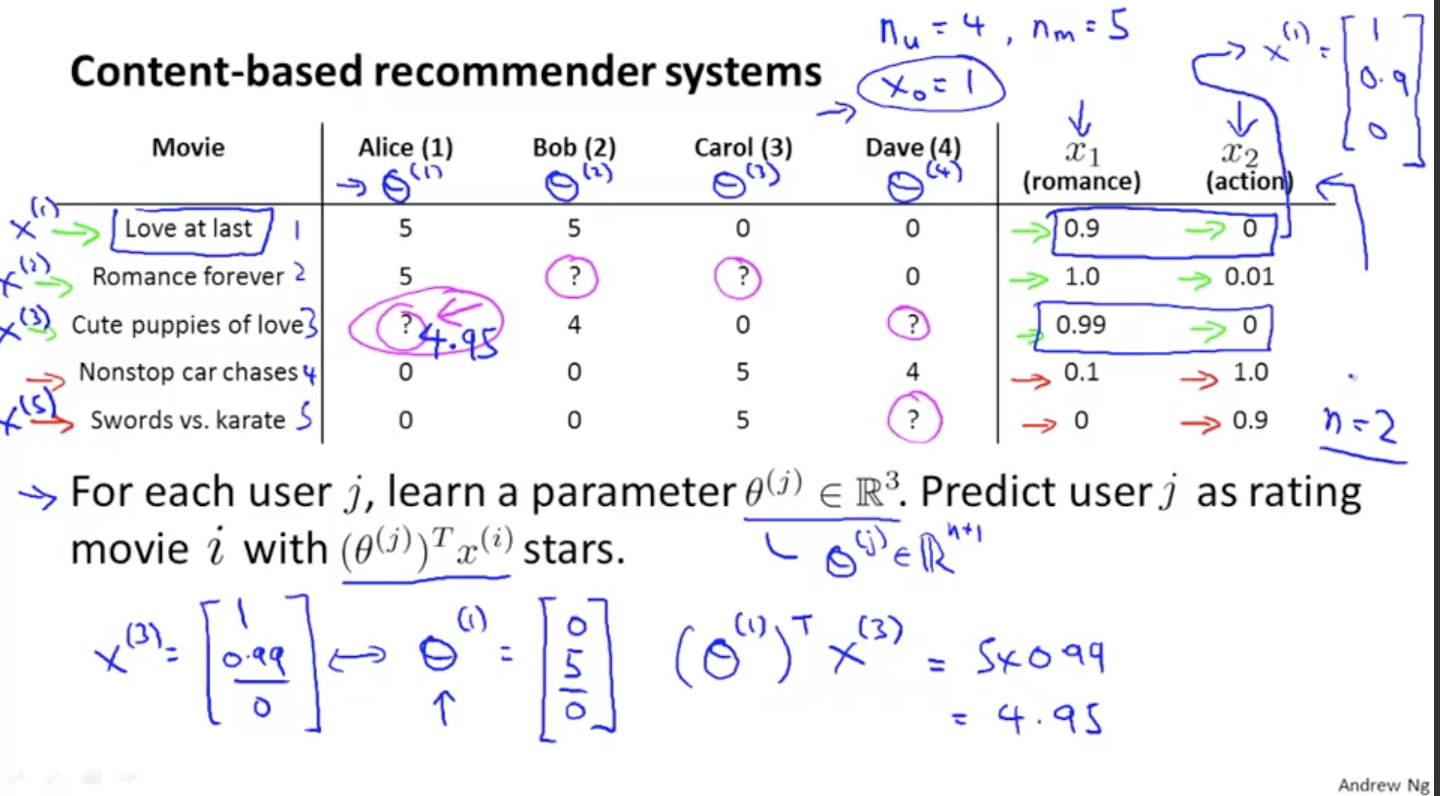

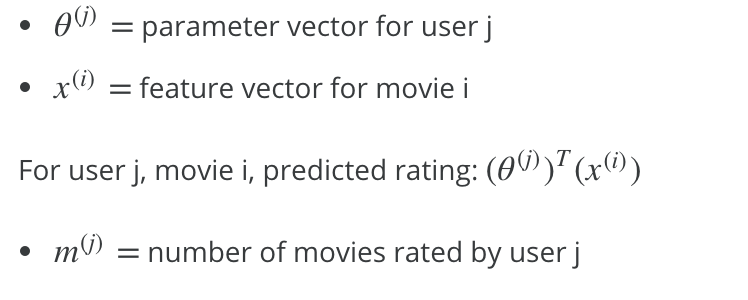

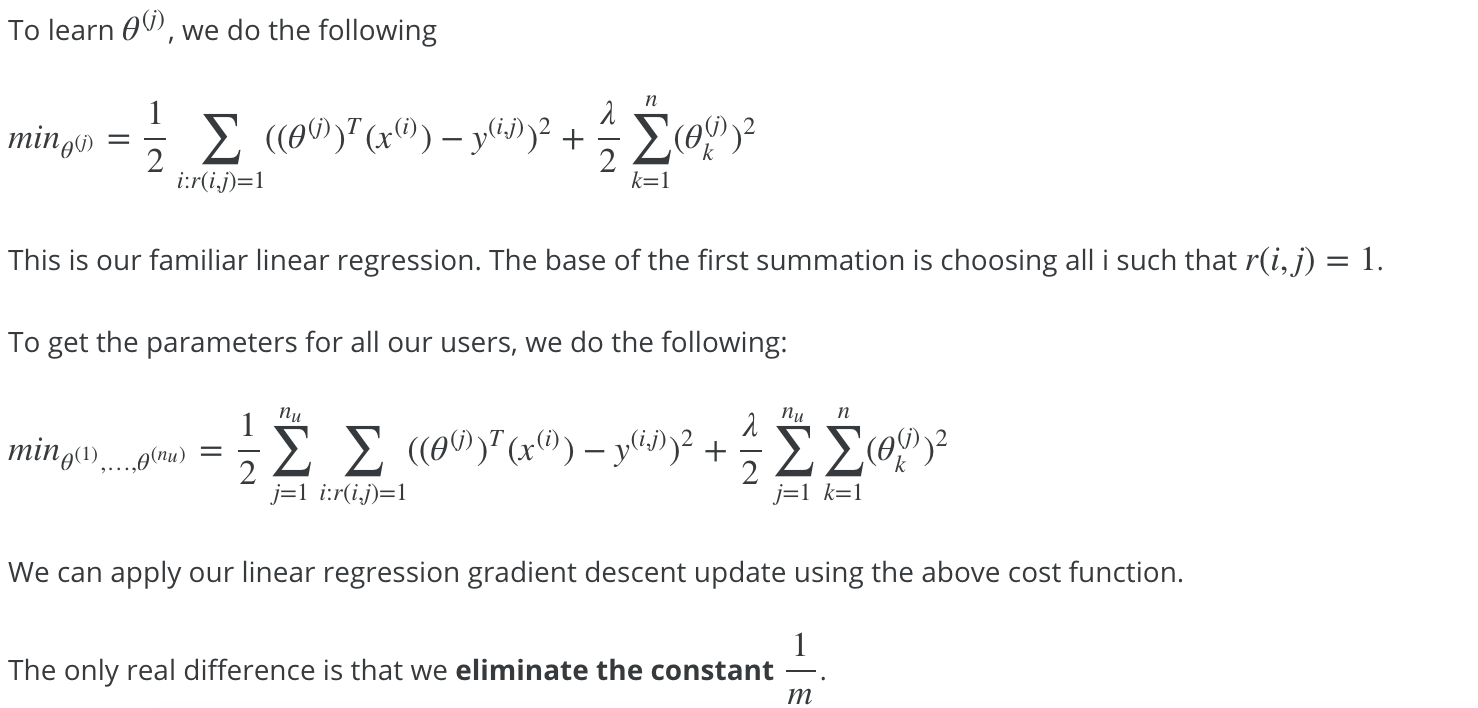

コンテントベースのリコメンダーシステム

それぞれの映画について、映画の内容を表す変数x1(ロマンス度),x2(アクション度)を定義できるとする。

1つのアプローチとしては、線形回帰の問題として扱うという事。

バイアス項 x0=1 を加えて、パラメータθ(j)は3次元ベクトルになり、(θ(j))tx(i)でスターの数を予測できる。

強調フィルタリング によるリコメンダーシステム

概要

前項のように映画の内容を表す変数を予め定義できない事は多々ある。

(この映画のロマンティック度は0.5でアクション度は0.8 といった定義をここの映画に対して予めする事は困難)

その際、前項とは逆にθjが分かっている場合、逆に変数x1,x2の値を推計する事ができる。

現実の問題ではまずθにある値を推計してxを算出、xを利用してθを再度推計・・と繰り返してθ、x の値の精度を上げていく。

アルゴリズム

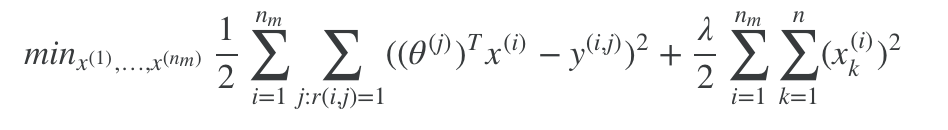

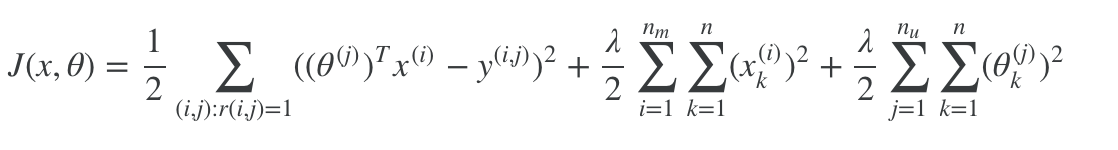

θ、xの値を交互に変更していくよりも効率的なアルゴリズムとしては以下。θ、 x両方を含んだ以下の目的関数を最小化する。

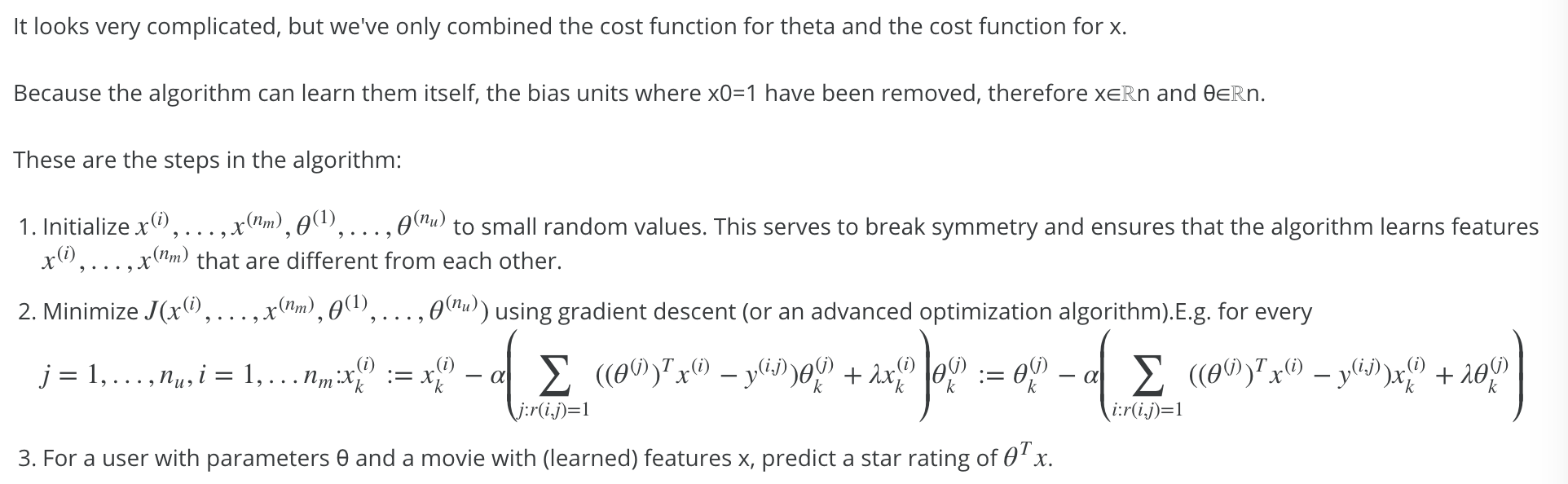

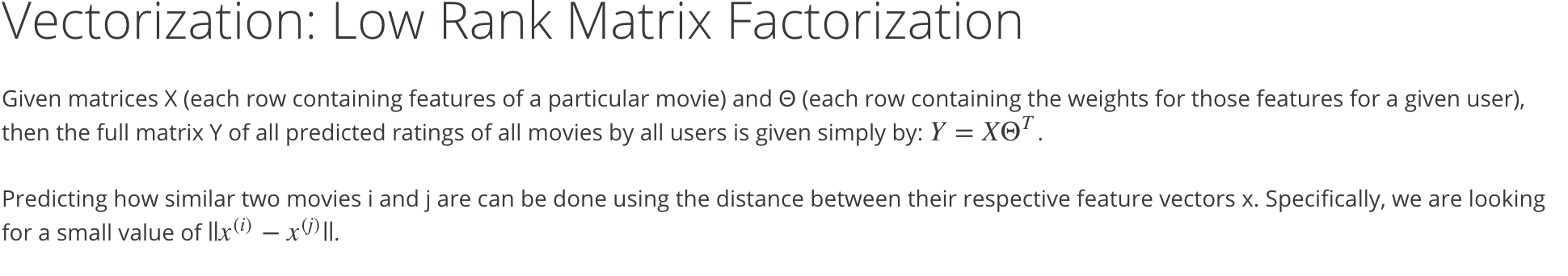

ベクトル化した実装 (低ランク行列分解) 概要

ベクトル化した実装 (低ランク行列分解) 実装方法の詳細 (平均標準化)

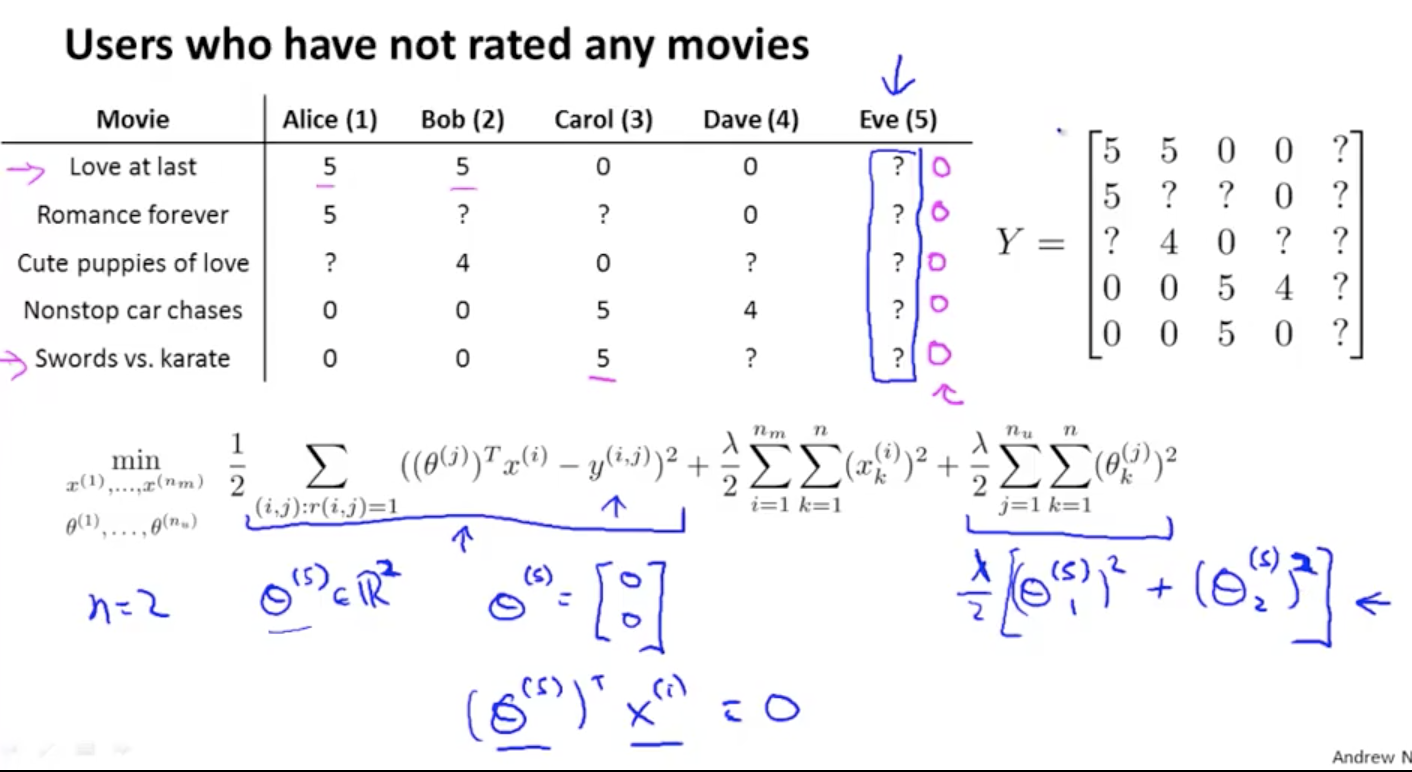

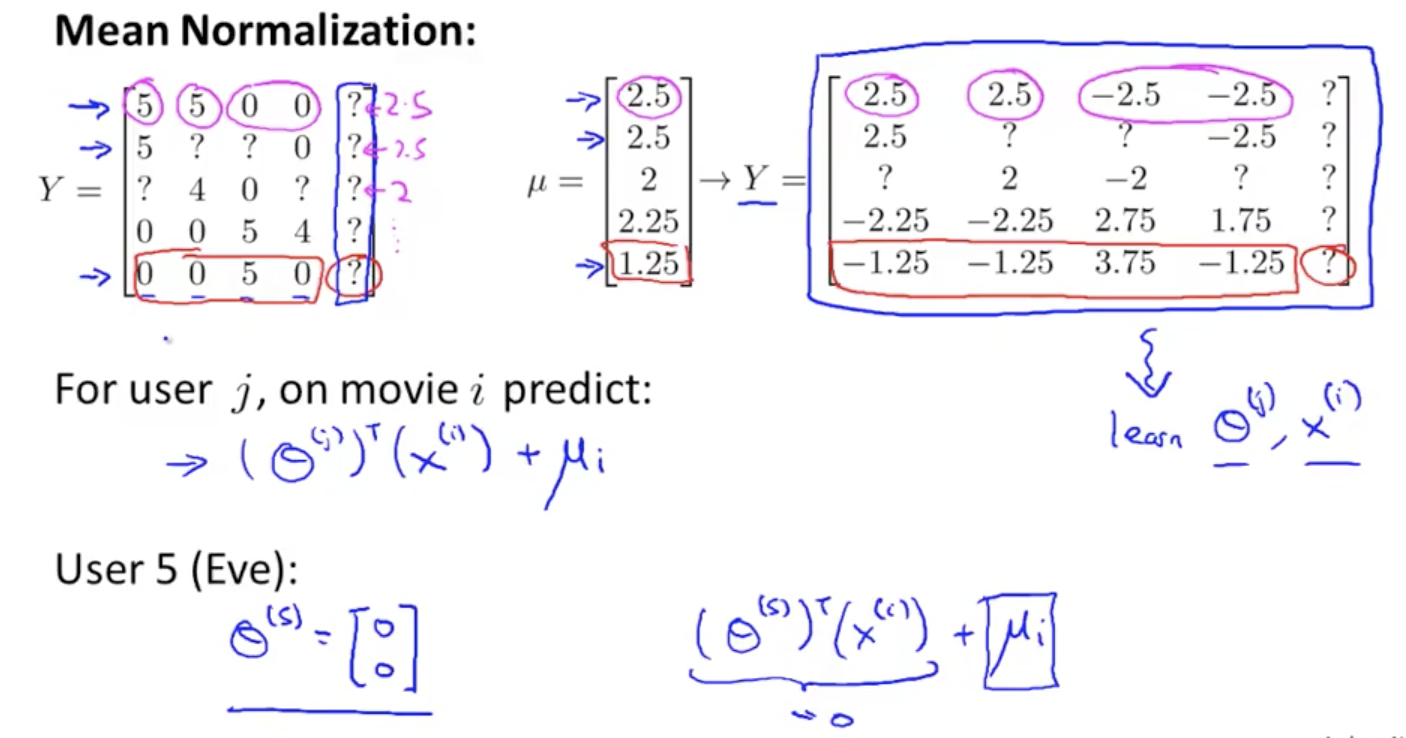

全項までのリコメンダーシステムで、新たなユーザの評価を予測する際、θの初期値を0にセットするとY(各映画の評価)の値は0となり、どの映画もおすすめできなくなってしまう。

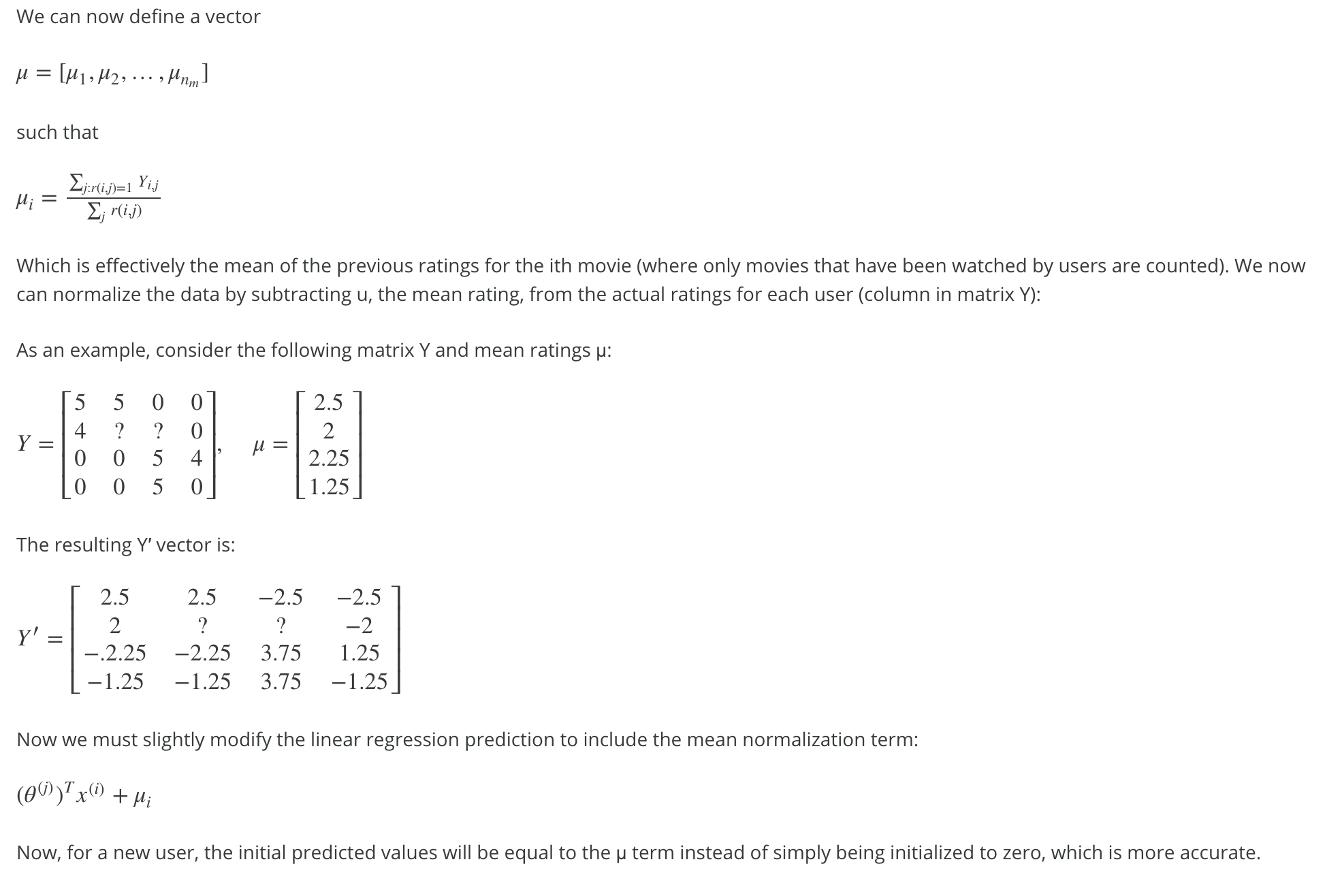

Yの値として、既にある書くユーザの評価値の平均値を設定する方法が「平均標準化」