この記事はCloudAnalytics advent calendarの1日目です。

Cloud上でのAnalyticsをテーマに分析・機械学習・AIなどを扱います。

今回はカレンダーを始めるにあたってまずは分析環境を用意しておきます。

以下は30日無料で利用可能ですのでカレンダーに合わせて触ってみてください。

また、現在DataScientistチームの立ち上げを行っている方など試してみてはいかがでしょうか?

今日は利用する環境の概要説明と初めてのNotebookの作成を行います。

Data Science Experience

DataScienceExperienceはIBMの提供するCloud上のデータサイエンスプラットフォームです。

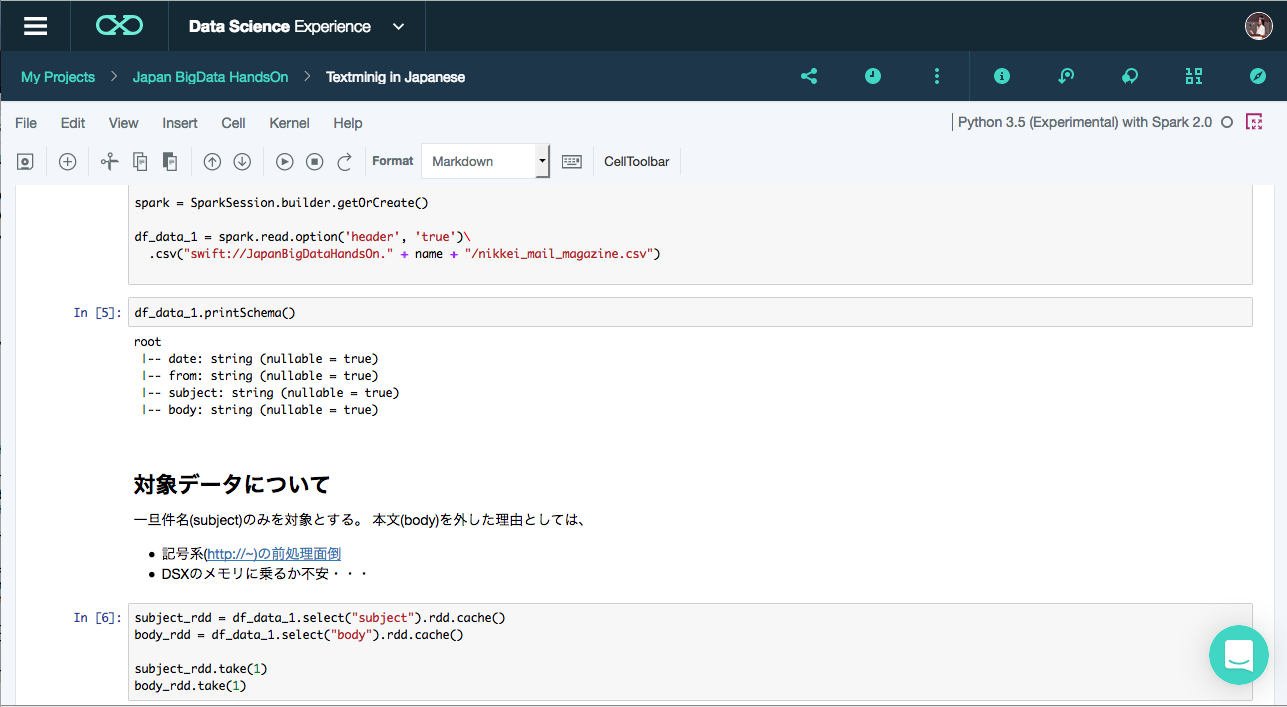

JupyterNotebookを筆頭にDataScienceを行うために必要なツール群が

一式用意されているのと、企業でのDataScienceを促進するための

チーム開発機能がセットになったプラットフォームです。

実行環境

DataScienceExperienceでは

- Python 2.x/3.x

- Scala 2.1x

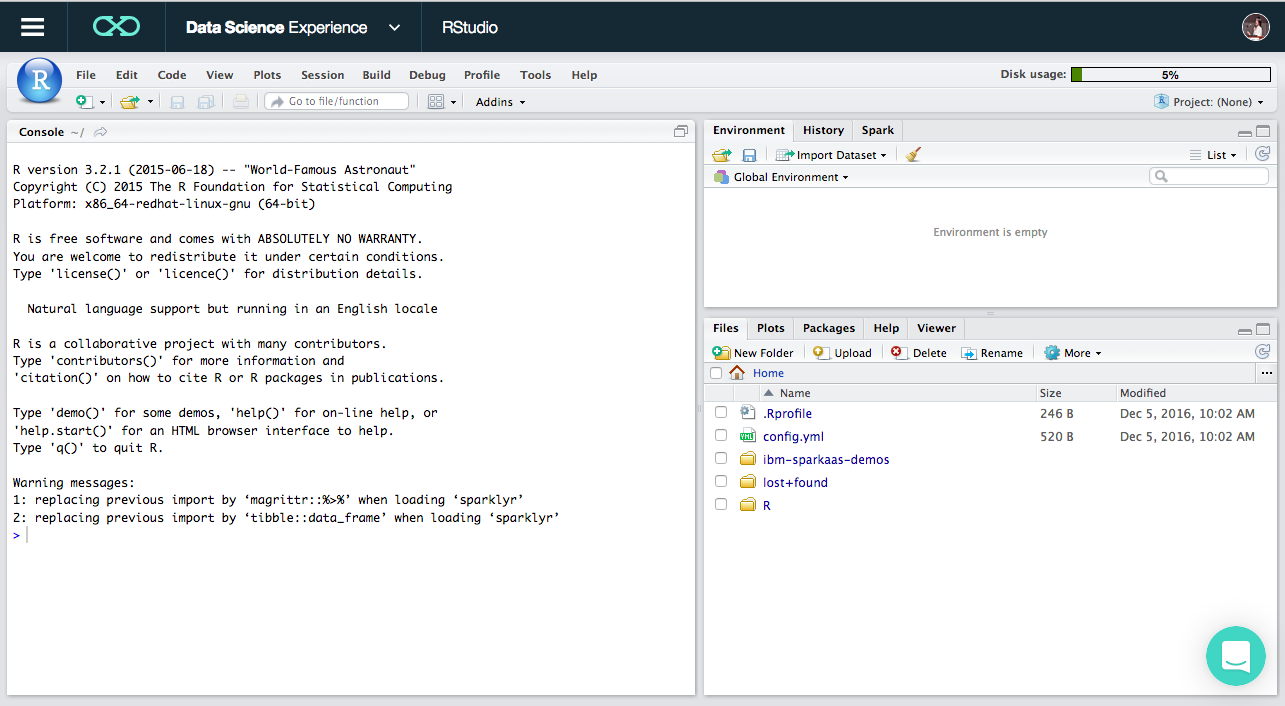

- R

の3つの言語を利用することが可能です。

また、Python,Scala,Rのいずれでもコードの実行はSpark上で分散実行されます。(scが生成された状態でNotebookを利用可能)

裏ではBluemix上のSparkに接続されています。

ディフォルトは2Executorのみしか利用できないようですが、Executorの拡張は可能です。

インタフェース

現在JupyterNotebookとRStudioが用意されています。

普段利用しているNotebookやRStudioとインタフェースは一緒ですね。

DataSrouce

DataScienceを始めるにあたって、どのようにデータを取得してくるかは重要です。

DataScienceExperienceではObjectStorageが5GB無料でついてきます。

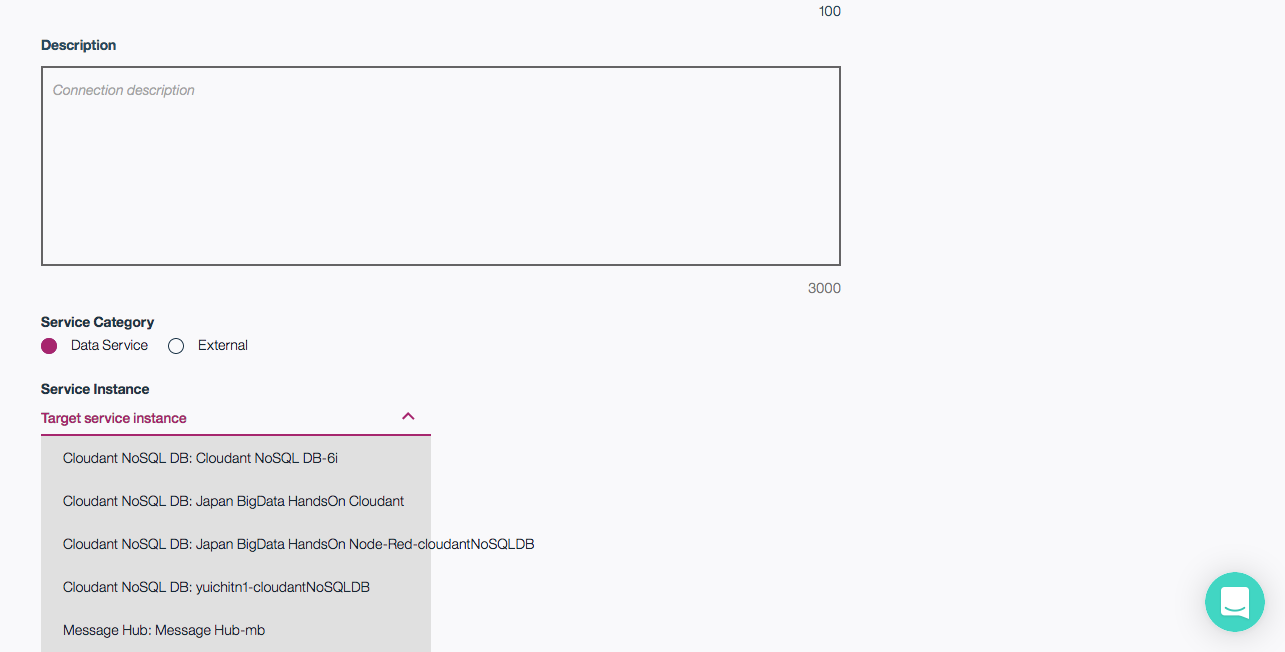

また、Bluemixの各StorageとGUIで接続可能で、特にCloudant(CouchDB)や

DashDBとはかなり接続性がよいです。

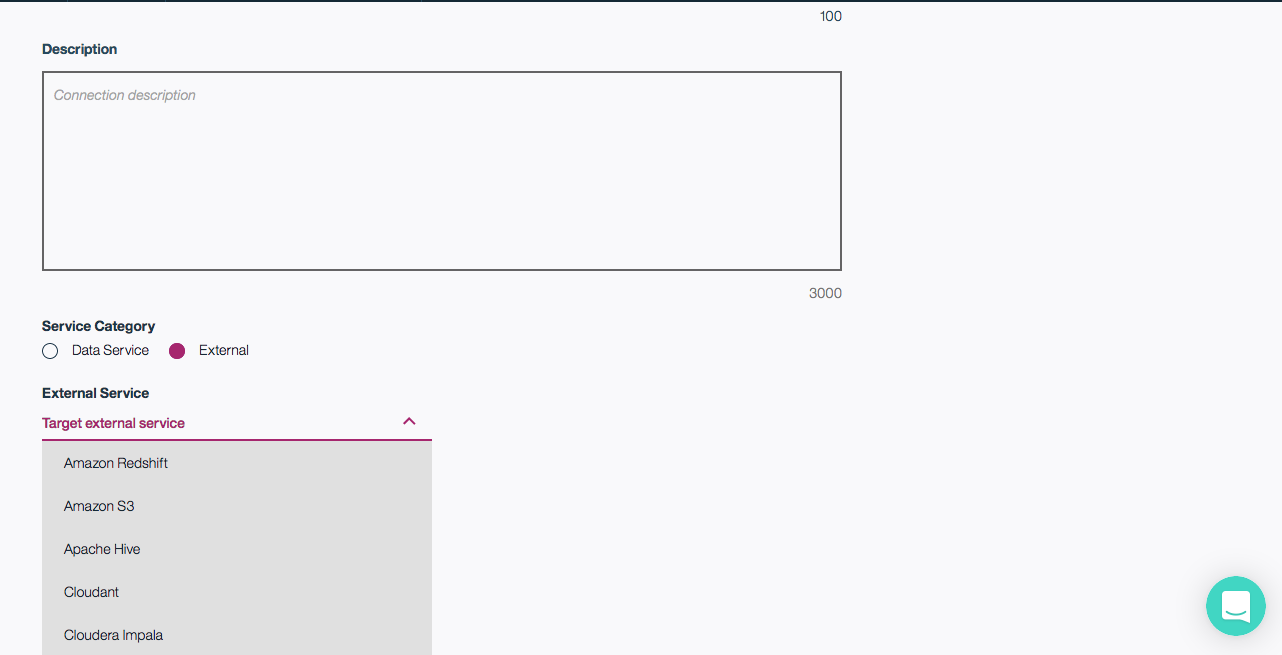

以下は接続の作成画面です。

他にもS3やImparaなど接続情報は必要ですがDataSouceとして利用可能です。

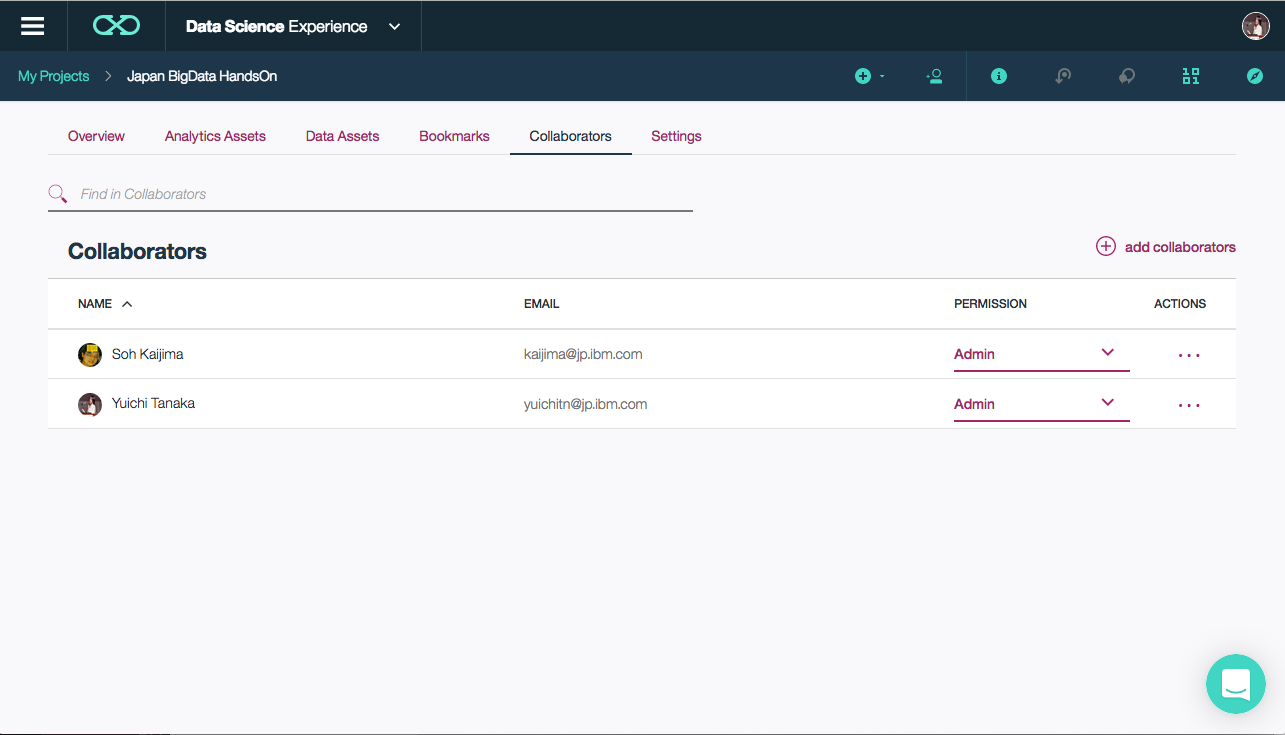

チーム開発

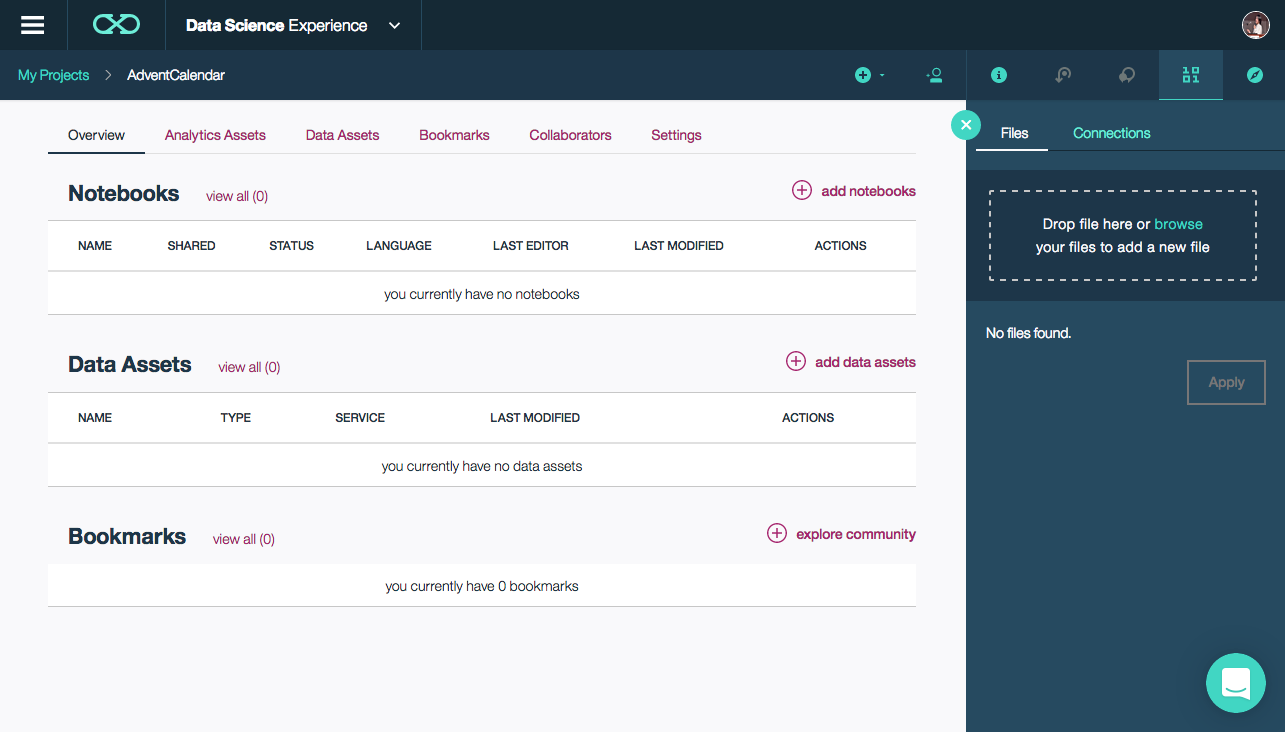

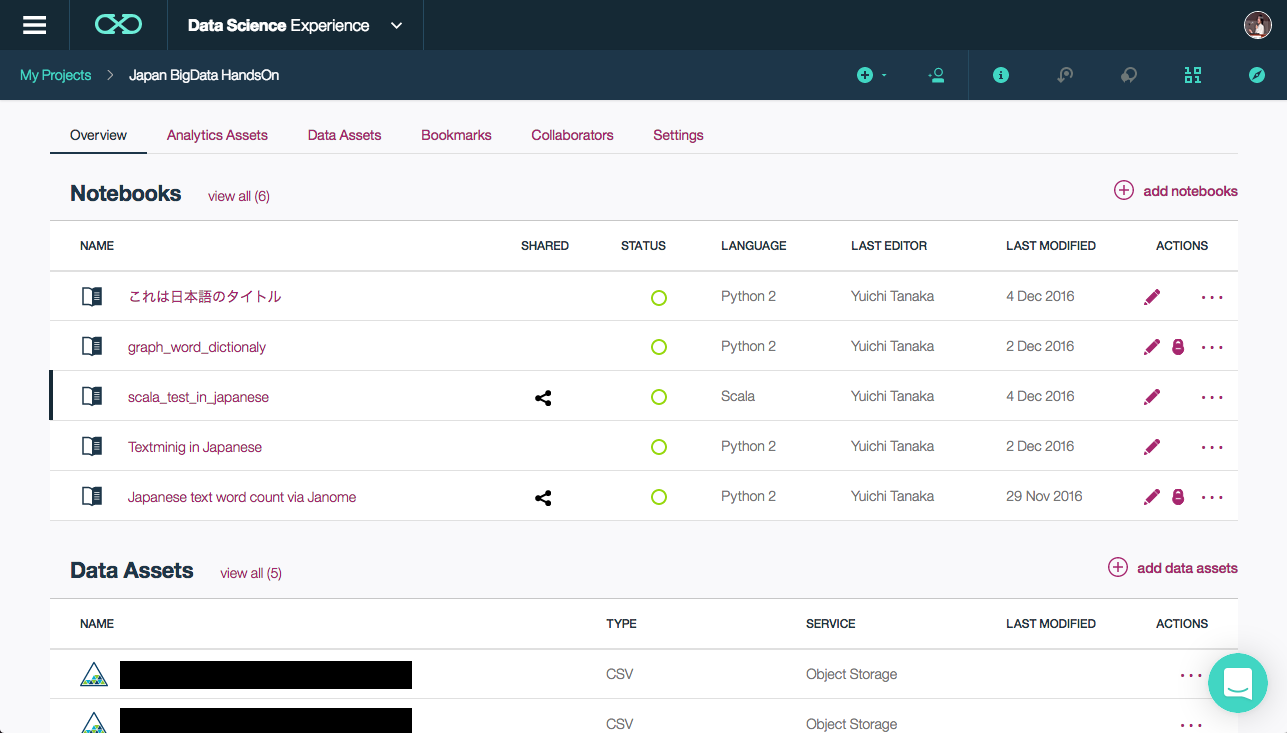

DataScienceExperience上ではプロジェクトを作成し、Notebookを作成していきます。

プロジェクトに対して他のユーザーを追加することで簡単にNotebookの共有を

行ったり、DataSourceの共有が可能です。

Admin,Viewer,Editorなどの設定が可能です。

NotebookやDataSouceも共有可能で、共同編集なども行えます。

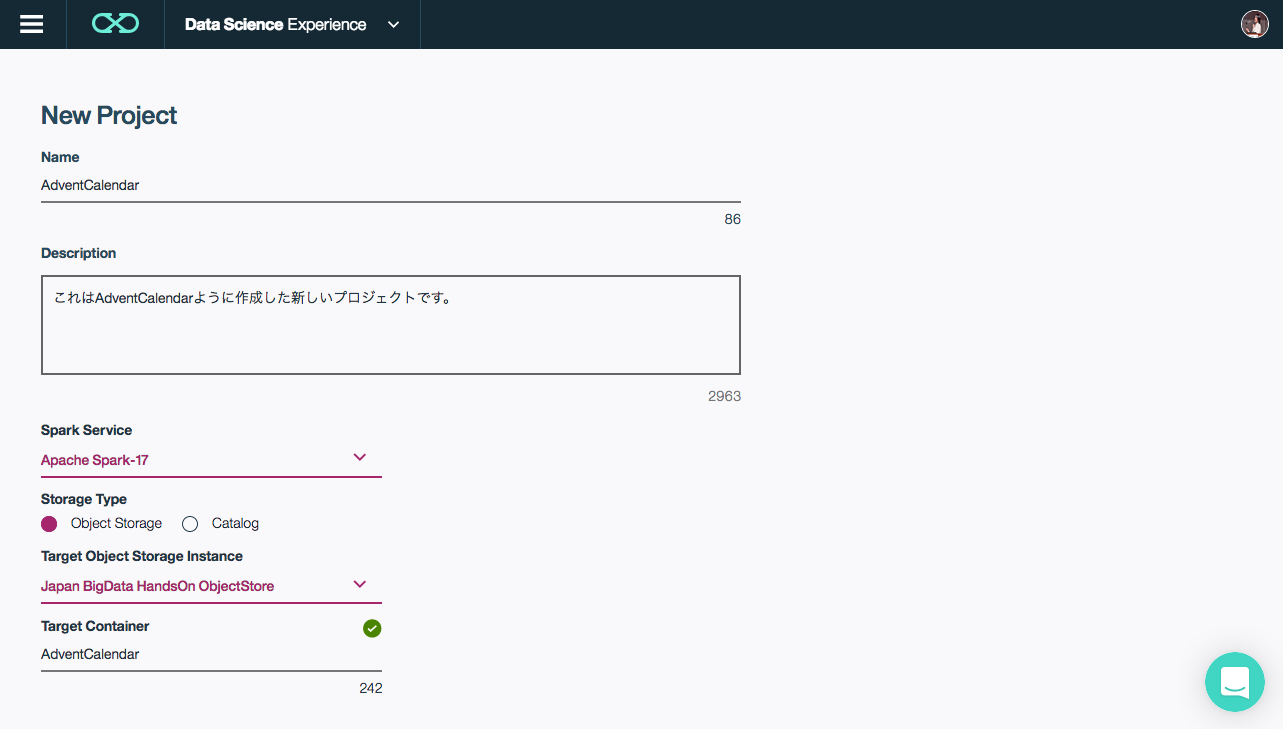

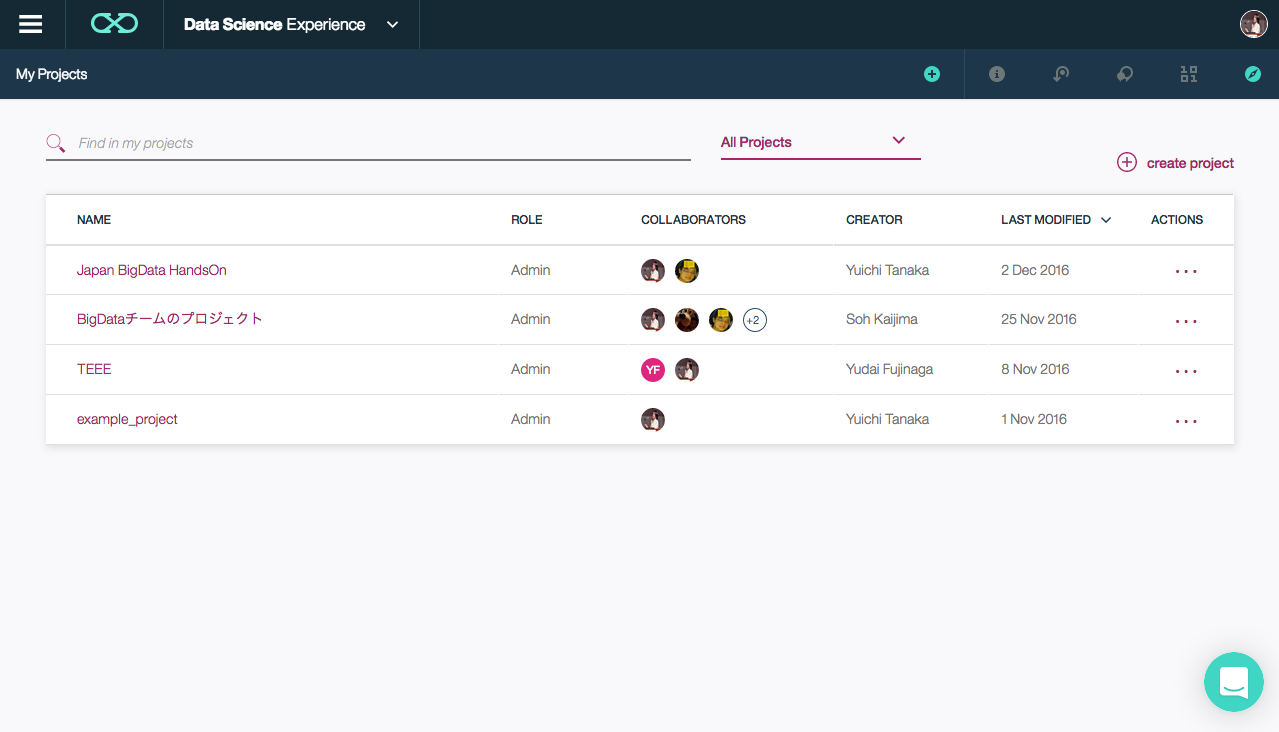

Projectの作成

まずはProjectの作成を行います。

以下の画像ではすでにいくつかのプロジェクトが作成されていますが、

ここでは新しいプロジェクトの作成をおこないます。

右上のcreate projectボタンからプロジェクトの作成画面に飛びます。

Spark ServiceとObject Storageの欄について

ここではProjectが接続可能なSparkServiceとObjectStorageを選択しますが、初回のみSparkServiceの作成が必要です。ObjectStorageはSparkService作成時に付属している物またはBluemix上のObjectStorageなdが選択可能です。

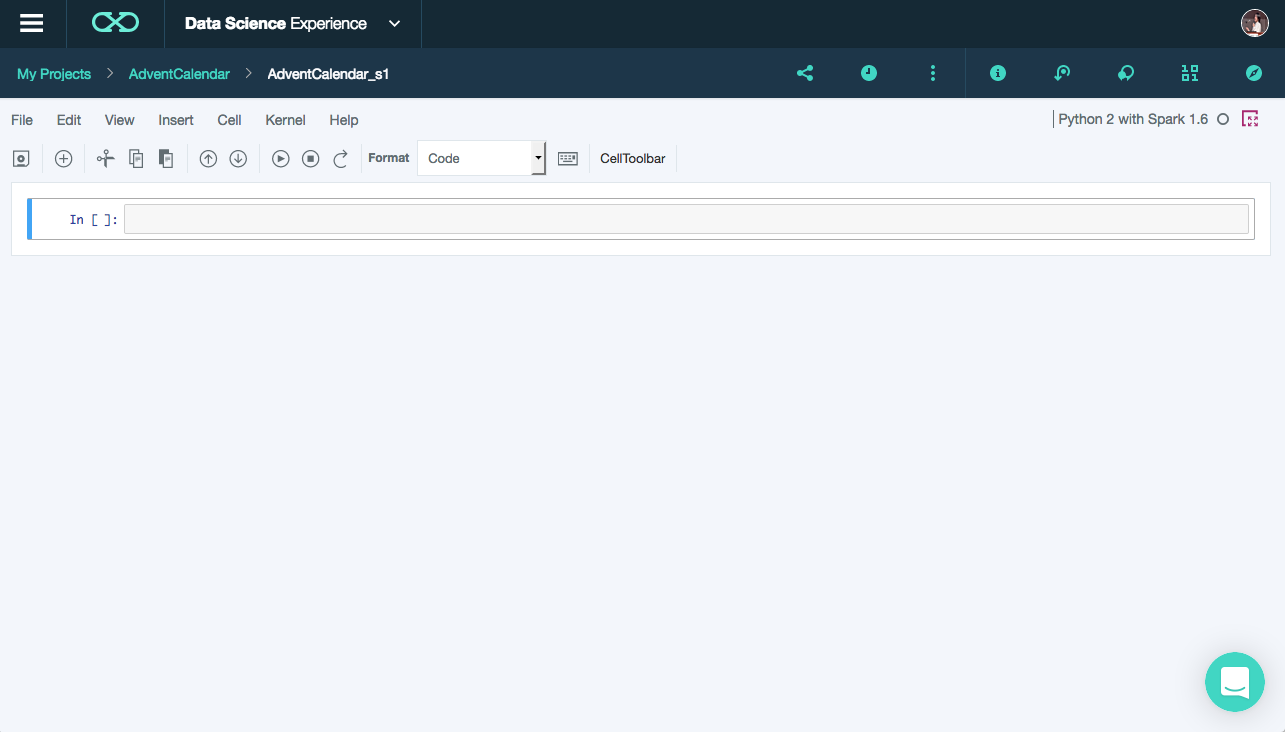

Notebookの作成と簡単なコードの実行

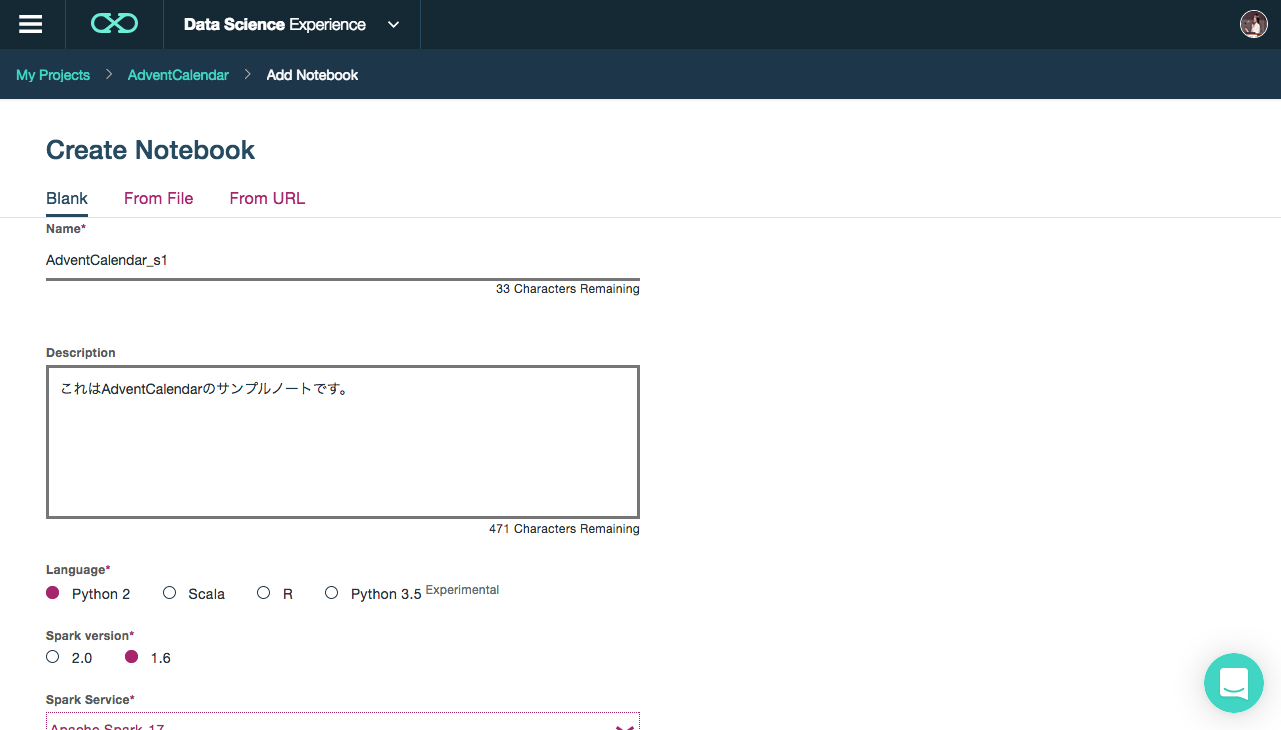

次にNotebookの作成とコードの実行を行っていきます。

先ほど作成したプロジェクト画面のadd notebooksボタンから

Notebookの作成画面に移ります。

Sparkのversionは2.0と1.6から選択可能です。

ここではPython2とSpark1.6を選択しています。

Notebookの名前(Name)について

現在Nameの項目を日本語で入力した場合にPreviewがうまくできないバグがあるようです。issueは上げておいたのでその内修正されると思いますが、ここでは英字入力にしておきましょう。

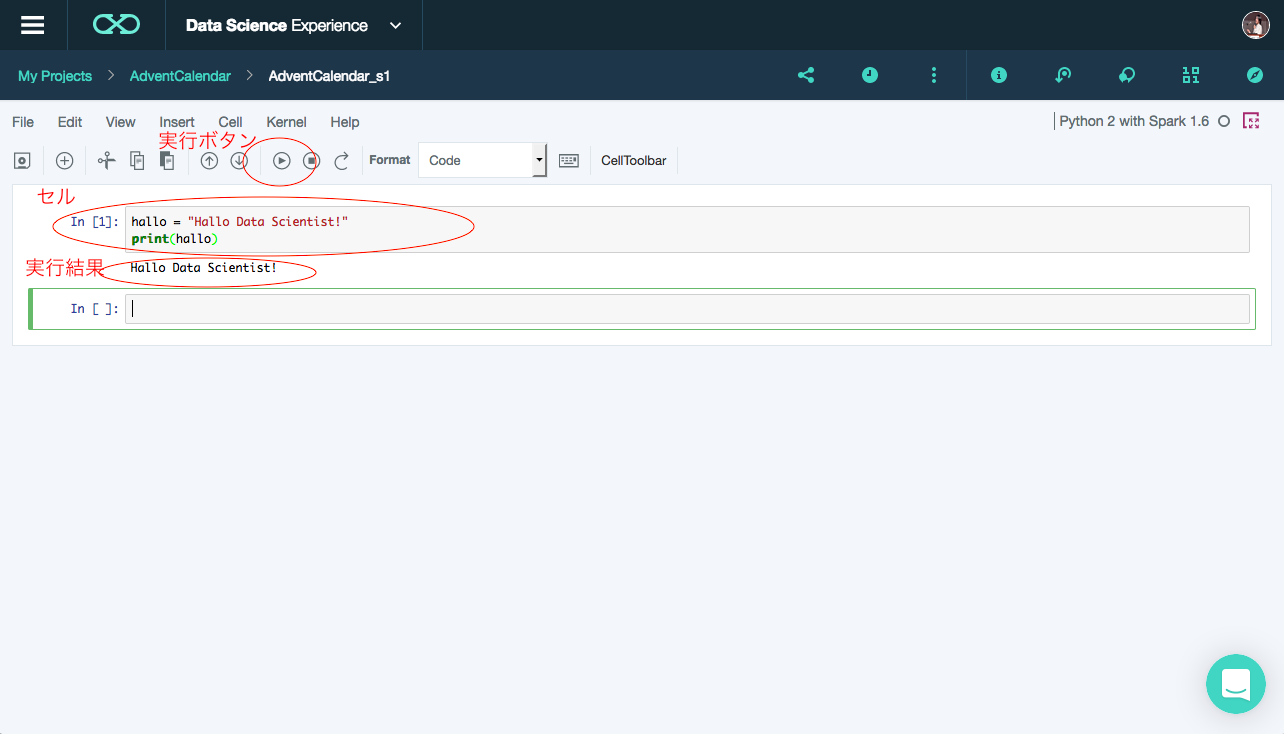

試しにPythonコードを実行してみましょう!

hallo = "Hallo Data Scientist!"

print(hallo)

作成したNotebookのセルに上記コードを貼り付け実行ボタンを押すと

コードが実行され、結果が出力されます。

セルの実行はShift+Enterでも実行かのうです。

これでData Scienceの準備ができました!!!

以後NotebookやObjectStorage、その他のDataSourceを利用して分析処理などを見ていきます。