概要

今回は[Cortana Intelligence Suiteを構築(第4回)](URL http://qiita.com/taiki_yoshida/items/2b965232045ca2abdc89)で出力した東京メトロの各路線の運航情報データと、[気象庁の気象データ](URL http://www.data.jma.go.jp/gmd/risk/obsdl/index.php)を組み合わせて、天気、曜日をもとに予測される各路線の遅延時間を算出する機械学習モデルを、Azure Machine Learningで構築してみます。

事前に準備するもの

- Azure サブスクリプション

- [Cortana Intelligence Suiteを構築(第4回)](URL http://qiita.com/taiki_yoshida/items/2b965232045ca2abdc89)で出力したデータ

設定手順

気象庁データの準備

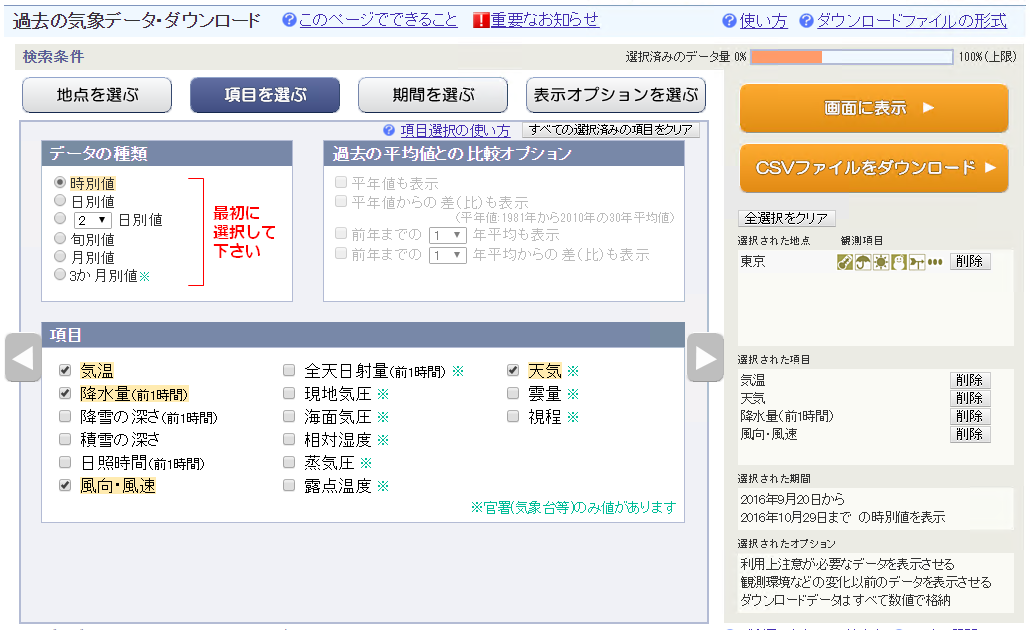

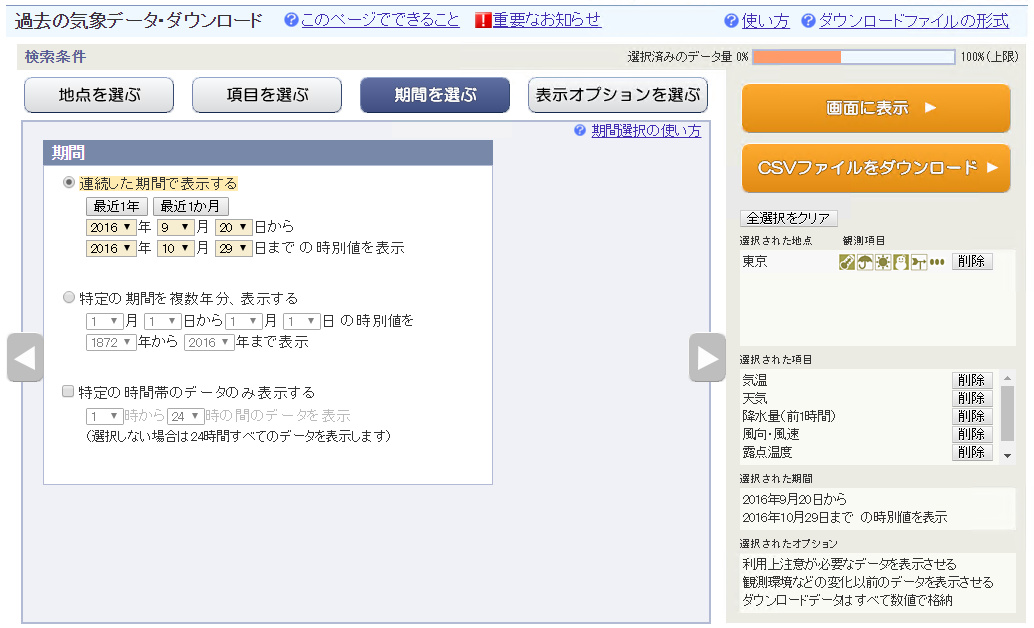

気象庁では、過去気象庁が観測したすべての気象情報がCSV形式でダウンロードできるサイトを提供しています。今回はこのサイトからダウンロードしたCSVファイルを東京メトロの運航データと組み合わせてみます。

-

http://www.data.jma.go.jp/gmd/risk/obsdl/index.php へアクセスし、地点を選択します。今回は東京を選択します。

-

詳細の地域が選べるので、「東京」にチェックを入れます。全地点も選択可能ですが、一度にダウンロードできるデータ量は制限があるため、なるべく小さい範囲と項目を選びましょう。

-

出力する期間を選択します。ここは、[Cortana Intelligence Suiteを構築(第4回)](URL http://qiita.com/taiki_yoshida/items/2b965232045ca2abdc89)で出力した期間を選択しましょう。

-

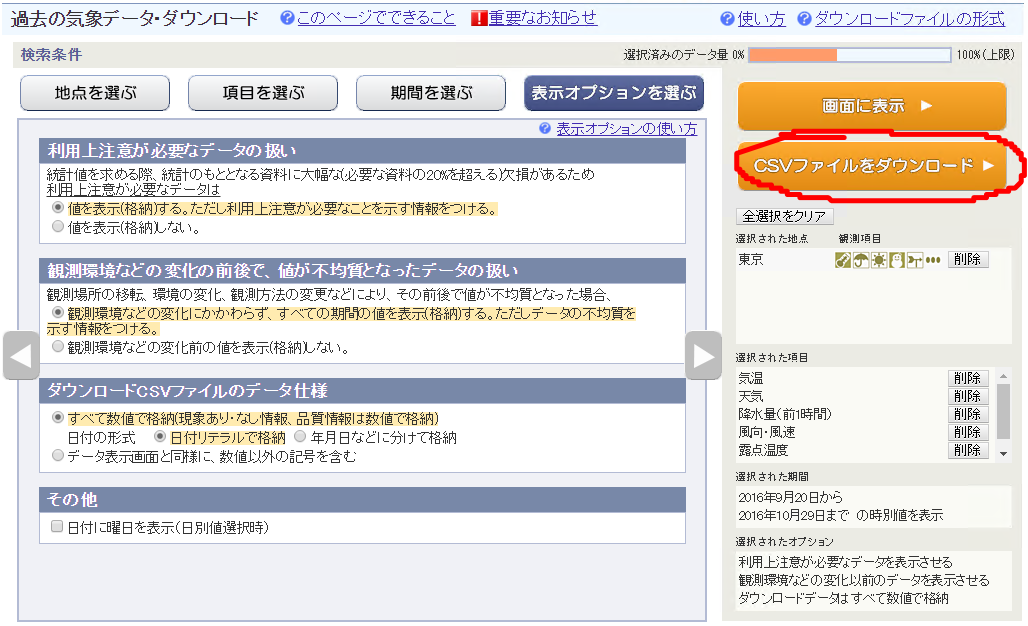

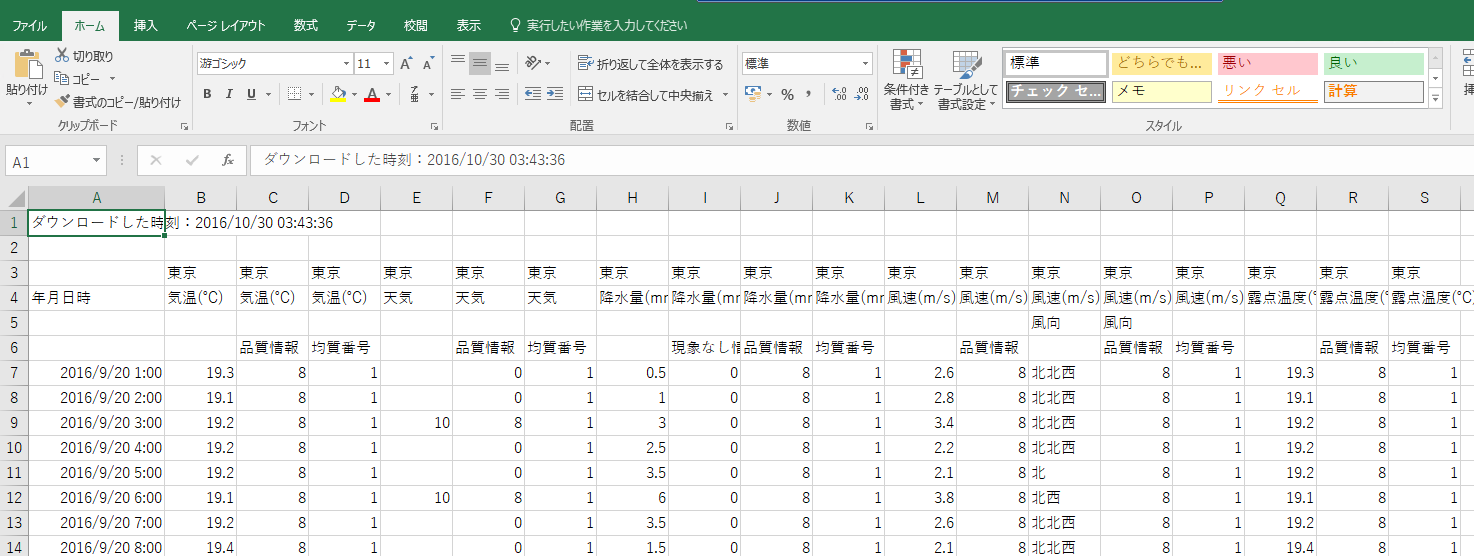

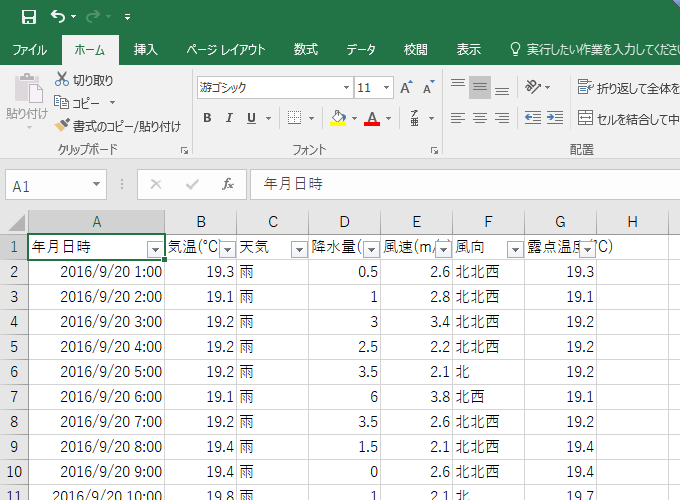

このままではデータが利用できないので、Excelで加工します。品質情報、均質番号の列は削除します。

天気の列は、数字で表されているので、[こちらに記載されている](URL http://www.data.jma.go.jp/gmd/risk/obsdl/top/help4.html#data_tenki)、表と文字列を置き換えます。

Before:

After:

-

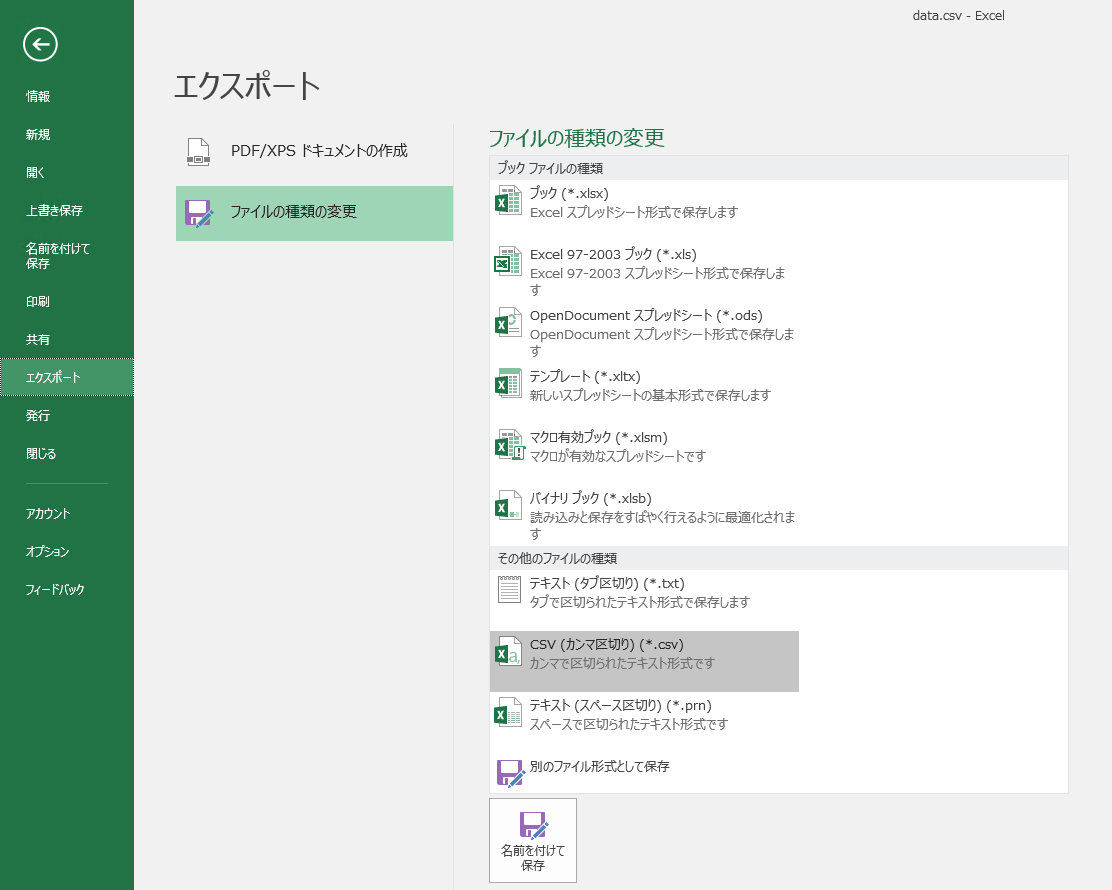

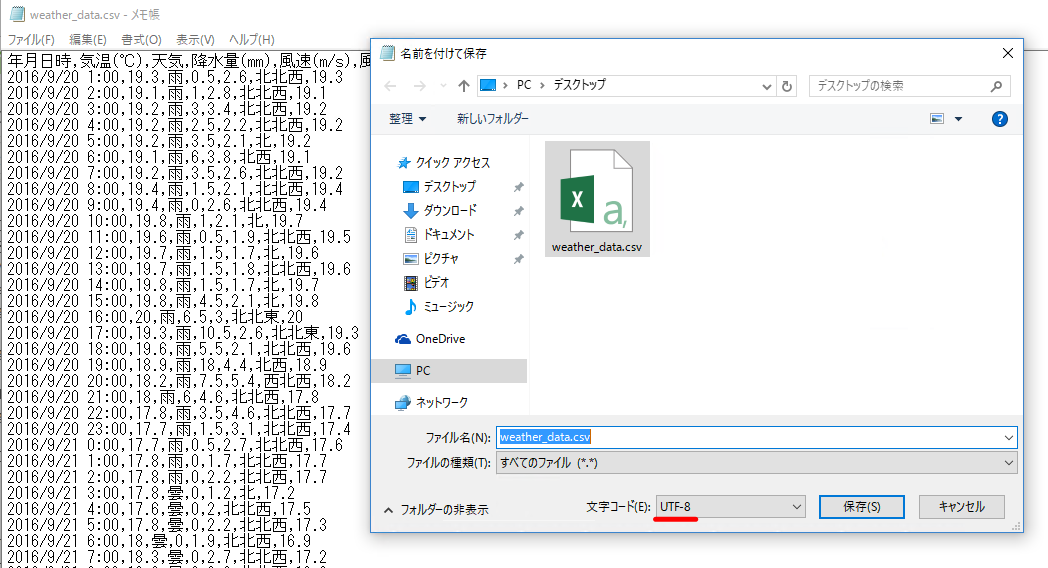

このままだと文字化けするので、メモ帳で開きなおし、文字コードを「UTF-8」にして上書き保存します。

これで、天気情報の準備が整いました。

Azure Machine Learningの準備

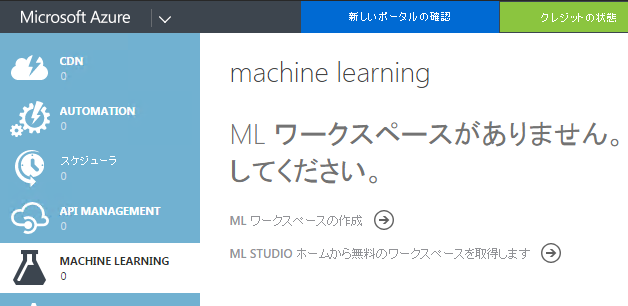

利用するためには、まず、Azure Machine Learningを「[クラシックポータル](URL https://manage.windowsazure.com/)」からサインアップする必要があります。

-

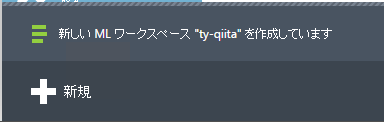

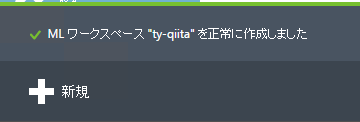

https://manage.windowsazure.com/ へアクセスし、「Machine Learning」をクリックし、「ML ワークスペースの作成」をクリックします。

-

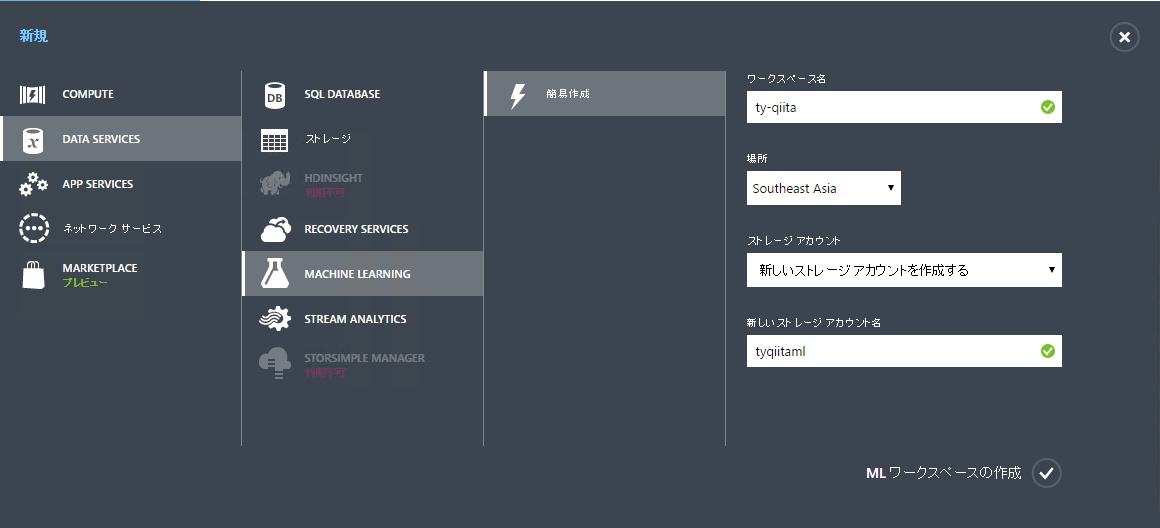

画面下から新規作成画面が表示されます。ワークスペース名を記入し、場所は日本に一番近い「Southeast Asia」を選択します。ストレージアカウントは「新しいストレージアカウントを作成する」にして、ご希望のストレージアカウント名を記入します。すべて記入し終えたら、「ML ワークスペースの作成」を選択します。

-

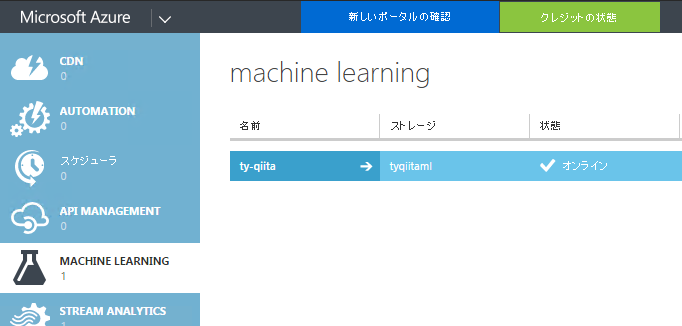

新しく作成したAzure Machine Learningの環境が選択できるようになりました。矢印(→)をクリックします。

-

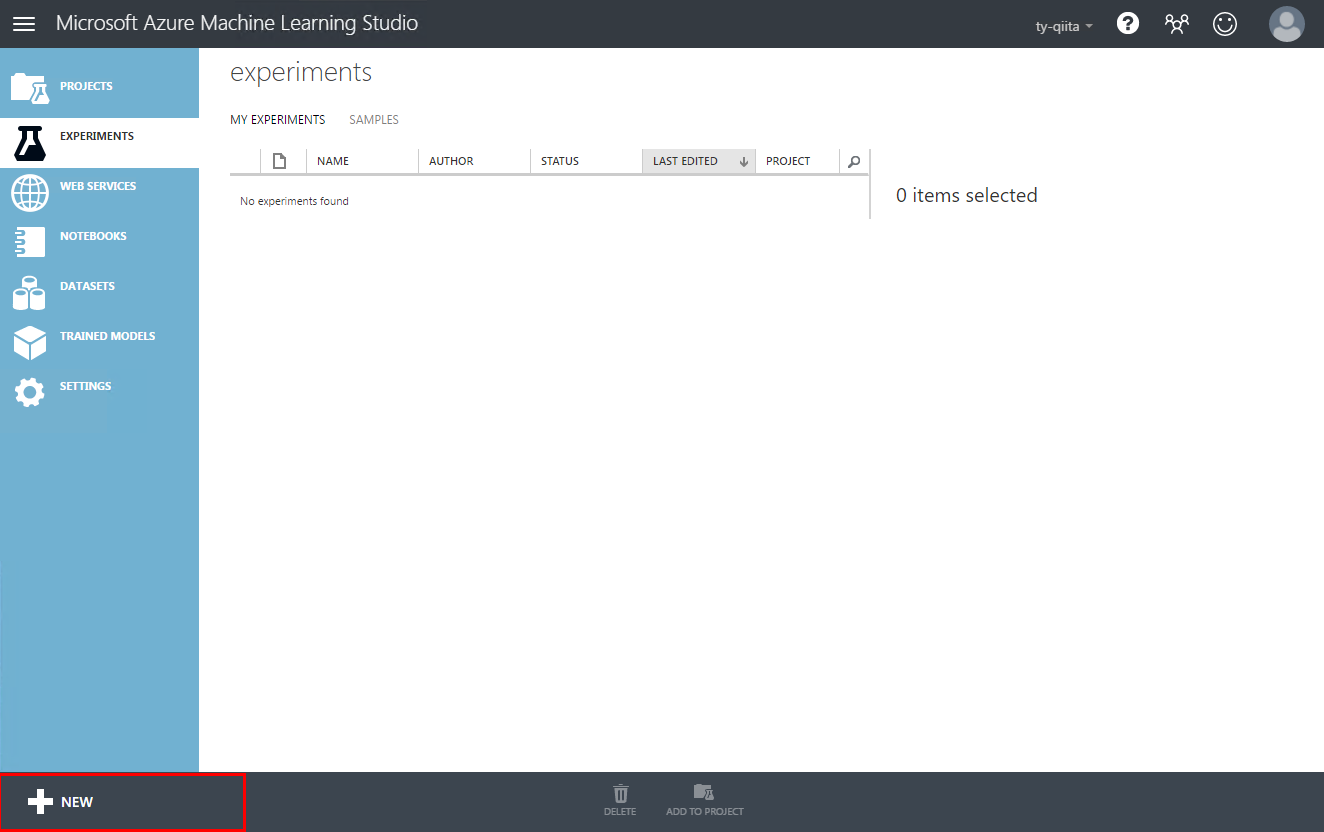

Microsoft Azure Machine Learning Studioの画面が別ウィンドウで表示されました。これでAzure Machine Learning環境の準備は整いました。

Azure Machine Learningで予測モデルを構築する

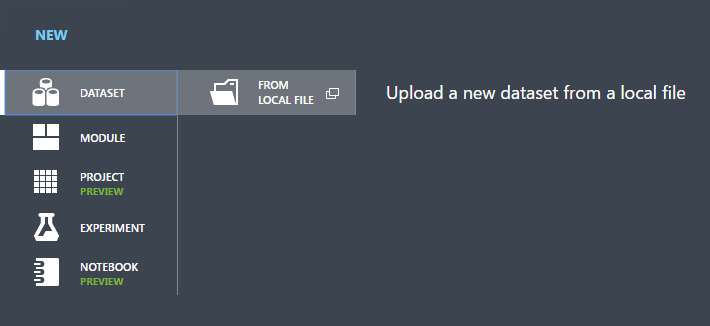

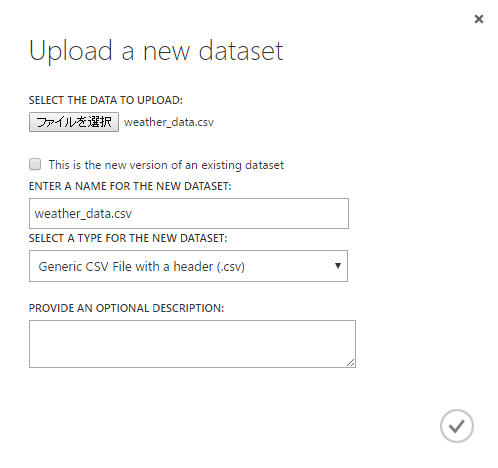

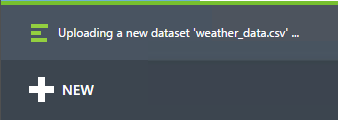

Azure Machine Learningは、データ元として、複数の選択肢が用意されており、Azureストレージアカウントや、Azure SQLデータベース、Azure Data Lake等のAzureサービスはもちろんのこと、それ以外にもローカルに保存しているファイルを直接アップロードしてしまうことも可能です。今回は、[Cortana Intelligence Suiteを構築(第4回)](URL http://qiita.com/taiki_yoshida/items/2b965232045ca2abdc89)で出力先として利用したAzureストレージアカウントと、事前に用意した気象情報(weather_data.csv)をアップロードする方法、2つをご紹介します。

ローカルにあるファイル

Azure ストレージアカウントから

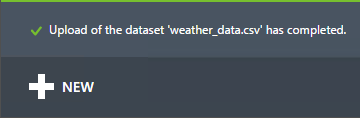

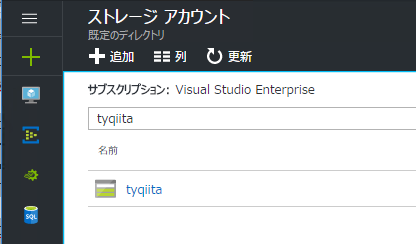

Azureストレージアカウントをデータ元にする場合は、ストレージアカウントキーを事前に取得する必要があります。

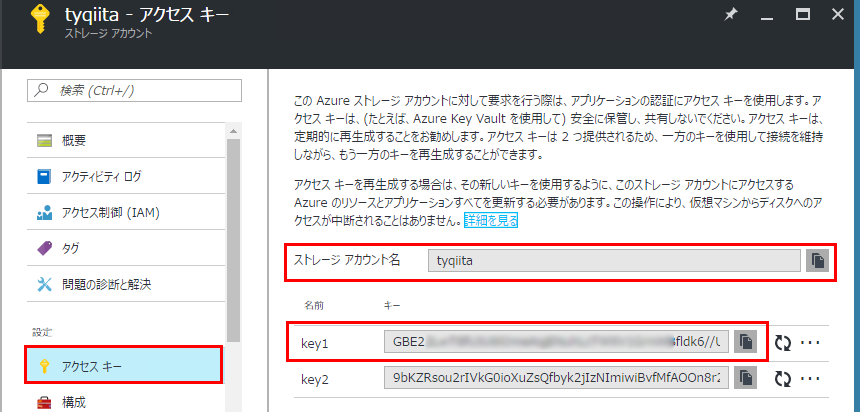

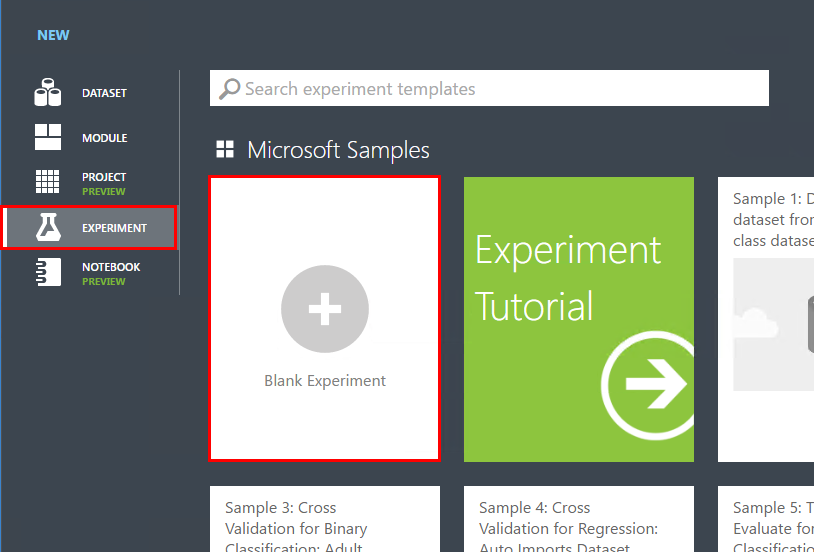

そのあと、新しい「実験(Experiment)」をAzure Machine Learning Studioで作成し、その実験の中で、データ元をAzureストレージアカウントにする必要があります。

-

Azure Portal から[Cortana Intelligence Suiteを構築(第4回)](URL http://qiita.com/taiki_yoshida/items/2b965232045ca2abdc89)で作成したストレージアカウントへアクセスします。

-

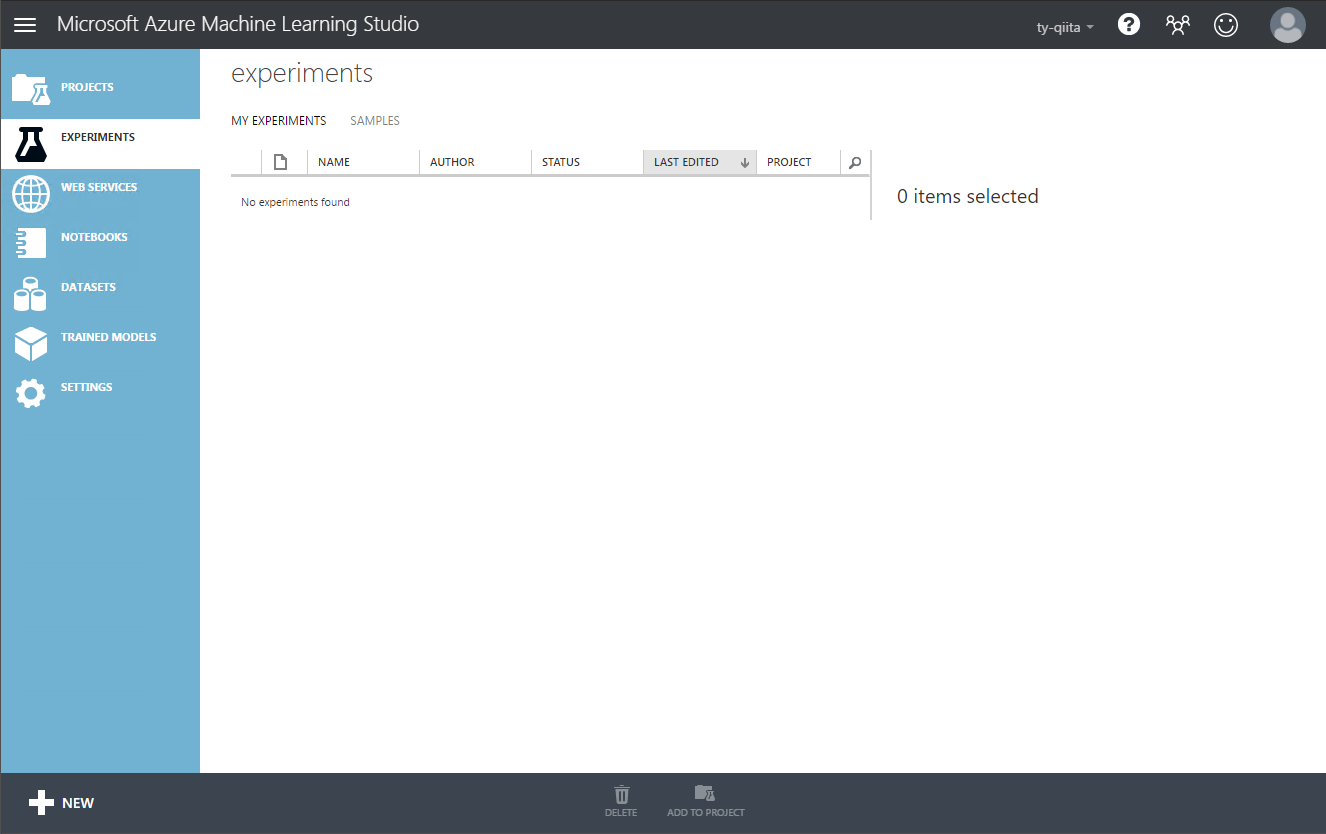

http://studio.azureml.comへアクセスし、「my experiments」をクリックします。

-

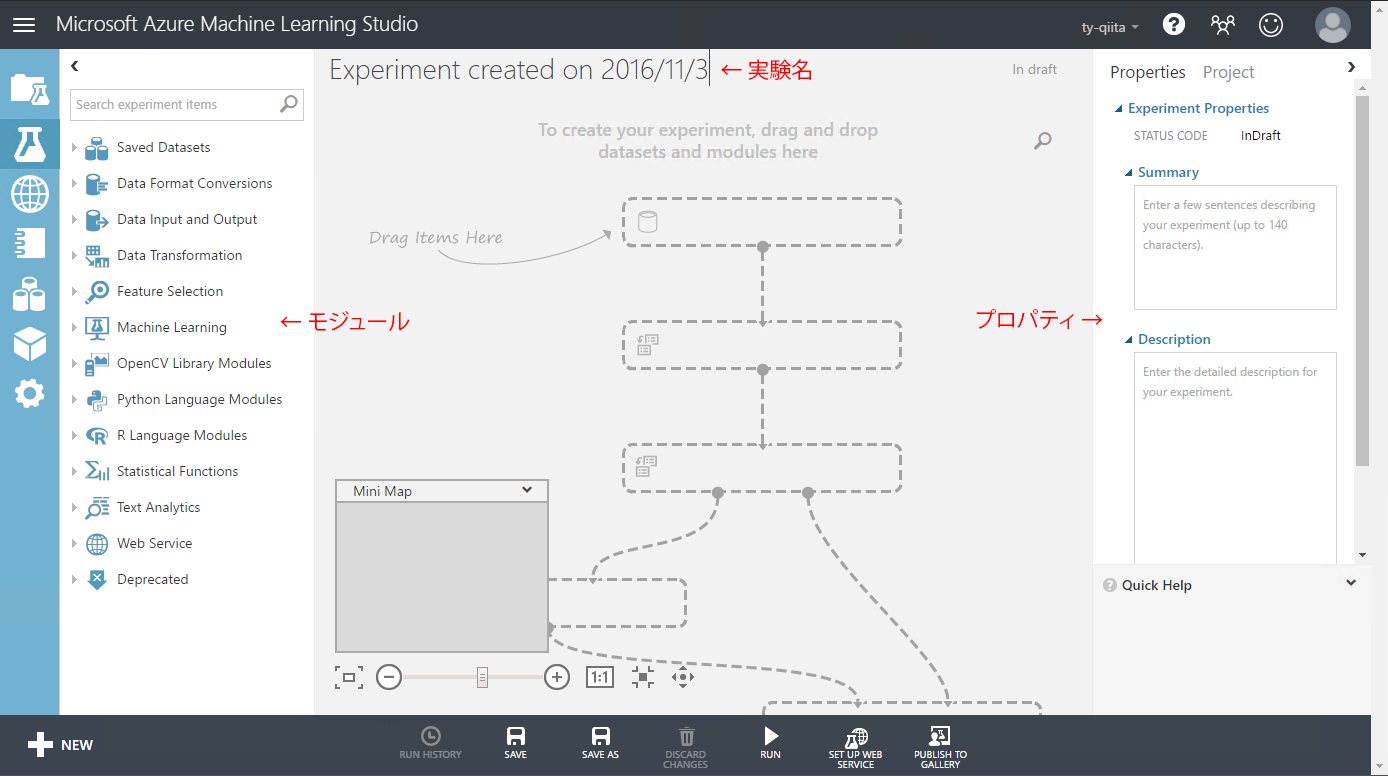

これが、実験(Experiment)の画面です。まずは実験名が「Experiment created on <作成日>」になっているので、わかりやすい名前に変更します。

-

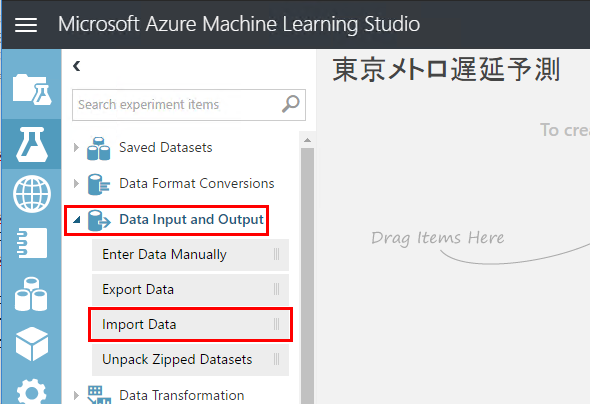

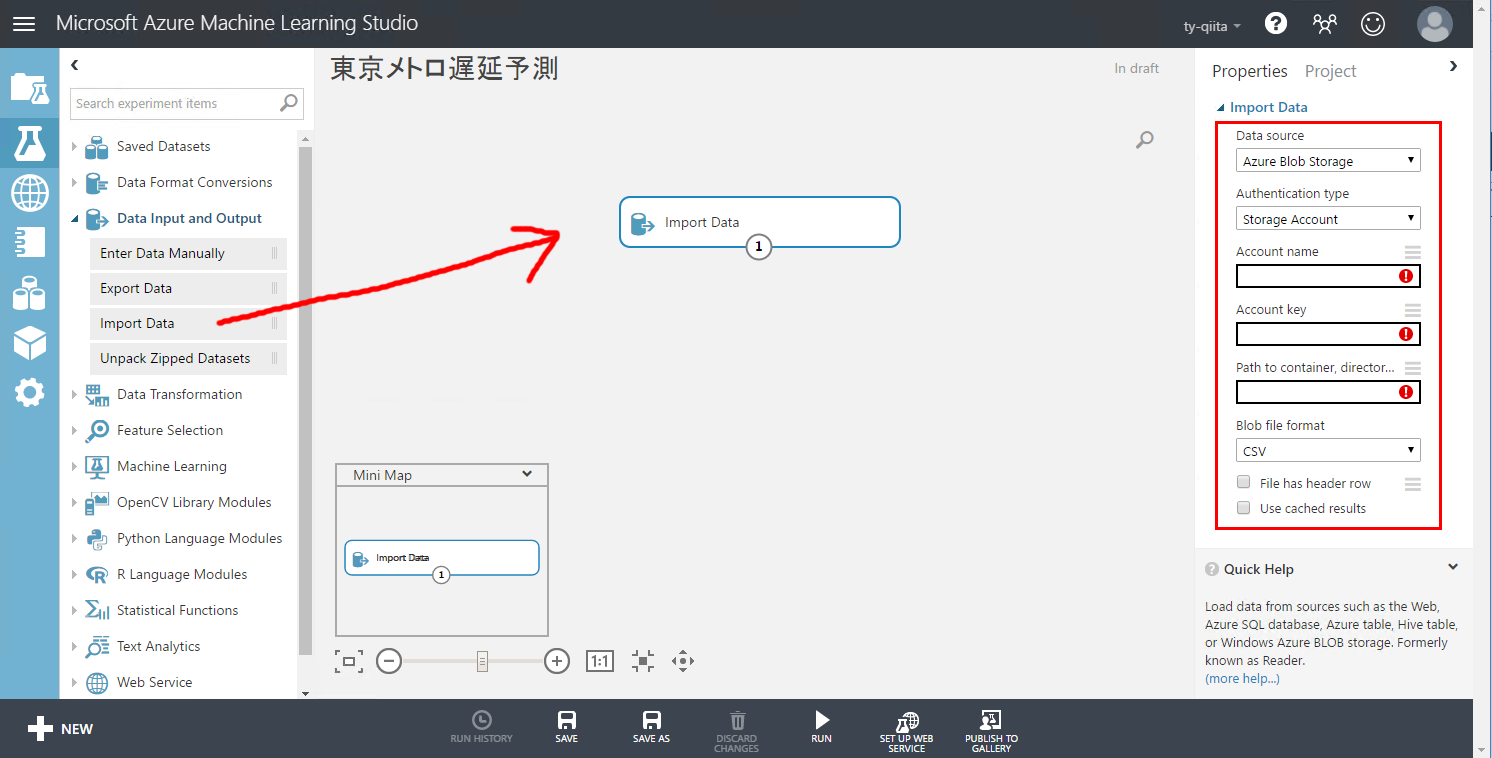

左側にモジュールのカテゴリーが表示されています。クリックすると、カテゴリーの中に含まれる、各モジュールが表示されます。Azure ストレージアカウントを接続するには、「Data Input and Output」のカテゴリーにある、「Import Data」を選択します。

-

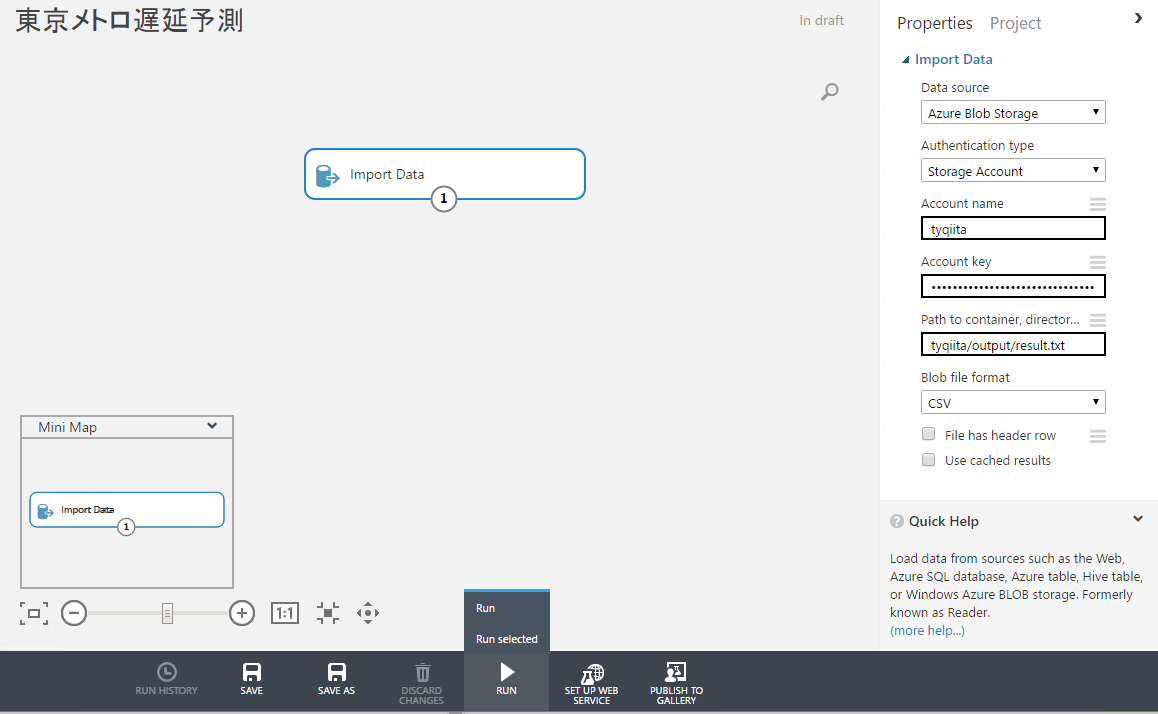

「Import Data」をドラッグ&ドロップで、中央へ持っていきます。画面右側に「Import Data」のプロパティが表示されます。

-

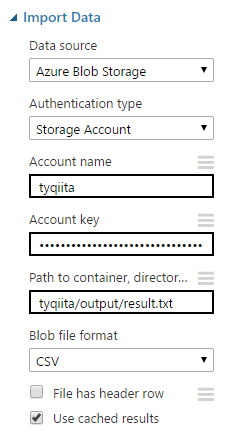

「Data Source」を「Azure Blob Storage」にし、「Authentication Type」は「Storage Account」にします。(2)で取得した、ストレージアカウント名を「Account name」に、キーは「Account key」へ貼り付けます。

Path to containerは、[Cortana Intelligence Suiteを構築(第4回)](URL http://qiita.com/taiki_yoshida/items/2b965232045ca2abdc89)で定義した、ファイルの出力先のパスです。

私の場合は、「tyqiita/output/result.txt」です。「Use cached results」にチェックを入れることで、Azure Machine Learningが毎回Azure Blob Storageからデータを取得せず、キャッシュを保管し、後の構築作業がより早くAzure Machine Learning内で処理できます。

-

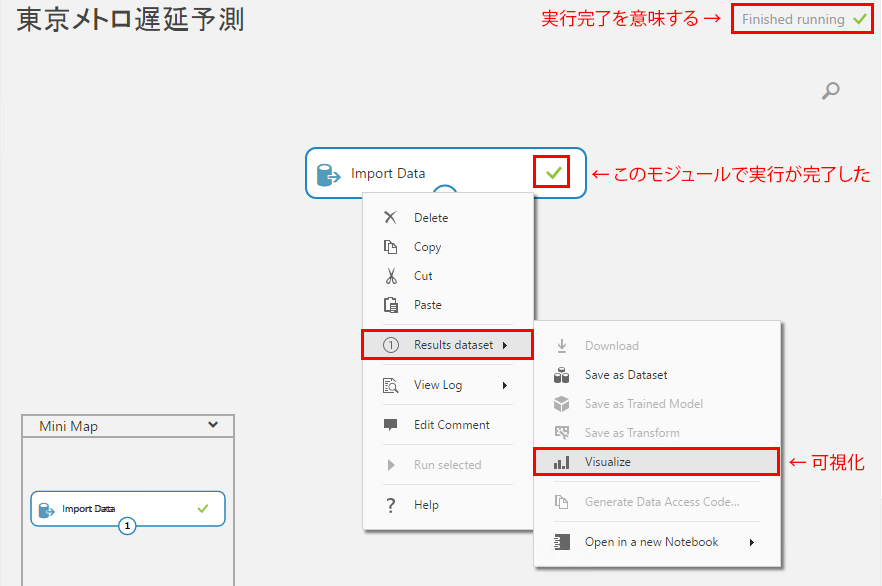

処理が完了すると、「Finished Running」と画面右上に表示されます。実際に取り込まれたデータを確認するには「Import Data」を右クリックし、「Results dataset」から「Visualize」をクリックします。

-

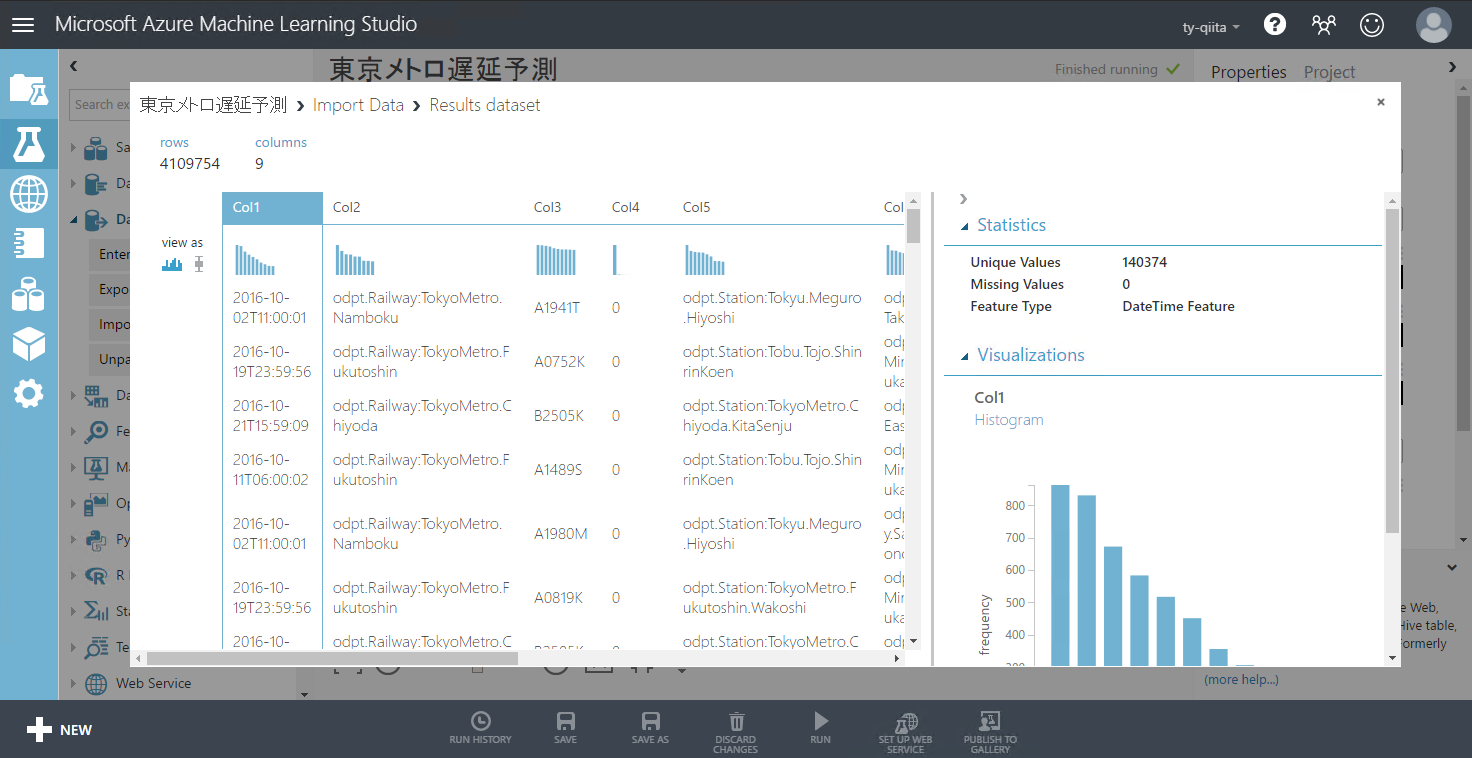

画面に表が表示されました。これが実際に取り込まれたデータのプレビュー画面です。列をクリックすると、一意の値は何件あるか、どんなタイプの列なのか(値、文字列、日付なのか等)の情報も確認できます。

-

これで、データの準備は整いました。次回はこのデータを利用して、機械学習モデルを作成します。