社内で「◯◯は俺に任せろ」「俺に◯◯させろ」という表現が使われ始めています。私はまだまだ駆け出しですが、「人工知能は俺に任せろ!」ぐらい言えるようになりたいものです。

アクセシビリティやるぞ!夏祭り2 ~俺たちにテストさせろスペシャル~

https://connpass.com/event/38351/

さて、Azure Data Factoryを利用して、Azureの世界の中でデータを動かす方法を下記の記事に記載しました。

Azure Data Factoryを利用してAzure StorageのデータをDocumentDBにコピーする

本記事においては、Azure Machine Learningでデータを利用する流れを記載します。Azureの他のリソースから投入する、、というよりも、Machine Learning側でインポートするというイメージになります。

Azure Machine Learningは他のAzure群とは少し違う世界観を持っており、別のドメインに飛ばされる上に料金体系も気をつけないとアクティベートしたワークスペースごとに日々請求されるようです。

前提

上記のqiita記事と同じ前提条件です。そしてまずはサラっと本記事を一通り読んで頂ければ良いかなと思います。

- Azure Machine Learningの課金ワークスペースを確保できること

- Azure Storageをアクティベート出来、何らかのデータを保存していること

- Azure DocumentDBをアクティベート出来、コレクションとデータベースを作成していること

ログイン

Azure Portalから"Machine Learning Studio"を起動します。

なんかエラーが出ました。一つのブラウザの複数のタブでStudio or WorkSpaceを開くのはダメみたいです。

Microsoft Azure Machine Learning Studio

The Studio failed to load. Please refresh this page.

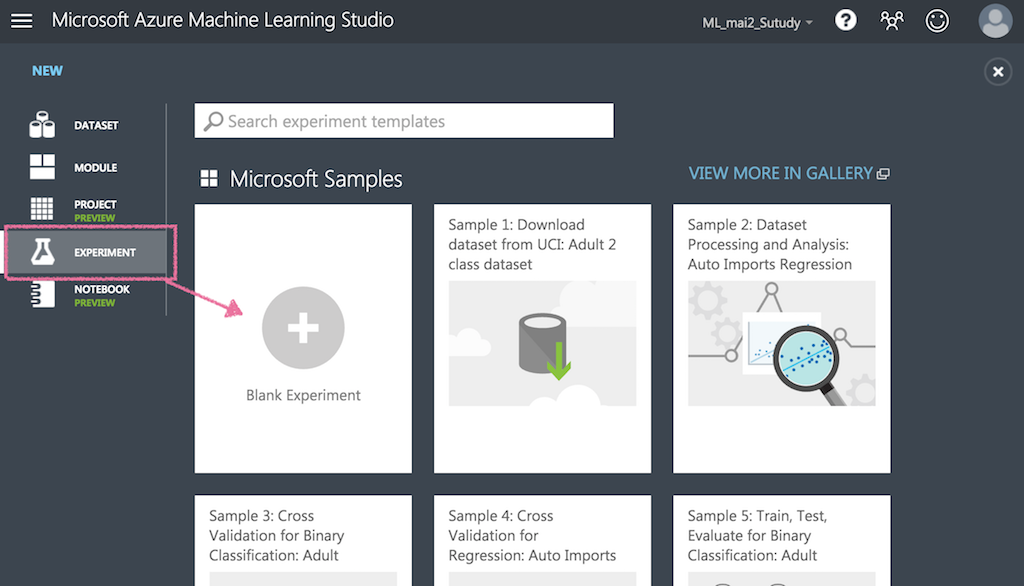

Experimentsとしてデータインポートのための空実験スペースを確保してみます。

データインポート

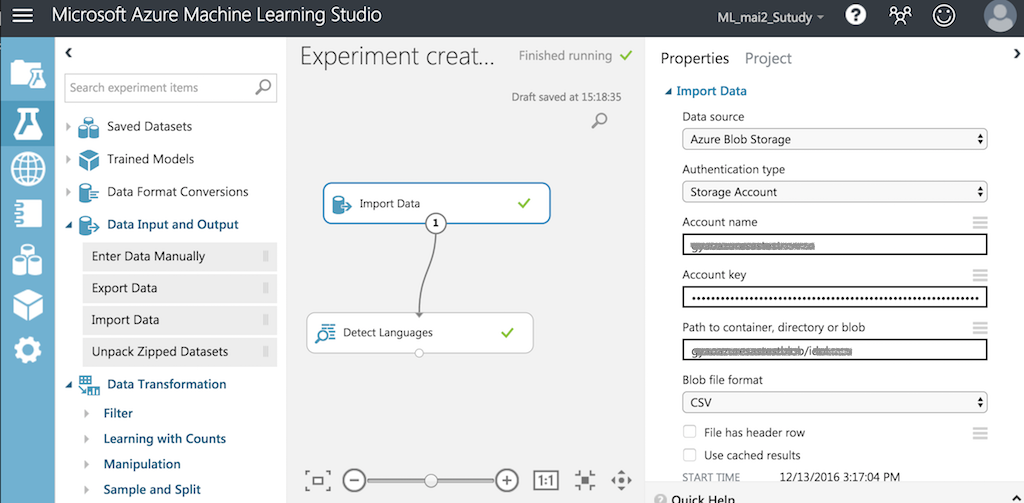

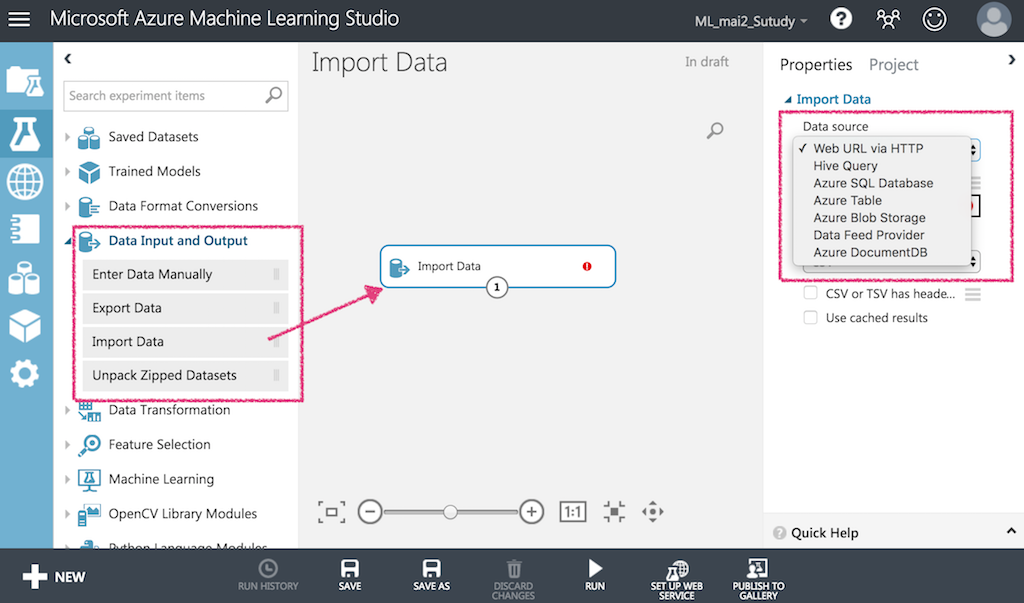

左側リストの「Data Input and Output」から、「Import Data」をドラッグ&ドロップで配置します。

-

選べるデータ元としては以下の7つとなっています。(2016年12月時点、転記しただけです)

- Web URL via HTTP

- Hive Query

- Azure SQL Database

- Azure Table

- Azure Blob Storage

- Data Feed Provider

- オンプレミス SQL Database (プレビュー版らしい)

- Azure DocumentDB

Azure Storageからインポート

Azure Blob Storageからは、以下のデータ形式のファイルをインポートできます。

- ARFF (https://ja.wikipedia.org/wiki/Weka)

- CSV

- TSV

- CSV with encoding

- Excel

上のスクリーンショットの続きとして「Azure Blob Storage」を選択し、それぞれ必要事項を入力していきます。

ストレージアカウント・アカウントキーについては以下のリンク先の記事のスクリーンショットを御確認ください

Azure Storageへのアクセス方法

なんの難しいこともなく、データをインポートできました。。

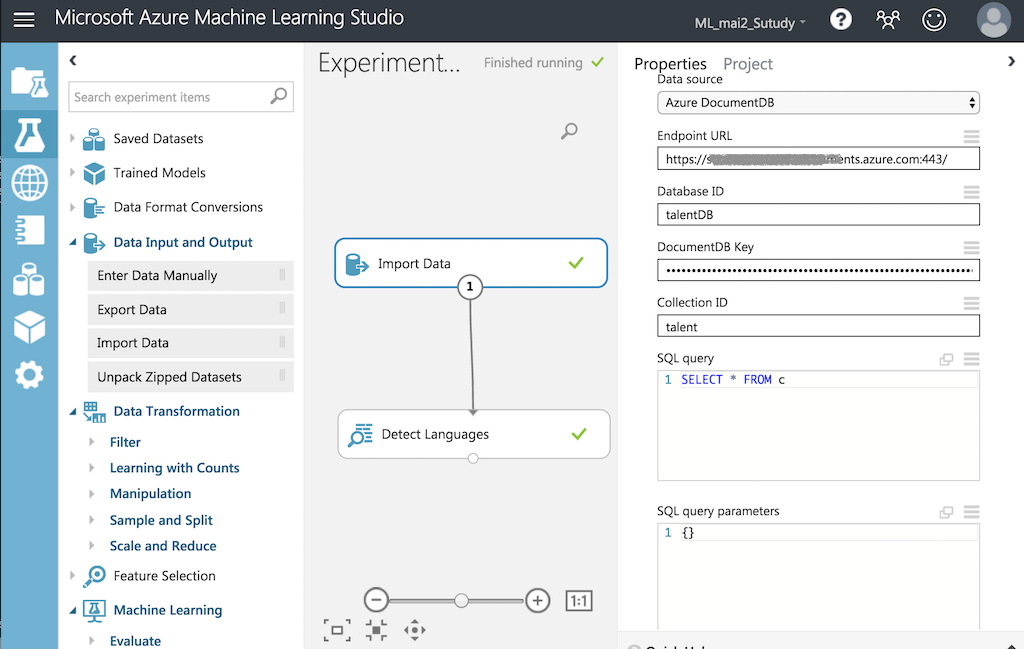

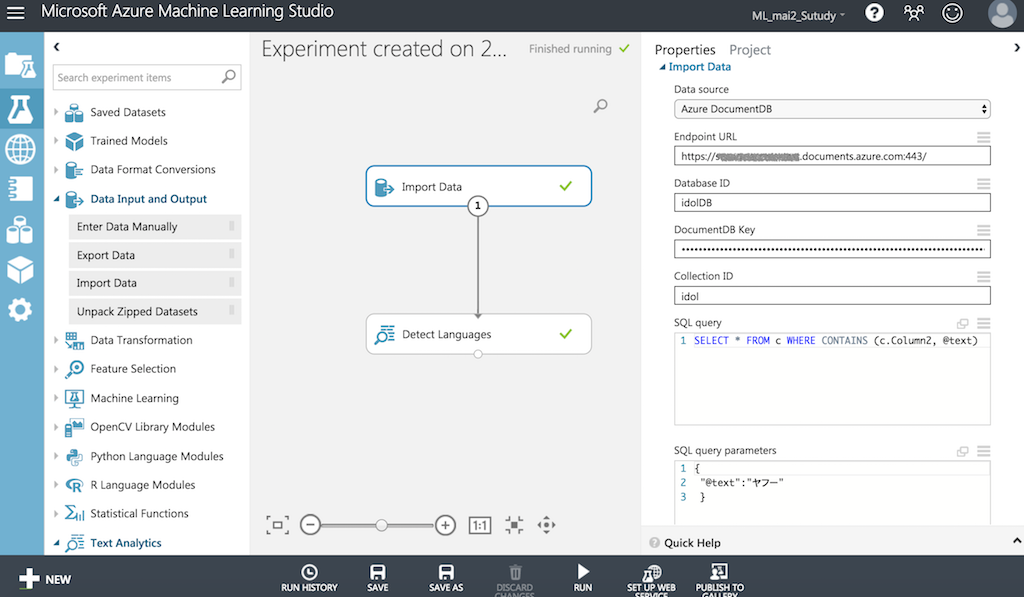

Azure DocumentDBからインポート

基本的にはAzure Storageと同じで、コレクション・データベース名を入力します。

古いドキュメントには無い「SQL query parameters」という項目がありました。どうやら変数のバインド処理を行うもののようで、"value required"となっており何かをセットしなければなりません。

Microsoftにありがちな謎ドキュメントを辿ったところ、JSONを入力すれば良いことがわかりました。"select * from c"というSQL文に対して、以下の通り入力しました。(気付くのに時間がかかりました。。。)

{}

間違ったJSONを入れると、下記のようなエラー文言が出力されます。

errorComponent=Module. taskStatusCode=400.

{"Exception":{"ErrorId":"LibraryException","ErrorCode":"1000","ExceptionType":"ModuleException","Message":"Error 1000: DocumentDb library exception: The SQL script is invalid","Exception":

{"Library":"DocumentDb","ExceptionType":"LibraryException","Message":"The SQL script is invalid","Exception":

{"ExceptionType":"Exception",

"Message":"Message: {\"Errors\":[\"Invalid query. Specified parameter name 'query' is invalid. Parameter names should be in the format of symbol '@' followed by a valid identifier.

SELECT文で条件を追加してインポート

PDOのパラメータバインドを思い出しつつSELECT文を書いてみます。

Microsoft SQL Serverの書式なのか、LIKEでなく CONTAINSでいけました。

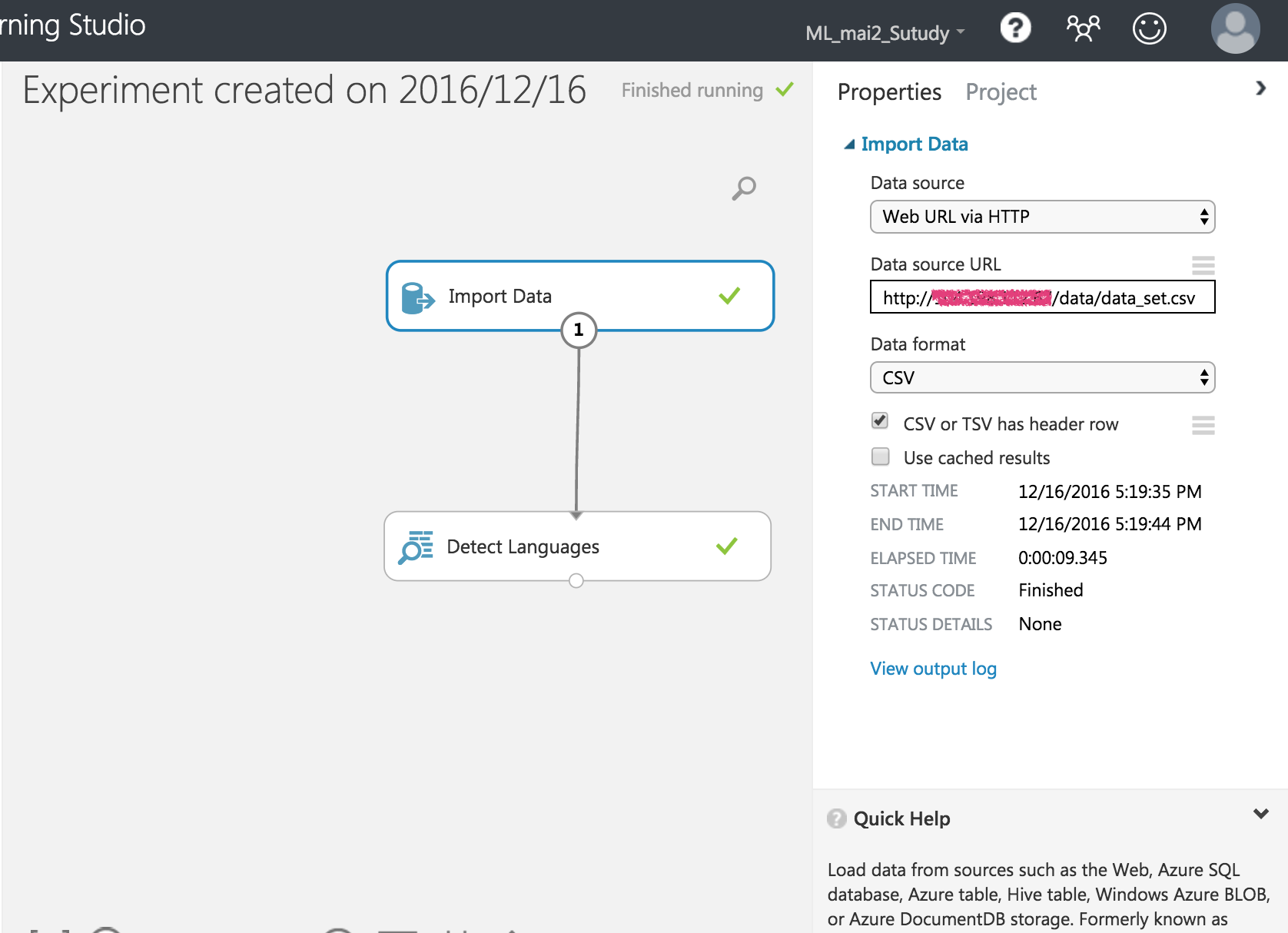

オンライン上のデータをインポート

2016年12月16日追記

オープンなデータをインポート出来ることは当たり前として、自前/パートナーのデータをインポートすることを考えてみます。

Machine Learningのインポート設定からでは、各種認証には対応していないようですので、最低限のセキュリティとして、外部サーバ側でIPアドレスフィルタリングを利用することを考えてみます。

Machine LearningのIPアドレスの確認としては、一回何もない状態で何でも良いのでMachine Learningからアクセスしログを確認します。(もしかしてどこかに表示されている?)

13.xx.xx.xx - - [16/Dec/2016:05:25:41 +0000] "GET /data_set.csv HTTP/1.1" 200 1127413 "-" "-"

こちらを利用します。

サーバ側でIPアドレス制御するので、httpd.confファイルを書き換えます。

(確認するだけなので、皆様方におかれましては本番環境はちゃんとしたやり方でやってくださいね!)

<Directory "/var/www/html/data">

Order deny,allow

deny from ALL

allow from 13.xx.xx.xx

</Directory>

Azure Machine Learningから読み込んでみます。

ものすごく当たり前のIPアドレス制御をやっただけになってしまいましたが、取り敢えず。

むしろ、単体で認証系が出来ないことがわかっただけでも良しとしたいと思います。

おわりに

兎にも角にも、Azure Storage/DocumentDBからデータをインポートすることができました。

"Web URL via HTTP"というのは、ダイレクトにデータを取ってくるのでURLさえ設定すればOKみたいです。なんかコワいですね (追記にてIPアドレスフィルタする流れを確認しました)

どこでデータを整形するかですが、投入前に下拵えが終わってればMachine Learning内部でいけそうですし、DocumentDBのSQLクエリで抽出するやり方もできそうですね。

付録

2016年12月16日編集

Machine Learningに持ち込むまでに、いくつかのポイントがあることがわかりました。

- Machine LearningにはCSV形式かTSV形式のデータの方が入れやすい。

- Machine LearningはAzure世界の中でも別枠ポジション。

- DocumentDBからのデータインポートではSQL文を利用出来る。

→DocumentDBにはデータを雑多に入れれば良いとして課金はどこに付く??

- DocumentDBからのデータインポートではSQL文を利用出来る。

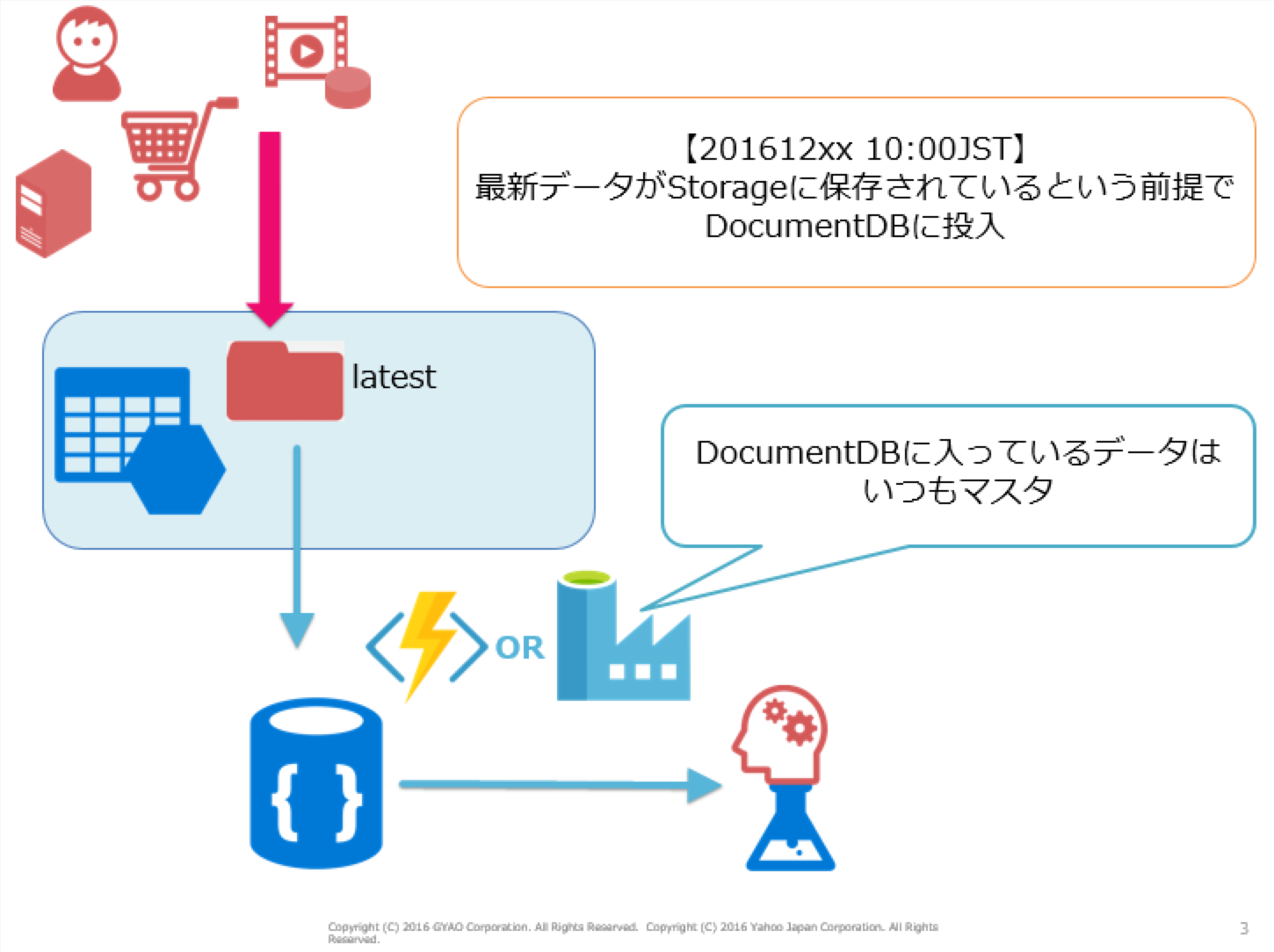

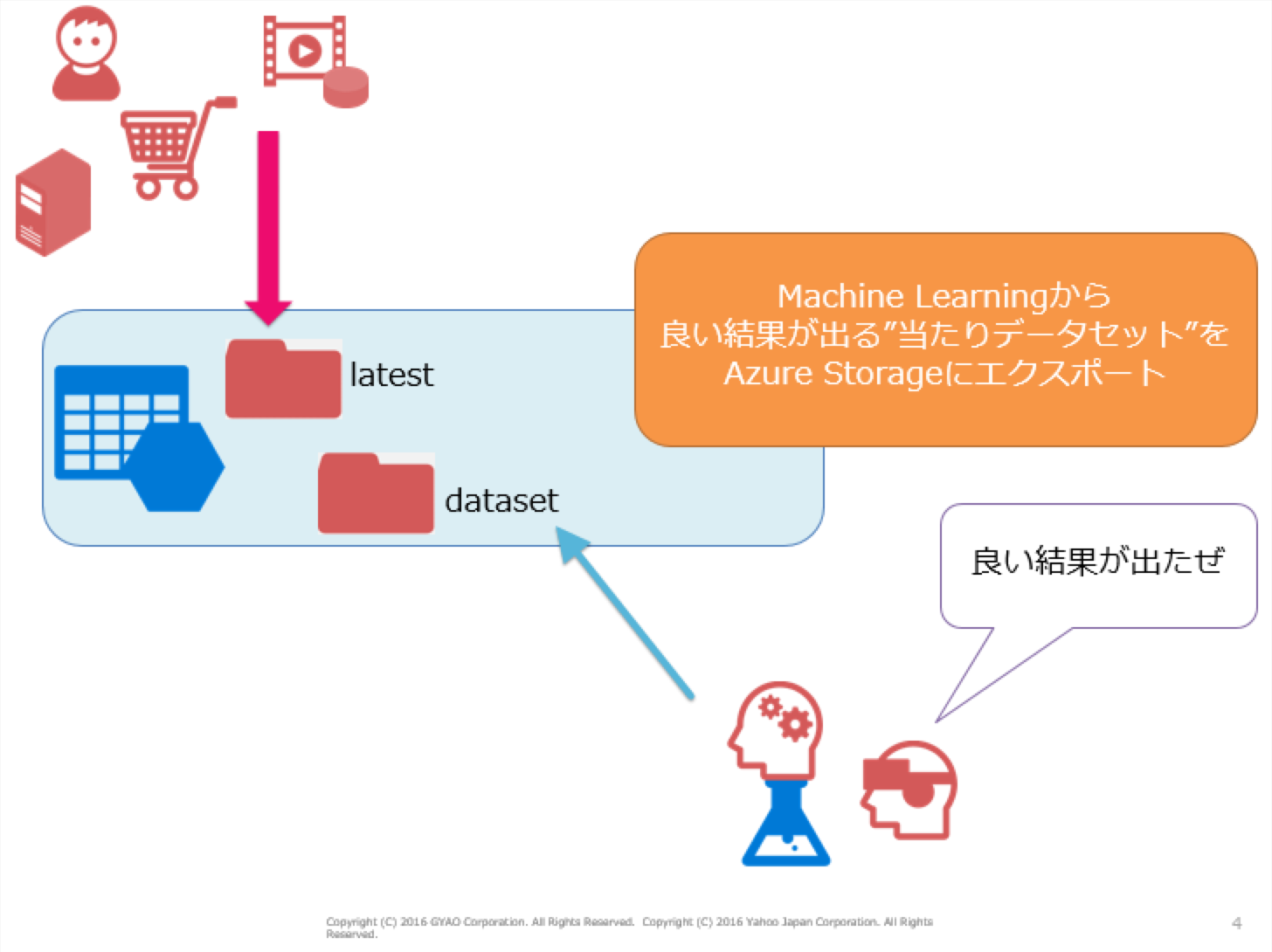

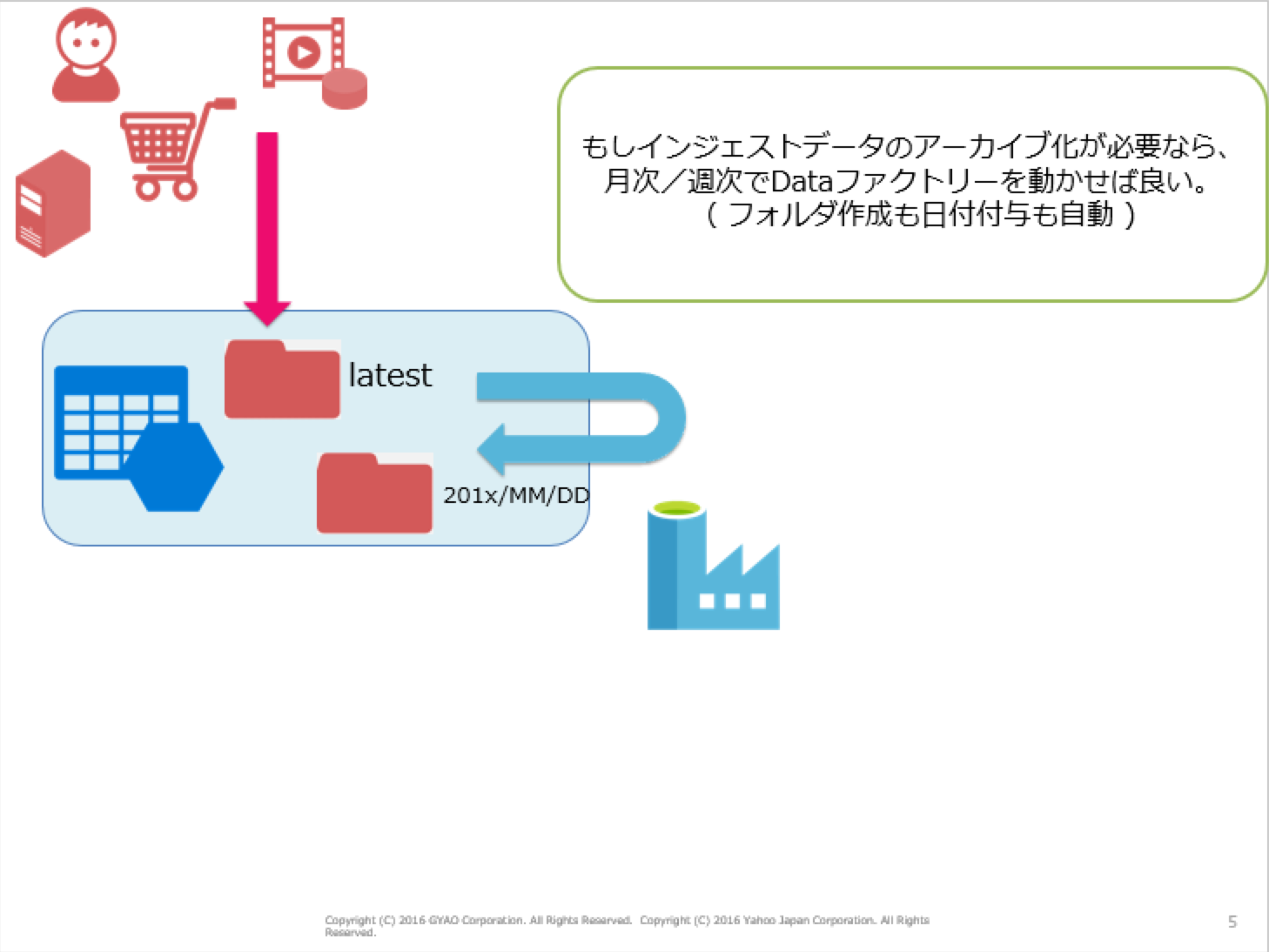

まだMachine Learningの全容が理解できてないのですが、Machine Learningを使った作業の進め方として、下図のようなデータフローを考えてみました。

#1. Azure世界にデータがバラバラなタイミングでインジェストされる(関連記事)

#2. Data Factoryによって、ある時点でのデータがDocumentDBに投入される(関連記事)

#3. 担当者はMachine Learningで必要なデータをインポートする(この記事で説明)