Machine Learning by Stanford University WEEK5 のまとめ

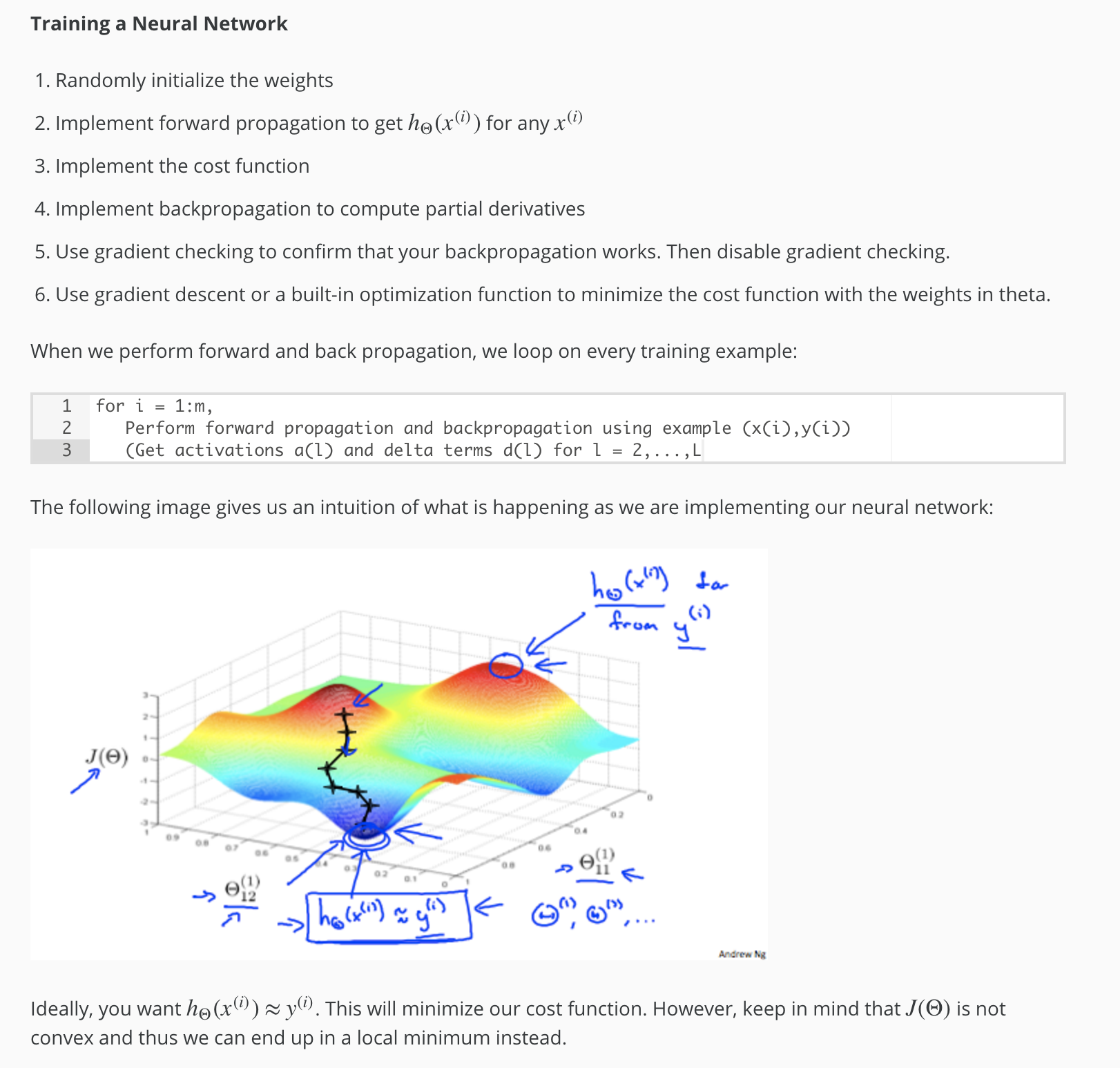

コスト関数とバックプロパゲーション

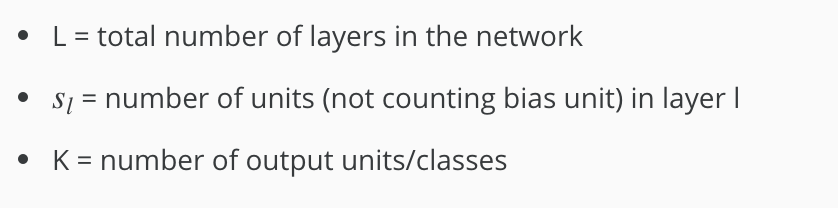

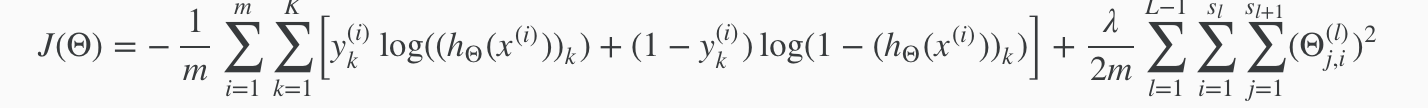

コスト関数

ニューラルネットワークのコスト関数はロジスティック回帰のコスト関数を一般化した以下となる。

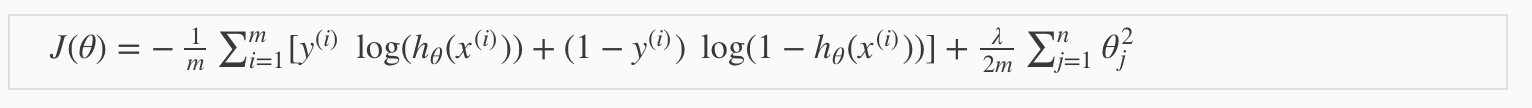

バックプロパゲーションアルゴリズム

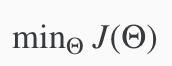

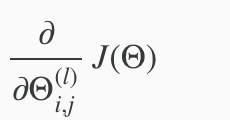

バックプロパゲーション(逆伝播)はニューラルネットワークのコスト関数を最小化する手法

を算出するのに以下のバックプロパゲーションアルゴリズムを適用する。

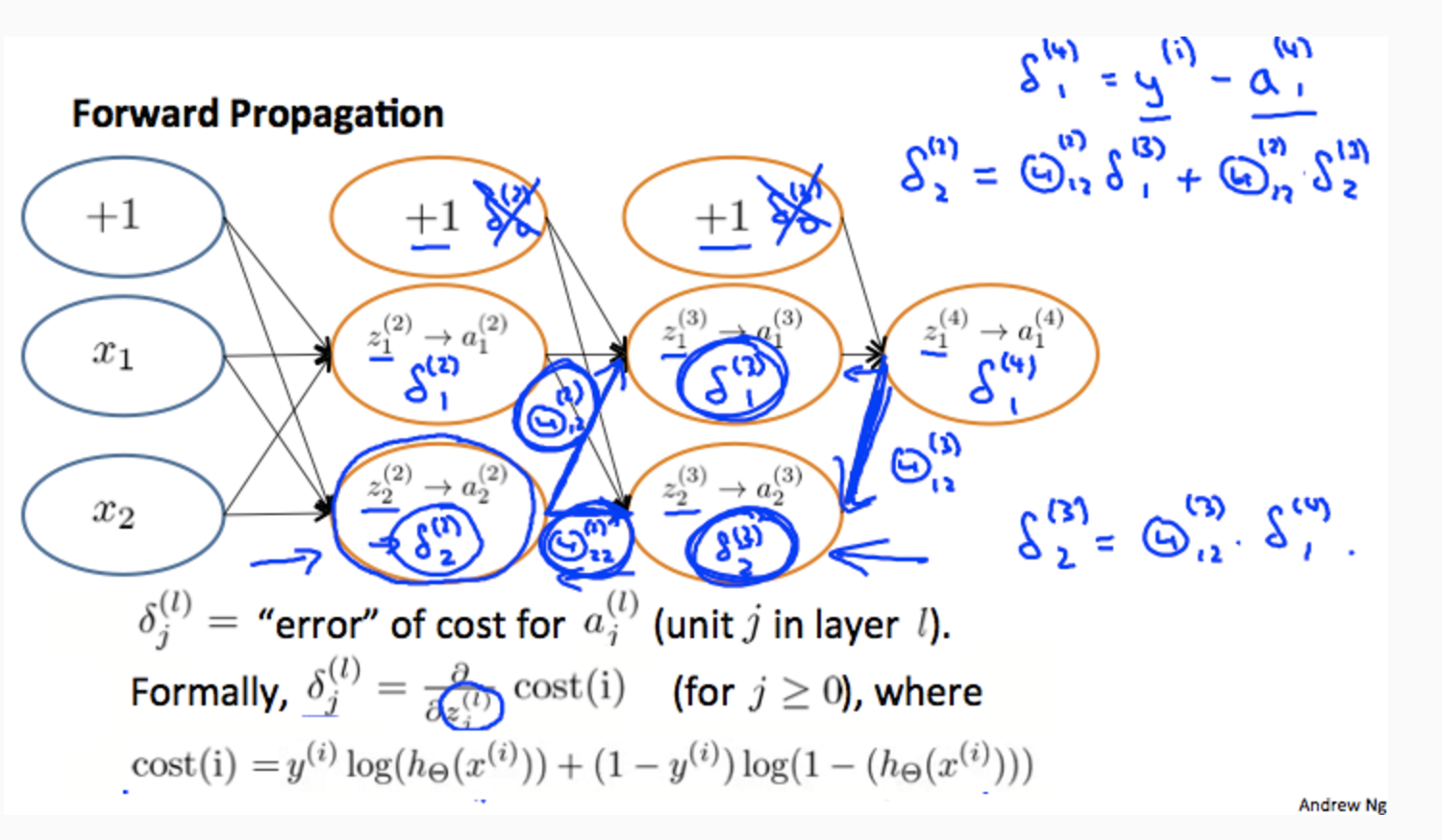

バックプロパゲーショでやっている事は期待値との差分δを逆方向(出力層から入力層へ以下のように伝播させている。

#バックプロパゲーションの適用法詳細

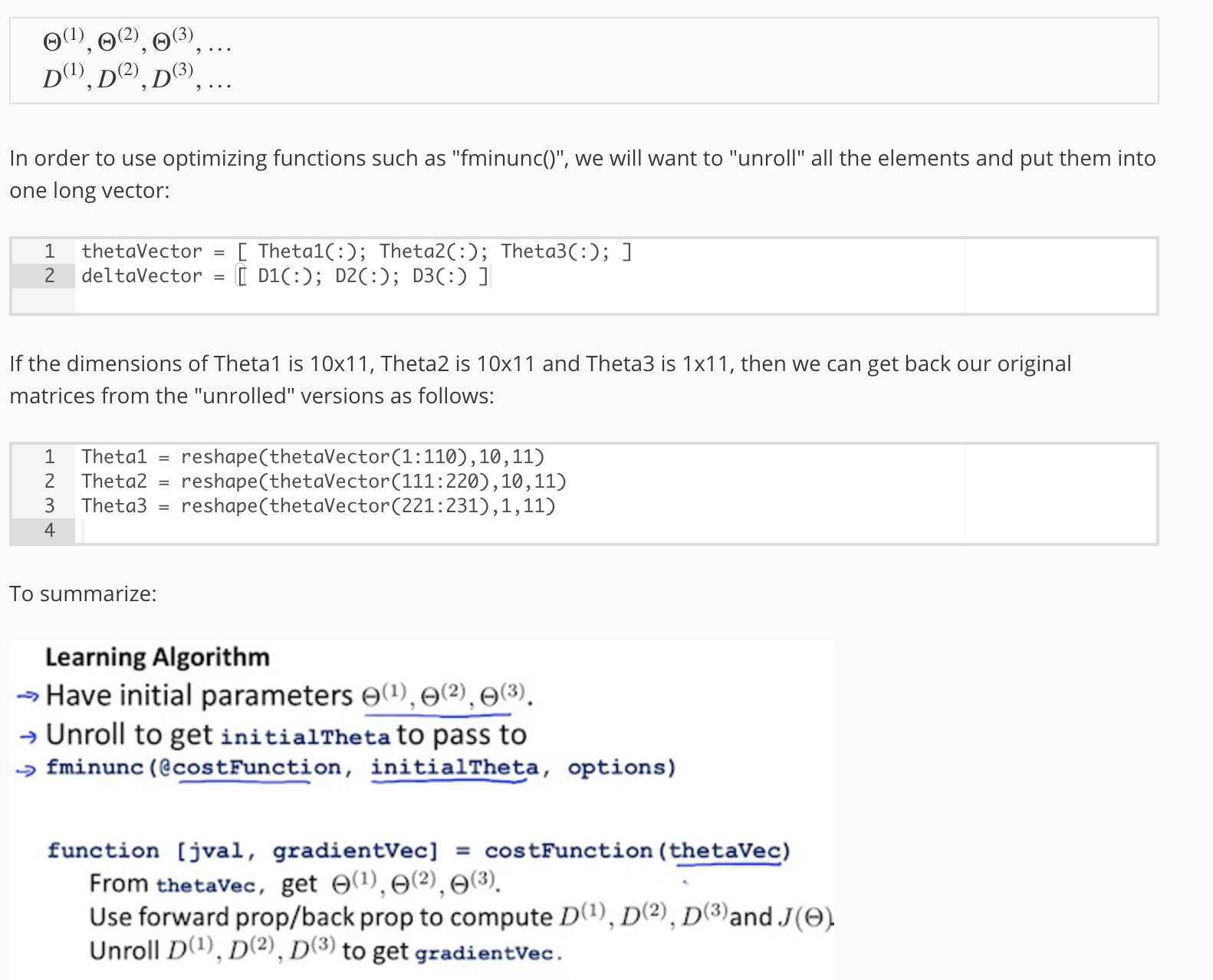

行列→ベクトルに変換した実装方法

θ、D(行列)をベクトルに変換する方法、それを元の行列に戻す方法 具体的なoctaveでの実装方法は以下。

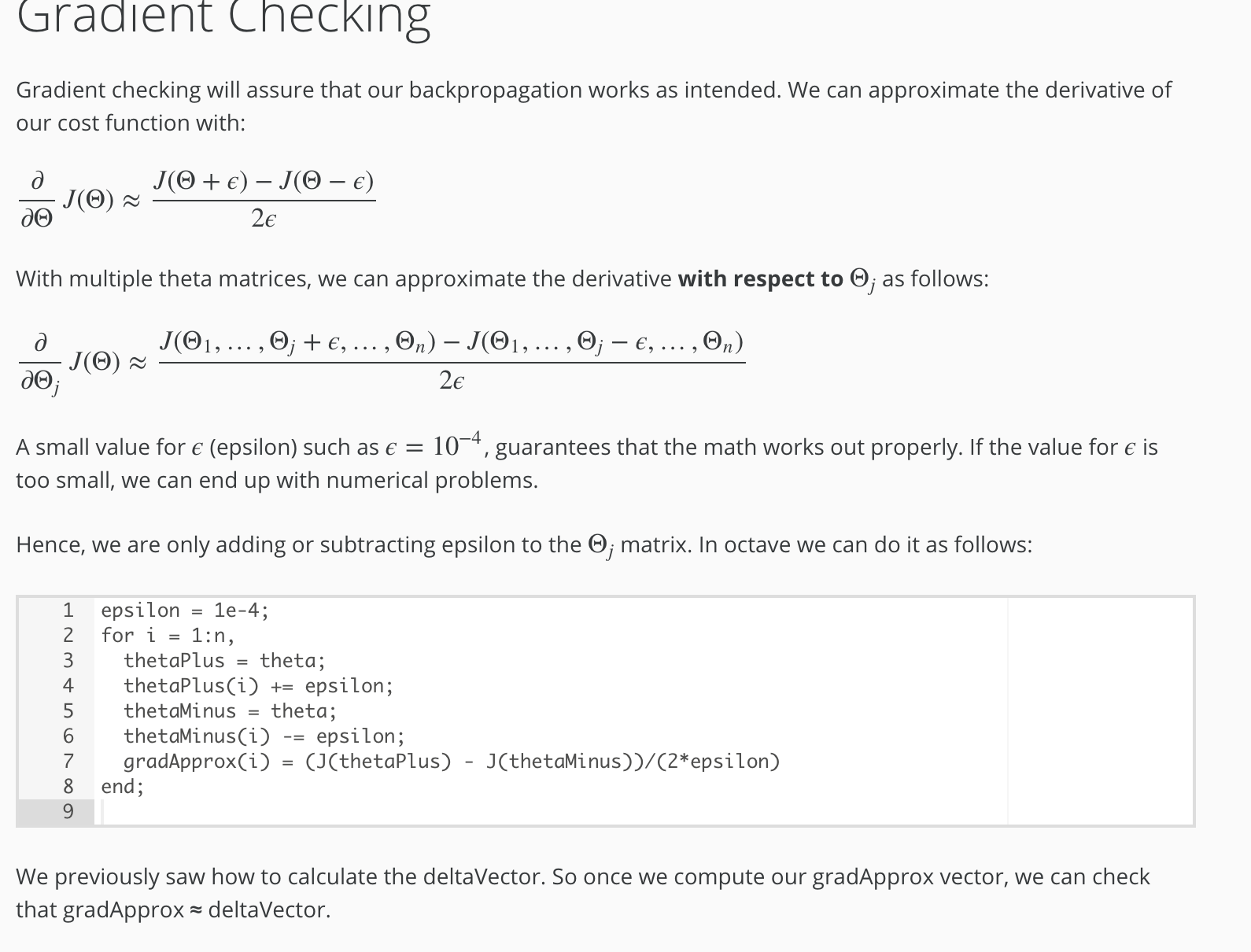

グラディエントチェッキング

バックプロパゲーションで計算したJ(θ)の微分が正しいかをチェックする方法。

★グラディエントチェッキングは時間のかかる処理なので、チェックのみに利用し、実際に計算を走らせる時にはコメントアウトする等が必要。

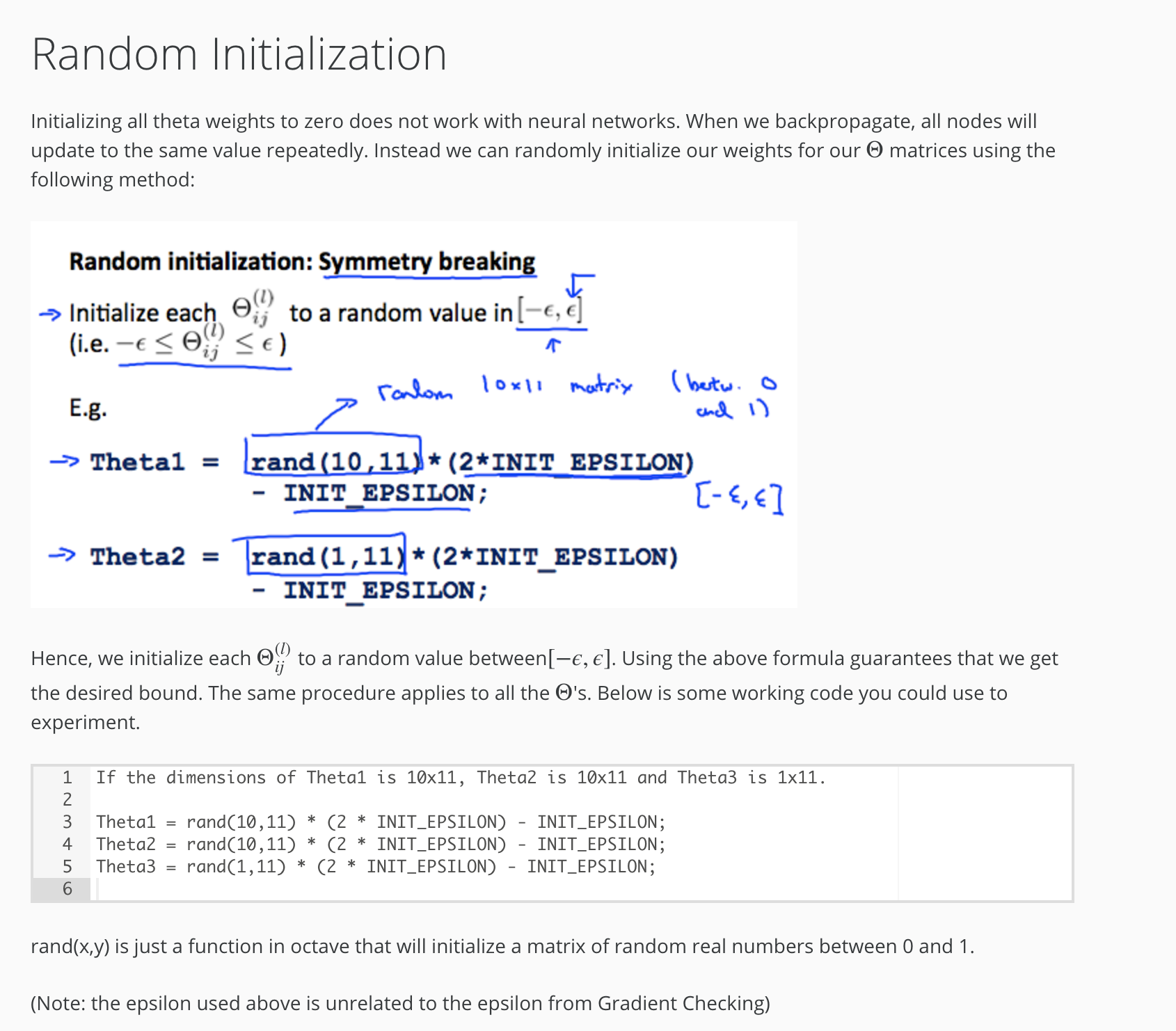

ランダム初期化

θの初期値を0にしてしまうとうまく計算されないので、0近くのランダムな値で初期化する必要あり。