はじめに

2017/4/4にリリース予定のNAOqi OS 2.5.5に搭載される新機能である「SLAM機能」を使ってみたのでまとめます。

なぜSLAMなのか

2017年2月の1ヶ月間、シリコンバレーに行ってきました。

アメリカでロボットといえば、アマゾンの倉庫ロボットや、ショッピングセンターの警備ロボットなど、移動を伴うロボットが当たり前になっています。

感性に訴えかけるロボットは日本独特の文化といえますが、Pepperも移動をすることによって、活用できるシーンが大幅に広がるのではないかと思い、SLAMの機能を試してみました。

SLAM機能とは

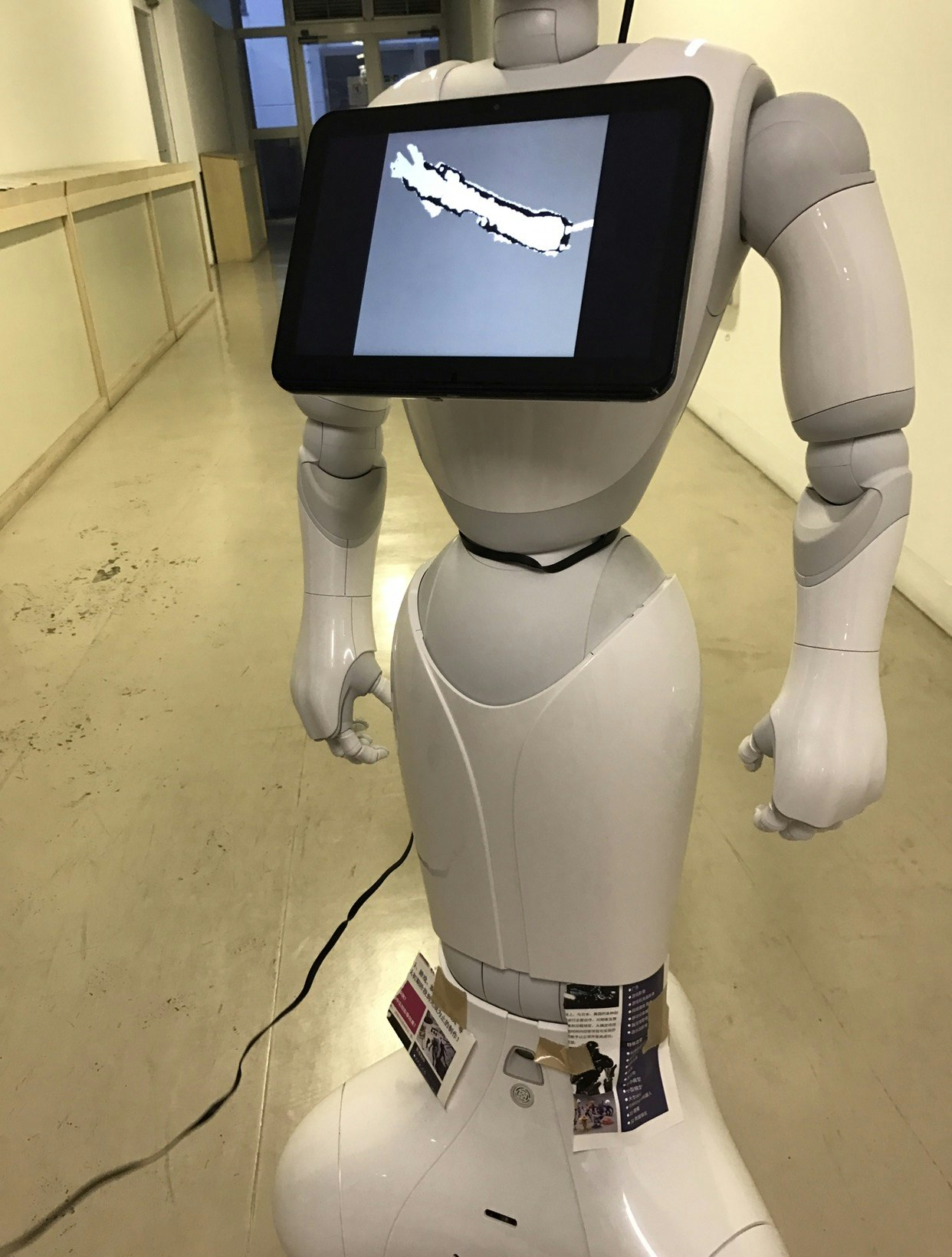

SLAM (Simultaneous Localization and Mapping) とは、__自己位置推定__と__環境地図作成__を同時に行うことを言います。Pepperでは、ざっくり言うと自身が移動できる場所を探索しその地図を作成します。また、特定した移動可能な範囲で指定した方向に移動します。

これによりPepperが特定のエリアを徘徊させることができるので、移動しながら展示物の説明など、これまで以上に動きのある作業を行うことができるのではないでしょうか。Pepperのもつポテンシャルを大いに引き出すことのできる機能とも言えるかもしれません。

使用するセンサー

実際に、SLAMの探索でPepperがどのセンサーを使って地図作成をしているのか、検証してみました。

Pepperには、様々なセンサーが取り付けられています。今回は、以下の地図作成時に使用されるであろうセンサーに絞って、一つ一つ隠していきました。

| 部位 | センサー名 | 数 |

|---|---|---|

| おでこ・口 | RGBカメラ | 2 |

| 目 | 3Dセンサー | 1 |

| 脚部 | レーザーセンサー | 6 |

| 脚部 | ソナーセンサー | 2 |

| 脚部 | 赤外線センサー | 2 |

結果

PepperがSLAMの地図作成で使っていたのは、

_ソナーセンサー___と__レーザーセンサー__でした。

ちなみに、この二つのセンサーを隠したまま、Pepperを起動(Wake up)すると、「あれっ、僕の足の調子が悪くて動けないですぅぅ」的なことを発して再起動を求められます。

正常に起動さした後に、センサーを隠すことで、検証が始められました。

もちろん、Pepper側からすると周りは障害物だらけと認識するので、その後、一歩も動かず"レーザーセンサー"__のみを使った地図作成を行なっていました。

スラムの詳細は。SOFTBANK ROBOTICS DOCUMENTATIONの以下に記載されています。

[NAO qi APIs ALNavigation¶] (http://doc.aldebaran.com/2-5/naoqi/motion/alnavigation.html#alnavigation-exploration)

次の記事で、実際に実装したところについて書いていきます。

Pepper NAOqi OS 2.5.5 SLAM機能を試す〜その2〜