はじめに

最近はチャットボットが何かと流行っています。このような機械と自然言語で対話するシステムというのは昔から多くの人に期待されていました。 今回はそんな期待に応えるべく?機械学習を使って対話システムを作ってみました。作成物の概要

今回作成したのは対話を通じてレストラン検索を行うシステムです。イメージとしては以下のような対話を行います。"U"とついているのがユーザ発話、"S"がシステム発話です。| 発話 |

|---|

| U:スペイン料理店を探して。 |

| S:スペイン料理店ですね。場所はどの辺りですか? |

| U:新宿周辺 |

| S:新宿のスペイン料理店ですね。予算の上限はどのくらいですか? |

| U:4000円くらい |

| S:4000円ですね。それではこのお店はどうでしょうか? |

| S:(店を出す) |

システムアーキテクチャ

対話システムは複数のモジュールから構成されています。今回は、各モジュールは独立に動作させず、前段階のモジュールの処理が終わった段階で駆動されるようにしています。 最終的なシステムアーキテクチャは以下の図のようになりました。

今回のアーキテクチャに沿って処理の流れを説明すると以下のようになります。

- ユーザがテキストを入力すると、入力したテキストは言語理解部に入力されます。

- 言語理解部では入力されたテキストを解析して、対話行為と呼ばれる抽象的な意味表現に変換します。

- 言語理解部から出力された対話行為は、対話管理部に入力されます。対話管理部では入力された対話行為を基に、対話システムの内部状態を更新します。また、更新した内部状態を基にシステムの行動を決定し、対話行為を出力します。

- 対話管理部から出力された対話行為は言語生成部に入力されます。言語生成部では入力された対話行為を基に、システム発話を決定します。

それでは、処理の流れもわかったところで、各モジュールで行っている詳細な処理について見ていきましょう。

言語理解部

言語理解部ではユーザの発話から対話行為を推定します。この対話行為の推定は対話行為タイプの推定と属性抽出から構成されています。ここで、対話行為タイプは発話の種類を表しており、属性は属性名と属性値からなります。対話行為タイプをact_type、属性名をa、属性値をvと書くことにすると、対話行為はact_type(a1=v1, a2=v2)のように表せます。

この表記を用いてユーザ発話の対話行為を推定すると以下のようになります。

| 発話 | 対話行為 |

|---|---|

| U:スペイン料理店を探して。 | INFORM_GENRE(genre=スペイン料理) |

| S:スペイン料理店ですね。場所はどの辺りですか? | |

| U:新宿周辺 | INFORM_LOC(location=新宿) |

| S:新宿のスペイン料理店ですね。予算の上限はどのくらいですか? | |

| U:4000円くらい | INFORM_MONEY(money=4000円) |

| S:4000円ですね。それではこのお店はどうでしょうか? | |

| S:(店を出す) |

対話行為タイプの推定

言語理解部がユーザが入力したテキストを受け取ったら、対話行為タイプの推定を行います。 今回推定する対話行為タイプは以下の4つです。- ジャンル指定(INFORM_GENRE)

- 場所指定(INFORM_LOC)

- 上限金額指定(INFORM_MONEY)

- その他(OTHER)

今回は受け取ったテキストを形態素解析した後に、特徴抽出を行い、モデルの学習をさせました。

WatsonのNLC使えばもっと楽にできそうです。

属性抽出

言語理解部がユーザが入力したテキストを受け取ったら、属性抽出を行います。 今回抽出する属性は以下の3つです。レストランを検索する際にはこの3つの情報を使います。- 料理ジャンル

- 場所

- 予算上限

Bgenre、Igenre というラベルがこれらの文字列が属性値であることを表現しています。B は属性値の始まり、I は属性値が続いていることを意味しています。属性値でない部分には O というラベルが付与されます。このようにして属性抽出を行います。

今回は受け取ったテキストを形態素解析した後に、特徴抽出を行い、学習をさせました。以前私が書いた【チュートリアル】機械学習を使って30分で固有表現抽出器を作るを見るとできると思います。

ここまでで得られた対話行為タイプと属性を対話行為として次の対話管理部に渡します。

対話管理部

対話管理部では以下の2つのことを行います。- 内部状態更新

- 行動選択

内部状態更新

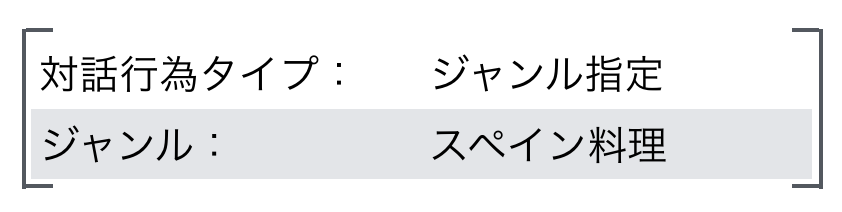

内部状態更新では、言語理解の結果を基に対話システムの内部状態を更新していきます。内部状態の更新は規則を用いて行います。また内部状態には様々な情報を持たせることができますが、今回は簡単のためにユーザの意図だけを持たせます。ユーザの意図とは過去に得られた属性と属性値のことです。それでは内部状態更新の例を見てみましょう。仮に現在の内部状態が以下のようになっているとします。

このとき、言語理解部から以下のような対話行為が得られたとします。

また、以下のような内部状態更新の規則があったとします。

if 対話行為タイプ == ジャンル指定:

ユーザ意図[ジャンル] = スペイン料理

この場合、内部状態は以下のように更新されます。

ジャンル属性の属性値が埋まっていることがわかります。

行動選択

行動選択部では内部状態と規則をもとに次の行動を決定します。 具体的には、対話行為タイプを出力して次の言語生成に引き渡します。 この対話行為タイプをもとに、言語生成部でテキストを生成します。必要なら外部連携部を呼び出します。たとえば、内部状態が以下のようになっていたとします。

また、以下のような行動選択の規則があったとします。

if ユーザ意図[予算上限] == 未指定:

output {対話行為タイプ: 上限金額要求}

このとき、内部状態と行動選択規則から、対話行為タイプとして以下を出力します。

外部連携

外部連携部では、データベース呼び出しや外部API呼び出しを行います。 今回はレストラン検索をするために、外部APIとしてHotPepperグルメサーチAPIを使用しています。 対話を通じて、お店の場所、料理ジャンル、上限金額が得られたらAPIを使ってレストラン検索を行います。言語生成

言語生成部では、規則と対話管理部から受け取った対話行為をもとに言語生成を行います。 たとえば、対話管理部から以下のような対話行為を受け取ったとします。

また、以下のような言語生成の規則があったとします。

if 対話行為タイプ == 上限金額要求:

output 予算の上限はどのくらいですか?

このとき、規則と受け取った対話行為タイプから「予算の上限はどのくらいですか?」という文を生成してユーザに提示します。

以上が言語生成部で行っていることです。

完成したシステム 「HotPepperGourmetDialogue」

完成したシステムは「HotPepperGourmetDialogue」と名付けました。 以下のGIF画像のように動作します。

どうでしょう?簡単なシステムですが動くと嬉しいものです。

ソースコード

以下のリポジトリからソースコードをダウンロードして動かすことができます。 スターつけていただけるとやる気がでますm(__)mおわりに

今回は対話を通じてレストラン検索を行う簡単な対話システムを作成してみました。作成したシステムはコマンドラインで動作するテキストベースのアプリケーションでしたが、媒体としては、ChatBotやVirtual Agent、Pepperのようなロボットと組み合わせてもいいですし、技術としては画像処理、動画処理やタブレットからの入力と組み合わせてマルチモーダル化したりすることもできると思います。今後の課題としては以下の点が挙げられます。

- 入力エラーへの対応

- 学習データ収集方法

- 評価方法

今回の解説が何かのお役に立てれば幸いです。